类目筛选

降本 60%!小熊油耗使用阿里云 SAE 更加稳定可靠

小熊油耗在进行架构升级时,进行了广泛的市场调研,深入分析了国内多家云服务商。经过对比多种 IaaS 层云主机方案及 Serverless 产品的部署策略,他们最终选择了阿里云Serverless 应用引擎 SAE。小熊油耗认为,阿里云能给他们提供更强的安全感,安全感来自于阿里云是一个更大的平台:历史最悠久,用户最多、产品最丰富、配套工具众多、技术支持体系成熟,阿里云 SAE,不仅在稳定性上表现卓越,在细粒度的成本控制和极致的弹性能力上表现也非常出色,而且免运维,完美契合了小熊油耗作为一家细分领域小而美的公司的需求。

大模型无缝切换,QwQ-32B和DeepSeek-R1 全都要

通义千问最新推出的QwQ-32B推理模型,拥有320亿参数,性能媲美DeepSeek-R1(6710亿参数)。QwQ-32B支持在小型移动设备上本地运行,并可将企业大模型API调用成本降低90%以上。本文介绍了如何通过Higress AI网关实现DeepSeek-R1与QwQ-32B之间的无缝切换,涵盖环境准备、模型接入配置及客户端调用示例等内容。此外,还详细探讨了Higress AI网关的多模型服务、消费者鉴权、模型自动切换等高级功能,帮助企业解决TPS与成本平衡、内容安全合规等问题,提升大模型应用的稳定性和效率。

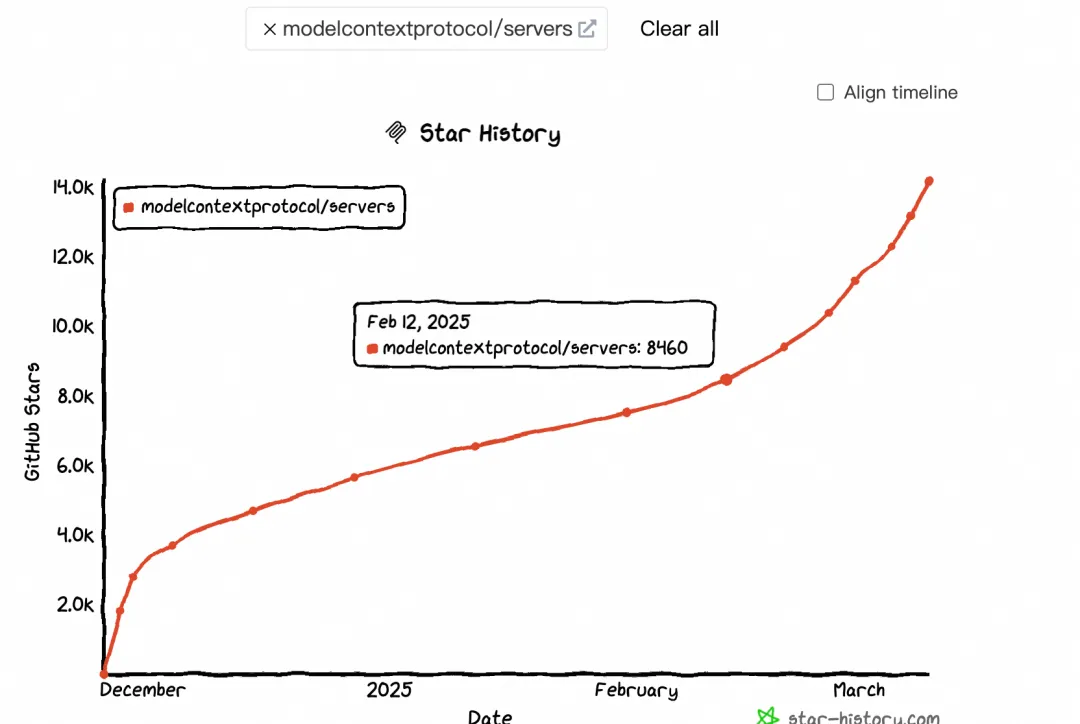

大模型上下文协议 MCP 带来了哪些货币化机会

本文探讨了MCP(Model-Calling Protocol)的兴起及其对AI生态的影响。自2月中旬起,MCP热度显著提升,GitHub Star和搜索指数均呈现加速增长趋势。MCP通过标准化协议连接大模型与外部工具,解决了碎片化集成问题,推动AI应用货币化及生态繁荣。文章分析了MCP与Function Calling的区别,指出MCP更适用于跨平台、标准化场景,而Function Calling在特定实时任务中仍具优势。此外,MCP促进了 supply端(如云厂商、大模型、中间件服务商)和消费端(终端用户)的变革,尤其以Devin和Manus为代表,分别改变了程序员和普通用户的交互方式。

基于 EventBridge 构筑 AI 领域高效数据集成方案

本文深入探讨了AI时代数据处理的变革与挑战,分析了事件驱动架构(EventBridge)在AI数据处理中的技术优势,并结合实践案例,展示了其在多源数据接入、向量数据库优化、智能数据转换等方面的应用价值。

从零开始使用 ROS CDK 搭建云上解决方案

本文介绍了如何使用阿里云ROS资源编排服务快速部署和管理云资源。主要内容包括:1. 工具准备:安装ROSCDK,选择合适的代码编辑器和IDE,安装AI代码生成插件等。2. 环境准备:创建工程目录,进入虚拟环境,配置阿里云凭证信息,配置ROSCDK。3. 代码编写:根据文档描述,编写ROS代码来创建VPC、VSwitch、ECS等资源。4. 运行代码:执行ROS代码,创建ECS实例并部署FTP服务。总体来说,本文通过简单的步骤,让小白也能快速上手使用ROS资源编排服务,实现自动化部署和管理阿里云资源。

使用KMS为MSE-Nacos敏感配置加密的最佳实践

本文主要介绍通过KMS密钥管理服务产生的密钥对敏感的AK等数据进行加密之后可以有效解决泄漏带来的安全风险问题,其次通过KMS凭据托管的能力直接将MSE的主AK进行有效管理,保障全链路无AK的业务体验,真正做到安全、可控。

深度剖析 RocketMQ 5.0,消息进阶:如何支撑复杂业务消息场景?

本文主要学习 RocketMQ 的一致性特性,一致性对于交易、金融都是刚需。从大规模复杂业务出发,学习 RocketMQ 的 SQL 订阅、定时消息等特性。再从高可用的角度来看,这里更多的是大型公司对于高阶可用性的要求,如同城容灾、异地多活等。

新一代端侧模型,面壁 MiniCPM 2.0开源,魔搭社区最佳实践

MiniCPM-V 2.0 不仅带来优秀端侧多模态通用能力,更带来惊艳的 OCR 表现。通过自研的高清图像解码技术,可以突破传统困境,让更为精准地识别充满纷繁细节的街景、长图在端侧成为可能。

LISA微调技术解析:比LoRA更低的显存更快的速度

LISA是Layerwise Importance Sampling for Memory-Efficient Large Language Model Fine-Tuning的简写,由UIUC联合LMFlow团队于近期提出的一项LLM微调技术,可实现把全参训练的显存使用降低到之前的三分之一左右,而使用的技术方法却是非常简单。