类目筛选

破解 vLLM + DeepSeek 规模化部署的“不可能三角”

vLLM 是一种便捷的大型语言模型(LLM)推理服务,旨在简化个人和企业用户对复杂模型的使用。通过 vLLM,用户可以轻松发起推理请求,享受高效、稳定的 LLM 服务。针对大规模部署 vLLM 的挑战,如大模型参数量、高效推理能力和上下文理解等,阿里云函数计算(FC)提供了 GPU 预留实例闲置计费功能,优化了性能、成本和稳定性之间的平衡。此外,FC 支持简便的部署流程和多种应用集成方式,帮助企业快速上线并管理 vLLM 服务。总结来说,vLLM 结合 FC 的解决方案为企业提供了强大的技术支持和灵活的部署选项,满足不同业务需求。

开源 Remote MCP Server 一站式托管来啦!

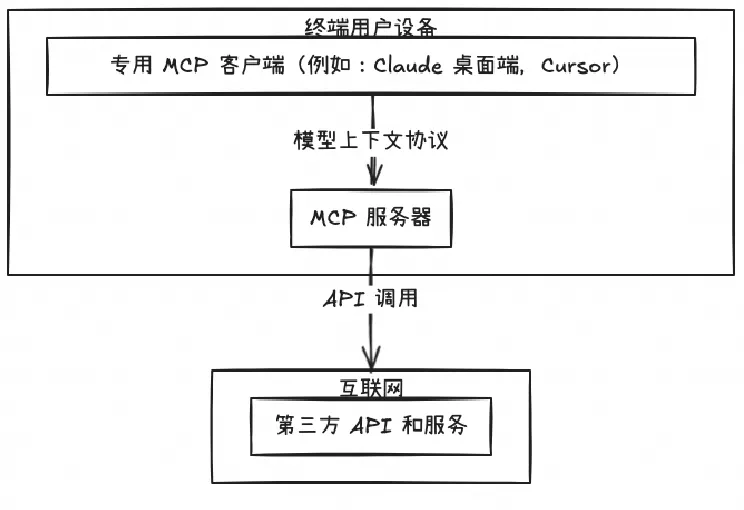

MCP Server 的实施存在着诸多挑战,特别是在认证授权、服务可靠性和可观测性方面,Higress 作为 AI 原生的 API 网关,提供了完整的开源 MCP Server 托管解决方案,实现存量 API 到 MCP 的协议转换。即将上线的 MCP 市场,将大幅降低开发者构建 MCP Server 的时间和人力成本。

IngressNightmare:Ingress Nginx 再曝5个安全漏洞,可接管你的 K8s 集群

是否还记得 2022 年 K8s Ingress Nginx 披露了的 3 个高危安全漏洞(CVE-2021-25745, CVE-2021-25746, CVE-2021-25748),并在那一年宣布停止接收新功能 PR,专注修复并提升稳定性。

Vibecoding 新体验:实测 Qwen3 Coder 代码生成效果

Qwen3 Coder 是全球领先的开源编程大模型,具备强大的代码生成能力与1M超长上下文支持,适用于构建复杂应用。本文通过实际案例展示其在电商网站开发中的应用,并详解提示词设计、技术拆解与部署方案,探讨Agentic AI落地的挑战与经验。

提升团队工程交付能力,从“看见”工程活动和研发模式开始

本文从统一工程交付的概念模型开始,介绍了如何将应用交付的模式显式地定义出来,并通过工具平台落地。

AI 创业及变现新思路:零门槛 AI 绘图,定制 ComfyUI Serverless API 应用

为了帮助用户高效率、低成本应对企业级复杂场景,本文介绍 ComfyUI API Serverless 版解决方案,通过使用该方案,用户可以充分利用 ComfyUI +Serverless 技术优势快速开发上线 AI 绘画应用,期待为广大开发者 AI 绘画创业及变现提供思路。

最佳实践:通义灵码生成单元测试,让单测更简单

本文首先讲述了什么是单元测试、单元测试的价值、一个好的单元测试所具备的原则,进而引入如何去编写一个好的单元测试,通义灵码是如何快速生成单元测试的。

AI场景下的对象存储OSS数据管理实践

本文介绍了对象存储(OSS)在AI业务中的应用与实践。内容涵盖四个方面:1) 对象存储作为AI数据基石,因其低成本和高弹性成为云上数据存储首选;2) AI场景下的对象存储实践方案,包括数据获取、预处理、训练及推理阶段的具体使用方法;3) 国内主要区域的默认吞吐量提升至100Gbps,优化了大数据量下的带宽需求;4) 常用工具介绍,如OSSutil、ossfs、Python SDK等,帮助用户高效管理数据。重点讲解了OSS在AI训练和推理中的性能优化措施,以及不同工具的特点和应用场景。