类目筛选

通过 MCP 构建企业级数据分析 Agent

本文介绍了使用阿里云实时数仓 Hologres、函数计算 FC 和通义大模型 Qwen3 构建企业级数据分析 Agent 的方法。通过 MCP(模型上下文协议)标准化接口,解决大模型与外部工具和数据源集成的难题。Hologres 提供高性能数据分析能力,支持实时数据接入和湖仓一体分析;函数计算 FC 提供弹性、安全的 Serverless 运行环境;Qwen3 具备强大的多语言处理和推理能力。方案结合 ModelScope 的 MCP Playground,实现高效的服务化部署,帮助企业快速构建跨数据源、多步骤分解的数据分析 Agent,优化数据分析流程并降低成本。

阿里云 SLS 多云日志接入最佳实践:链路、成本与高可用性优化

本文探讨了如何高效、经济且可靠地将海外应用与基础设施日志统一采集至阿里云日志服务(SLS),解决全球化业务扩展中的关键挑战。重点介绍了高性能日志采集Agent(iLogtail/LoongCollector)在海外场景的应用,推荐使用LoongCollector以获得更优的稳定性和网络容错能力。同时分析了多种网络接入方案,包括公网直连、全球加速优化、阿里云内网及专线/CEN/VPN接入等,并提供了成本优化策略和多目标发送配置指导,帮助企业构建稳定、低成本、高可用的全球日志系统。

大语言模型推理提速,TensorRT-LLM 高性能推理实践

大型语言模型(Large language models,LLM)是基于大量数据进行预训练的超大型深度学习模型,本文主要讲述TensorRT-LLM利用量化、In-Flight Batching、Attention、Graph Rewriting提升 LLM 模型推理效率。

一键开启 GPU 闲置模式,基于函数计算低成本部署 Google Gemma 模型服务

本文介绍如何使用函数计算 GPU 实例闲置模式低成本、快速的部署 Google Gemma 模型服务。

通过实验深入了解 TCP 数据的发送和接收

本系列文章是组内写给新人和实习生的 TCP入门系列教程,结合了理论和实践,本篇为第二篇,建议先读上篇《通过实验深入了解TCP 连接的建立和关闭》。

跟着iLogtail学习容器运行时与K8s下日志采集方案

iLogtail 作为开源可观测数据采集器,对 Kubernetes 环境下日志采集有着非常好的支持,本文跟随 iLogtail 的脚步,了解容器运行时与 K8s 下日志数据采集原理。

Serverless GPU:助力 AI 推理加速

近年来,AI 技术发展迅猛,企业纷纷寻求将 AI 能力转化为商业价值,然而,在部署 AI 模型推理服务时,却遭遇成本高昂、弹性不足及运维复杂等挑战。本文将探讨云原生 Serverless GPU 如何从根本上解决这些问题,以实现 AI 技术的高效落地。

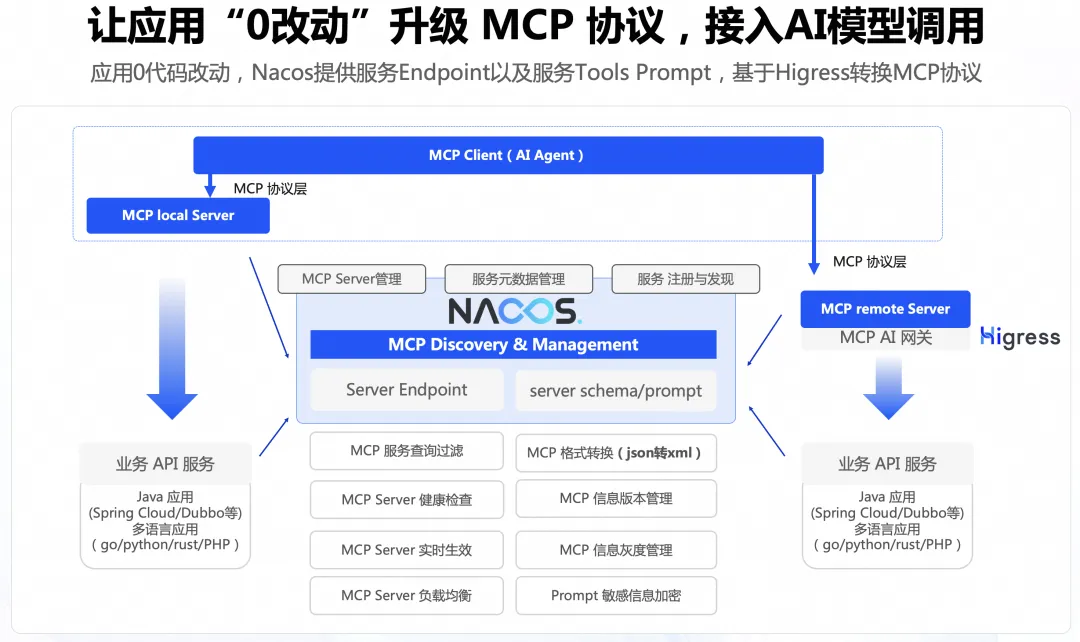

0代码将存量 API 适配 MCP 协议

本文主要讲述通过 Nacos+Higress 的方案实现0代码改造将 Agent 连接到存量应用,能够显著降低存量应用的改造成本。