大数据计算MaxCompute这个帮忙看一下?

我们这边现在的模式是:T-2的历史全量数据 (前天)+ T-1的变化数据 (昨天) = T-1的全量数据 (昨天) 前天的全量历史数据存在于T-2的分区, 昨天的变化数据存在 变化表的 T-1日分区, 然后做了一个 合并节点 写sql合并历史数据和变化数据写入昨天的分区

然后看到odps这边新上来一个Delta Table, 刚刚看了文档,有几个问题想咨询下:

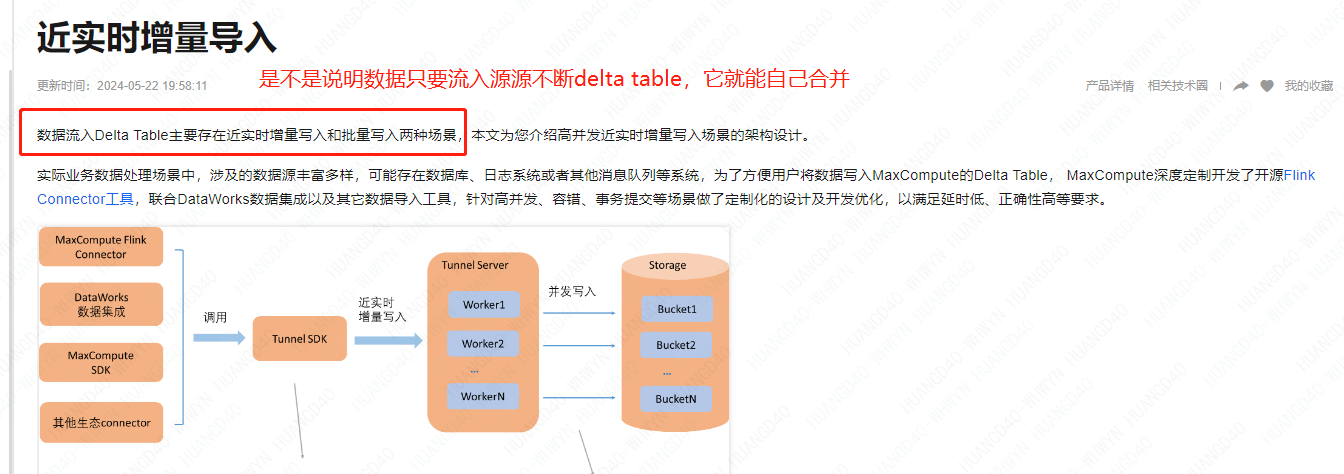

1、delta table 是不是能自动合并历史数据和变化数据,也就是 我上面说的 合并节点 就不用自己写了

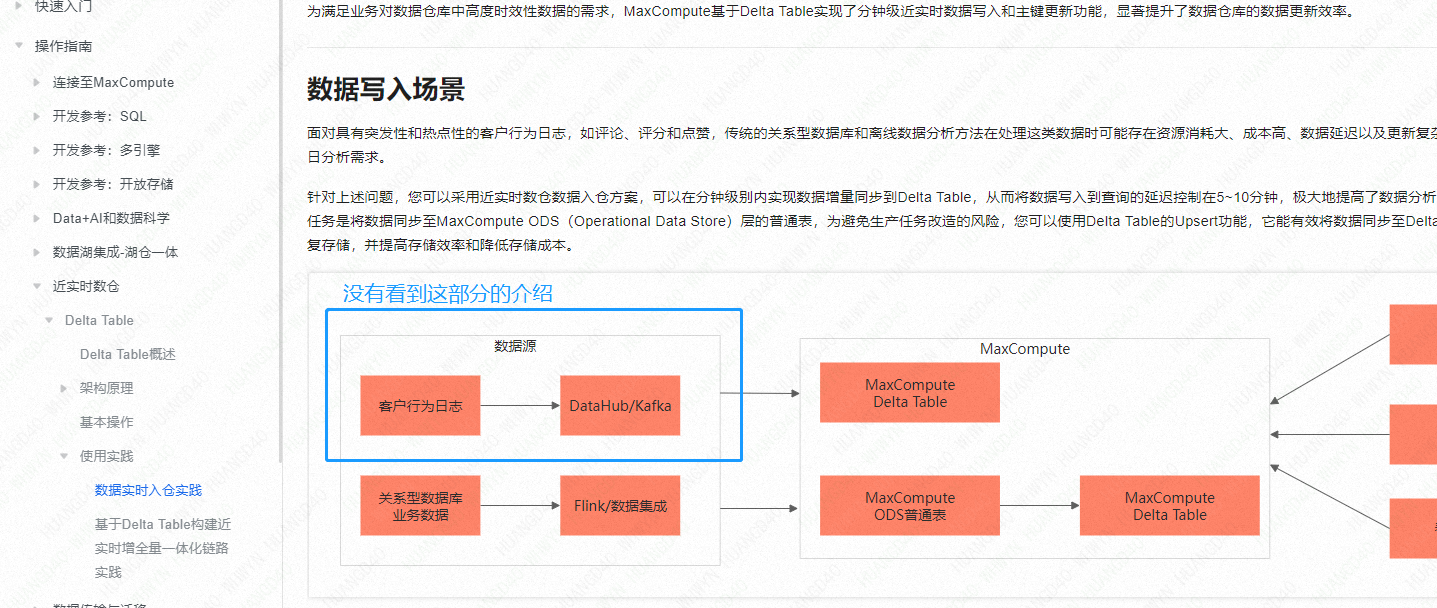

2、我这边现状是 :已有一个数据源是datahub, datahub能自动同步数据到odps, 得到一个binlog变化日志表, 然后我不知道怎么用datahub接这个delta table,以及首次历史数据我咋处理因为这中间老有个时间差 因为文档里只看到flink的介绍

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

1、delta table支持主键、upsert场景,所以直接从MySQL用DataWorks整库实时,或者Flink可以直接监控MySQL binlog ,数据会近实时反馈在delta table数据上。

2、datahub还不支持。 你有MySQL吗

https://help.aliyun.com/zh/dataworks/user-guide/real-time-synchronization-of-the-entire-mysql-database-to-maxcompute?spm=a2c4g.11186623.0.i61

此回答整理自钉群“MaxCompute开发者社区1群”

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。