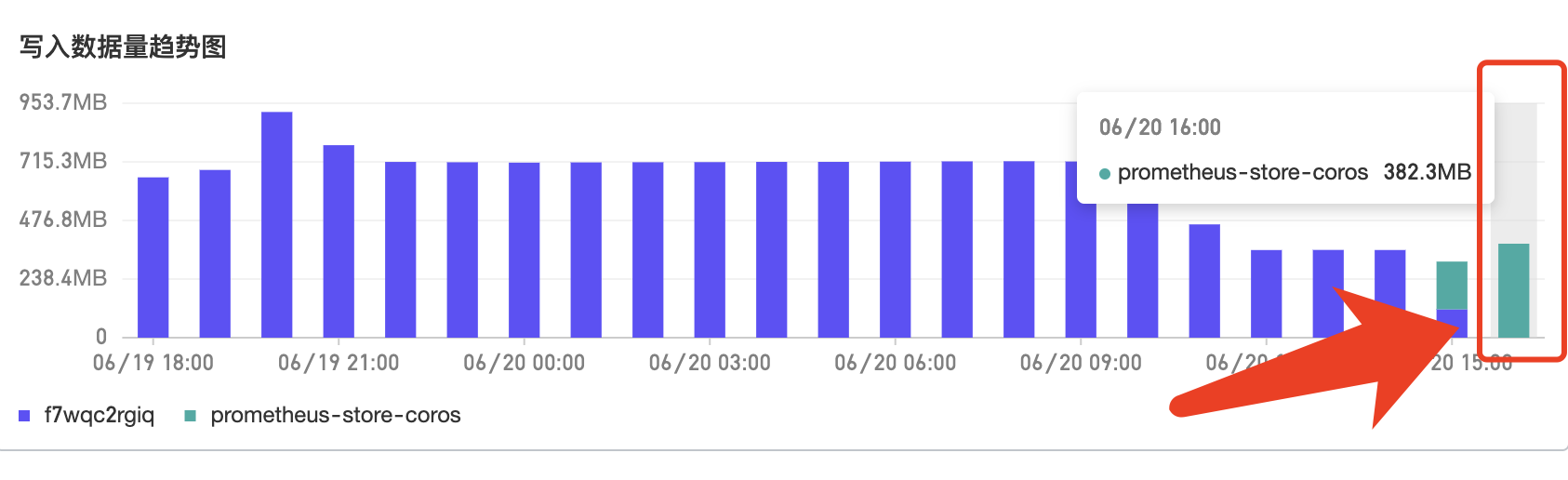

我这边的prometheus只存了2天的数据,prometheus_tsdb_storage_blocks_bytes=90M,也就是平均每天45M的存储开销。prometheus数据使用remoteWrite机制上报到阿里云,为啥这里的写入量居然到了1小时三百多M?感觉超出好多。"写入Prometheus的实际指标量" 跟prometheus tsdb。

阿里云ARMS这两个差这么多吗?是不是没进行数据压缩啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个存储侧的压缩策略;写入量是计算的实际的量; 数据链路接收到的promehtues指标量数据,而不是底层的influxdb的存储量;统计口径是写入链路里实现的。底层的压缩比是存储层策略,可观测还需要cover成本的,考虑的是数据处理量以及写入量的规模; 此回答整理自钉群“ARMS免费试用5群”

云原生可观测基于Prometheus、Grafana 、OpenTelemetry 等核心产品, 形成指标、链路存储分析、异构数据源集成的数据层, 通过标准PromQL和SQL提供大盘展示、告警与探索能力。