flink-cdc这个怎么配置和mysql才能保持一致?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

有这几个方法:

确保MySQL的binlog配置:Flink CDC依赖于MySQL的binlog来捕获数据变更,因此需要确保MySQL实例已经开启了binlog,并且binlog格式与Flink CDC兼容。例如,使用ROW格式能够提供行级别的变更事件 。

创建具有适当权限的MySQL用户:需要为Flink CDC创建一个具有足够权限的MySQL用户,通常需要SELECT、REPLICATION SLAVE、REPLICATION CLIENT等权限,以便能够读取数据库和binlog数据 。

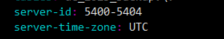

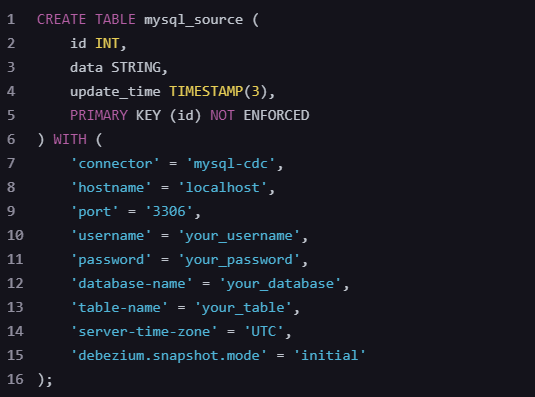

配置Flink CDC Connector:在Flink作业中配置MySQL CDC Connector,需要指定数据库连接信息、要监控的数据库和表、以及其他相关配置项,如server-id用于确保每个Flink CDC任务的Source reader具有唯一的ID 。

使用增量快照算法:Flink CDC使用增量快照算法来避免在快照读取期间对数据库加锁,从而无需RELOAD权限。该算法支持并发读取、chunk粒度的checkpoint,以及无锁读取

Flink CDC Connector 是一个用于从数据库中捕获变更数据(Change Data Capture, CDC)的 Flink 连接器。要配置 Flink CDC Connector 以与 MySQL 保持一致,你需要按照以下步骤进行操作:

首先,确保在你的 Flink 项目中添加了 Flink CDC Connector 的依赖。在 Maven 的 pom.xml 文件中添加以下依赖:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>版本号</version> <!-- 请替换为实际的版本号 -->

</dependency>

确保 MySQL 数据库配置了二进制日志(binlog),因为 Flink CDC Connector 依赖于 binlog 来捕获数据变更。

my.cnf 或 my.ini 中添加以下配置:[mysqld]

server-id = 1

log-bin = mysql-bin

binlog-format = ROW

binlog-row-image = FULL

expire_logs_days = 7

max_binlog_size = 512M

CREATE USER 'flinkuser'@'localhost' IDENTIFIED BY 'password';

GRANT SELECT, REPLICATION CLIENT, REPLICATION SLAVE ON *.* TO 'flinkuser'@'localhost';

FLUSH PRIVILEGES;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

import org.apache.flink.table.api.TableResult;

public class MySqlCdcExample {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 定义 MySQL CDC 连接器源表

String sourceDDL = "CREATE TABLE mysql_binlog (" +

" id INT NOT NULL," +

" name STRING," +

" age INT," +

" PRIMARY KEY (id) NOT ENFORCED" +

") WITH (" +

" 'connector' = 'mysql-cdc'," +

" 'hostname' = 'localhost'," +

" 'port' = '3306'," +

" 'username' = 'flinkuser'," +

" 'password' = 'password'," +

" 'database-name' = 'your_database'," +

" 'table-name' = 'your_table'" +

")";

// 在 Flink 环境中执行 DDL 创建表

tableEnv.executeSql(sourceDDL);

// 查询并输出变更数据

TableResult result = tableEnv.executeSql("SELECT * FROM mysql_binlog");

result.print();

// 执行 Flink 作业

env.execute("Flink CDC Connector to MySQL Example");

}

}

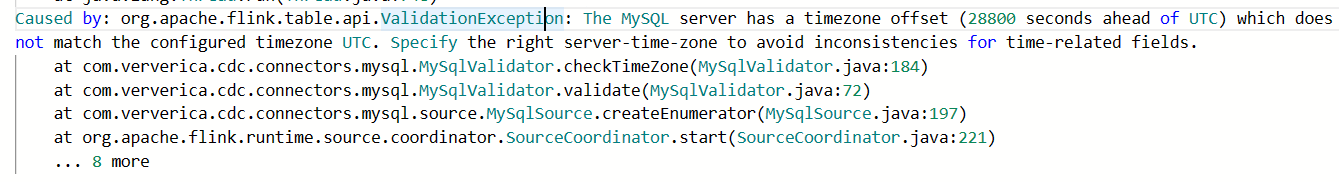

为了使Flink CDC与MySQL的时间设置保持一致,您需要在MySQL服务器上配置正确的时区,并确保您的Flink应用程序也使用相同的时区:

检查MySQL服务器的当前时区:

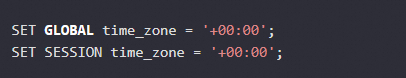

如果MySQL服务器的时区不正确,请将其更改为UTC(协调世界时间):

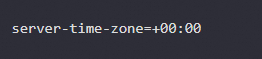

确保MySQL服务器配置文件(通常为my.cnf或my.ini)中的server-time-zone参数设置为UTC。在[mysqld]部分添加以下行:

重启MySQL服务以应用更改。

在您的Flink应用程序中,确保使用与MySQL服务器相同的时区。这可以通过设置execution.timezone Flink配置属性来完成。例如,在flink-conf.yaml中添加以下内容:

重新启动您的Flink任务并检查错误是否已消失。

登录到 MySQL 服务器,执行以下 SQL 命令来获取当前的时区设置:

SHOW VARIABLES LIKE 'time_zone';

然后再配置

Properties properties = new Properties();

properties.setProperty("server-time-zone", "UTC"); // 根据 MySQL 服务器时区设置

还需要监控应用程序的运行情况,并检查日志以确保没有时区相关的错误。

设置时区

SHOW VARIABLES LIKE 'time_zone';

SET GLOBAL time_zone = '+08:00';

Properties properties = new Properties();

properties.setProperty("server-time-zone", "UTC"); // 确保与 MySQL 服务器的时区设置一致

MySqlSource mySqlSource = MySqlSource.builder()

.hostname("yourHostname")

.port(yourPort)

.databaseList("yourDatabase")

.username("yourUsername")

.password("yourPassword")

.deserializer(new JsonRowDataDeserializer(new JsonRowDataSchema(...)))

.properties(properties)

.build();

就好了

Flink-CDC(Change Data Capture)与MySQL的集成配置,旨在确保MySQL数据库中的变更能够实时、准确地同步到Flink中。为了实现这一目标,需要按照以下步骤进行配置:

确保MySQL数据库已经安装并运行,且具备足够的权限配置以支持CDC。

安装并运行Flink集群,确保Flink版本与Flink-CDC Connector兼容。

MySQL配置:

MySQL需要开启binlog(二进制日志),因为Flink-CDC依赖binlog来捕获数据变更。

在MySQL的配置文件(如my.cnf或my.ini)中,设置log_bin和server_id。

重启MySQL服务以使配置生效。

基于Debezium的binlog解析:Flink-CDC利用Debezium来解析MySQL的binlog,确保捕获到所有数据变更。

Flink的容错机制:Flink通过checkpoint机制定期保存状态的快照,并在发生故障时从最近的checkpoint恢复,从而确保状态的一致性。

事件时间处理:Flink支持基于事件时间(Event Time)的窗口操作,可以处理乱序数据,确保数据的顺序性和完整性。

可以使用以下命令设置:

set time_zone='+8:00';

#或者

set persist time_zone='+8:00';

#再次查看

show variables like '%time_zone%';

+------------------+--------+

| Variable_name | Value |

+------------------+--------+

| system_time_zone | UTC |

| time_zone | +08:00 |

+------------------+--------+

——参考链接。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。