根据您提供的报错信息“离线同步”,结合知识库中的相关资料,以下是可能导致该问题的原因及解决方案:

1. 任务运行时间过长

- 可能原因:

- 前置语句(如

preSql)或后置语句(如postSql)在数据库中执行耗时过长,导致任务运行缓慢。

- 未合理配置切分键(

splitPk),导致任务无法有效利用并发能力。

- 解决方案:

- 如果使用了前置或后置语句,建议对涉及的字段添加索引以优化查询性能。

- 配置合理的切分键。例如,对于MySQL Reader插件:

- 推荐使用表主键作为切分键,因为主键通常分布均匀。

- 切分键仅支持整型数据,不支持字符串、浮点和日期类型。如果未配置切分键或配置了非支持类型,任务将使用单通道同步。

2. 等待数据集成任务执行资源

- 可能原因:

- 当前任务运行所使用的独享数据集成资源组剩余可运行的并发数不足,导致任务长时间处于

WAIT状态。

- 解决方案:

- 检查当前资源组的并发使用情况,确保有足够的资源供任务运行。

- 如果资源不足,可以切换到其他资源组。您可以在DataStudio中修改数据集成任务调试所用的资源组,或在运维中心修改任务调度时所使用的资源组。

3. 脏数据问题

- 可能原因:

- 数据写入目标数据源时发生异常,导致部分数据被标记为脏数据。

- 脏数据条数超过允许的阈值,任务失败退出。

- 解决方案:

- 检查任务配置中是否允许脏数据产生,并设置合理的脏数据条数限制。

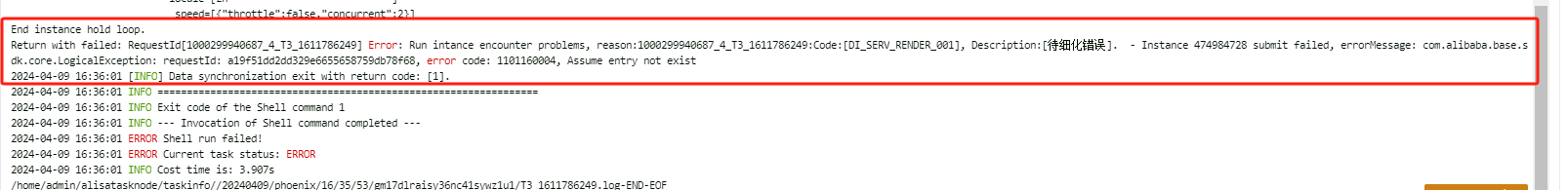

- 如果任务失败,查看日志定位具体的脏数据原因。例如:

- Elasticsearch Reader无法解析

date类型字段的格式,需配置dateFormat参数。

- Kafka Reader读取的数据超出

endDateTime范围,可通过skipExceedRecord配置项控制是否同步超出的数据。

4. 数据源连接或配置问题

- 可能原因:

- 数据源测试连通性成功,但实际任务执行时因权限、网络或其他配置问题导致失败。

- 解决方案:

- 确保数据源的权限配置正确,尤其是涉及公网地址时,需检查是否有额外的流量费用或网络限制。

- 检查任务配置中的字段映射、编码格式等是否与数据源一致。例如,表列名包含关键字可能导致同步失败,需调整字段名或使用转义符。

5. 任务配置不可幂等

- 可能原因:

- 任务配置不能幂等执行,多次运行任务可能导致目标端数据重复或覆盖。

- 解决方案:

- 不建议多次运行同一个任务。如果必须重跑,建议为任务设置监控报警,确保在任务异常时及时处理。

6. 调度参数配置错误

- 可能原因:

- 数据同步任务的调度变量表达式未正确替换,导致数据写出到错误的分区或查询条件不符合预期。

- 解决方案:

- 检查调度参数配置是否符合预期,确保调度时参数替换值正确。

7. 数据类型或时区不一致

- 可能原因:

- 源头表和目标表的数据类型、数据范围或时区不一致,导致数据截断或脏数据问题。

- 解决方案:

- 确认源头和目标表的类型、时区差异,并根据需要调整目标表的配置。

8. 目标端数据发生变化

- 可能原因:

- 目标数据源被其他系统程序访问或更新,导致数据与源头不一致。

- 解决方案:

- 确认目标端数据的变化是否符合业务预期,并记录变化原因。

9. 插件版本问题

- 可能原因:

- 解决方案:

- 提交工单联系技术支持,升级离线引擎插件至最新版本。

10. 其他常见问题

- Kafka同步问题:

- 如果Kafka中数据量少但任务长时间不结束,可能是因为未达到指定的同步结束位点。建议减少分区数量或定时写入心跳记录。

- Elasticsearch同步问题:

- 如果触发乐观锁机制(如

versionconflictengine_exception),建议检查是否有删除数据的行为,并将同步方式从Update改为Index。

总结

以上是可能导致“离线同步”报错的常见原因及解决方案。建议您根据具体报错日志,结合上述分析逐一排查问题。如果问题仍未解决,请提供更详细的报错信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。