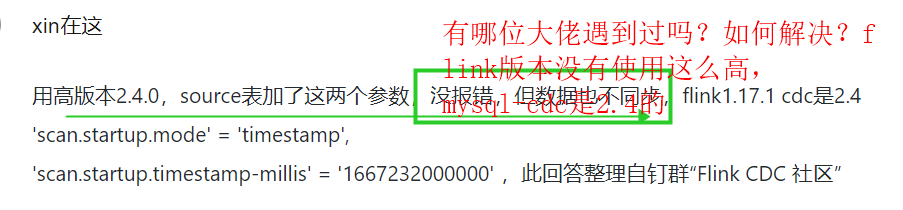

Flink CDC里怎么解决? 我今天试了timestamp,到平台上执行就ok了,本地的估计是不行。checkpoint存储是在hdfs上,所以本地加上ck存储地址会报错无法执行。而且到平台上执行,timestamp开始时间节点的数据不是立马就展示的,而是要等到第1个checkppoint的检查点执行好才会出现。如图展示(timestamp为10点,任务是五分钟ck一次)

我今天试了timestamp,到平台上执行就ok了,本地的估计是不行。checkpoint存储是在hdfs上,所以本地加上ck存储地址会报错无法执行。而且到平台上执行,timestamp开始时间节点的数据不是立马就展示的,而是要等到第1个checkppoint的检查点执行好才会出现。如图展示(timestamp为10点,任务是五分钟ck一次)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的描述,您在本地执行Flink CDC时遇到了问题。首先,确保您的本地环境已经正确配置了Flink CDC和Hadoop相关的依赖。然后,您可以尝试以下方法来解决问题:

flink-conf.yaml),确保Hadoop相关的配置正确。例如:hadoop:

fs.defaultFS: hdfs://localhost:9000

fs.hdfs.impl: org.apache.hadoop.hdfs.DistributedFileSystem

fs.checkpointdir: hdfs://localhost:9000/flink/checkpoints

pom.xml文件中添加以下依赖:<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-hadoop_2.11</artifactId>

<version>1.13.2</version>

</dependency>

StreamExecutionEnvironment创建流处理任务,并设置CheckpointingMode为EXACTLY_ONCE。例如:import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.restartstrategy.RestartStrategies;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.timestamps.BoundedOutOfOrdernessTimestampExtractor;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaProducer;

import org.apache.flink.streaming.connectors.kafka.partitioner.FlinkFixedPartitioner;

import org.apache.flink.streaming.util.serialization.SimpleStringSchema;

public class FlinkCDCExample {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

env.enableCheckpointing(5000); // 每5秒进行一次checkpoint

env.getCheckpointConfig().setCheckpointTimeout(60000); // 设置checkpoint超时时间为60秒

env.setRestartStrategy(RestartStrategies.fixedDelayRestart(3, Time.seconds(10))); // 设置重启策略

// 从Kafka读取数据

FlinkKafkaConsumer<String> kafkaConsumer = new FlinkKafkaConsumer<>(

"input-topic",

new SimpleStringSchema(),

PropertiesUtils.fromProperties(new Properties()));

kafkaConsumer.setStartFromEarliest();

kafkaConsumer.setGroupId("flink-cdc-group");

DataStream<String> inputStream = env.addSource(kafkaConsumer);

// 对数据进行处理

DataStream<String> processedStream = inputStream

.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

return process(value);

}

})

.keyBy((value, timestamp) -> value) // 根据值进行分区

.window(Time.minutes(5)) // 每5分钟一个窗口

.allowedLateness(Time.seconds(10)); // 允许10秒的延迟

// 将处理后的数据写入Kafka

FlinkKafkaProducer<String> kafkaProducer = new FlinkKafkaProducer<>(

"output-topic",

new SimpleStringSchema(),

PropertiesUtils.fromProperties(new Properties()),

new FlinkFixedPartitioner<>(1));

processedStream.addSink(kafkaProducer);

env.execute("Flink CDC Example");

}

private static String process(String value) {

// 在这里实现您的数据处理逻辑

return value;

}

}

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。