Flink CDC数据同步作业开启之后,有没有好的数据对比方案,比较源端和目标端的数据是否一致(数量一致、内容一致等等)?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC进行数据同步作业时,有两种方法可以用于检查源端和目标端的数据一致性:

这个给一个一样的sql求下昨天的全量数据不就知道了,采样求总数,然后给一个逻辑求下的,如果你们源库有last_update_time字段,就比较这个时间和目标库是否一致即可,此回答整理自钉群“Flink CDC 社区”

在开启Flink CDC数据同步作业后,确实存在多种方法可以对比源端和目标端的数据是否一致。

首先,您可以使用基于 Flink SQL CDC 的数据同步方案。Flink CDC Connectors是Apache Flink的一组源连接器,使用变更数据捕获 (CDC) 从不同的数据库中获取变更。通过Flink SQL,您可以方便地对采集到的数据进行各种操作,如过滤、聚合等,并将结果同步到目标端。然后,通过比较源端和目标端的数据统计信息,可以验证数据的一致性。

其次,为了支持海量数据同步的业务场景,Flink CDC采用了分布式架构。因此,如果源端和目标端的数据量非常大,您可以考虑使用更大的窗口来统计数据,以减少计算时间并提高对比效率。

最后,请注意,无论选择哪种对比方案,都需要考虑到一些可能影响数据一致性的因素,例如网络延迟、系统负载等。因此,在进行数据对比时,应充分考虑这些因素,以确保对比结果的准确性。

在Flink CDC数据同步作业开启后,我们可以采用一些方法来检查源端和目标端的数据是否一致。以下是一些可能的方法:

数据正确性验证

数据质量是实时计算数据产出对业务的重要保障,和实时计算任务日常变更一样,迁移工作也需要对新任务产出的数据质量进行验证。通常,建议您采用迁移新任务和原有任务并行双跑的方式,在新运行一段时间,满足数据对比条件后,验证新任务和原有任务的数据产出是否一致,达到预期的数据质量。理想情况下,迁移的新任务数据产出和原任务完全一致,就无需进行额外的差异分析。https://help.aliyun.com/zh/flink/use-cases/migration-solution-1?spm=a2c4g.11186623.0.i193

实时任务7x24小时持续在运行,但在大部分情况下产出的数据还是具备时间周期特性的,这就给数据对比提供了可行性。例如,聚合任务按小时或天维度计算聚合值,清洗任务加工任务按天进行分区等。在数据对比时就可以根据对应的时间周期来进行对比。例如小时周期的任务实际已完整处理数据多个小时后,就可以对比处理过的小时数据,而天维度的聚合值,通常就需要等待新任务处理完完整的一天数据后才能对比。

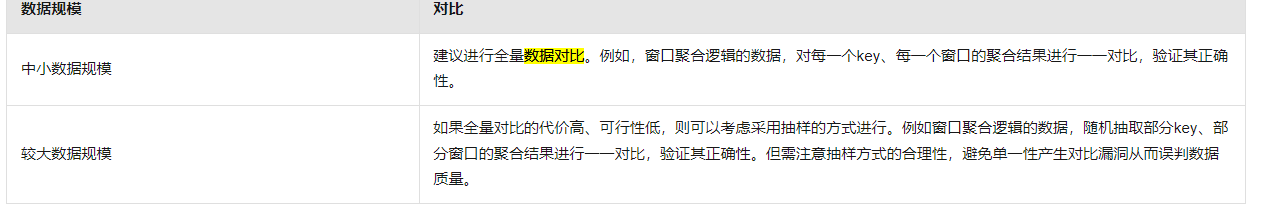

根据任务产出的生成周期特性和数据规模,您可以结合业务的实际情况,使用恰当的对比方法。对比方法详情如下表所示。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。