大数据计算MaxCompute我在配置项里配置好像不生效,这是什么情况?

大数据计算MaxCompute我在配置项里配置 spark.hadoop.odps.cupid.disk.driver.device_size 好像不生效,这是什么情况?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

先设置一下50吧,setproject odps.schema.evolution.enable=true;这个开关打开过吗?如果不确定,odpscmd或者SQL节点执行一下 setproject;select 1;查一下打印里也没有这个参数的设置,那我理解是这个问题。或者换一个spark版本试下,2.4.5的

https://help.aliyun.com/zh/maxcompute/user-guide/partition-and-column-operations-1?spm=a2c4g.11186623.0.i1#section-s3q-3je-mnq,此回答整理自钉群“MaxCompute开发者社区2群”2023-11-12 14:48:53赞同 展开评论 -

在配置大数据计算MaxCompute时,如果您在配置项中设置了

spark.hadoop.odps.cupid.disk.driver.device_size,但发现该配置项没有生效,可能存在以下几种情况:- 配置项名称错误:首先,请确保您在配置项中的名称是正确的。有时候,由于拼写错误或大小写错误,可能会导致配置项没有生效。请仔细检查您在配置文件中的配置项名称是否与正确的名称完全匹配。

- 配置文件未被正确读取:确保您的配置文件被正确读取。在MaxCompute中,配置文件通常位于

~/.odps/cupid/odps_cupid.properties路径下。请确保该文件存在并且被正确读取。 - 配置项的值不符合要求:

spark.hadoop.odps.cupid.disk.driver.device_size这个配置项通常需要一个整数值。请确保您设置的值是一个合法的整数值,并且没有包含任何非法字符或空格。 - 版本兼容性:有时候,由于软件版本之间的兼容性问题,某些配置项可能不会按照预期工作。如果您最近升级了MaxCompute或相关依赖库的版本,可能会导致一些配置项不再适用或失效。请检查您使用的MaxCompute和相关库的版本是否兼容。

- 日志和调试输出:如果以上步骤都没有解决问题,可以尝试查看MaxCompute的日志或调试输出,以获取更多关于配置项不生效的详细信息。这些日志通常位于MaxCompute的安装目录下的日志文件夹中。

2023-11-12 09:40:06赞同 展开评论 -

北京阿里云ACE会长

配置项中设置了

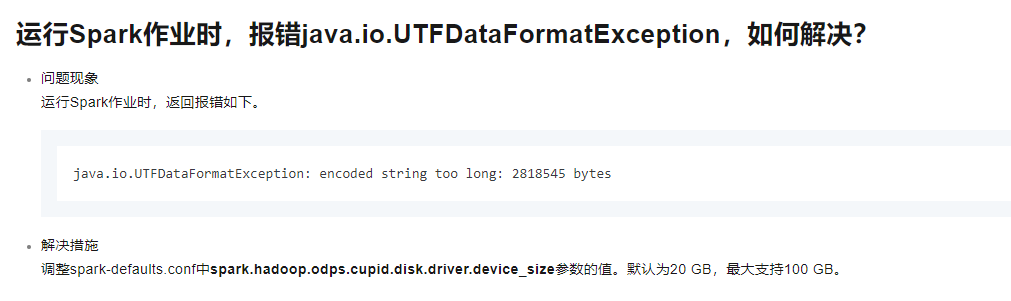

spark.hadoop.odps.cupid.disk.driver.device_size,但似乎没有生效。同时,您在运行 Spark 作业时遇到了java.io.UTFDataFormatException的错误。首先,关于配置项不生效的问题,请确保您在设置配置项时使用了正确的语法。例如:

spark.hadoop.odps.cupid.disk.driver.device_size 512

CopyCopy请确保您在设置配置项时使用了正确的语法和参数。

其次,关于

java.io.UTFDataFormatException的错误,这个错误通常是由于在处理文本数据时使用了错误的编码格式导致的。请检查您的数据源和目标是否使用了正确的编码格式。例如,如果您使用的是一些特定的字符集,如 UTF-8 或 GBK,请确保您的数据源和目标也使用了相同的字符集。2023-11-12 07:51:56赞同 展开评论

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。