我想在本地Spark 通过DataSource 访问Maxcomputer

目前使用的Spark环境为3.1.1,我需要基于Scala_2.12版本构建的DataSource。

或者能提供一个更友好访问MaxComputer的方式。

感激不尽!

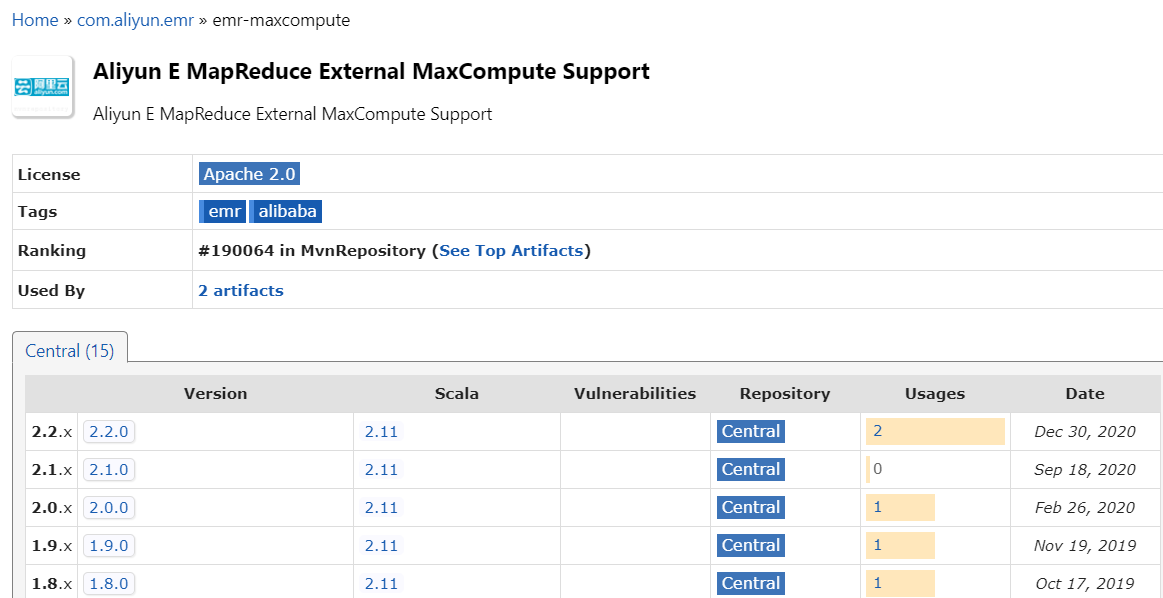

以下是我找到的最高DataSource版本

groupid = com.aliyun.emr

artifactId = emr-maxcomputer_2.11

version 2.20

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您可以使用 EMR MaxCompute DataSource 来访问 MaxCompute 数据库。您可以从 Maven Central 存储库下载所需的 jar 包,如:

<dependency>

<groupId>com.aliyun.emr</groupId>

<artifactId>emr-maxcompute_2.11</artifactId>

<version>2.20</version>

</dependency>

您可以将此依赖项添加到 pom.xml 文件中,并在 Spark 作业中使用 SQLContext 中的相关方法来访问 MaxCompute 数据库。

此外,也可以考虑使用 EMR Shell 或 DataWorks Studio 等工具访问 MaxCompute 数据库。

可以参考阿里云提供的文档来连接 Spark 和 MaxCompute 数据源。以下是具体的步骤:

下载所需 JAR 文件:首先,需要下载对应的 DataSource 扩展 JAR 文件。这里可以前往 Aliyun MaxCompute Data Collector GitHub 仓库下载,目前支持的最高版本是 2.20,支持 Spark 2.4.x 和 Scala 2.11。

添加依赖项:在 Spark 项目的 pom.xml 文件中添加如下依赖项:

<dependency>

<groupId>com.aliyun.emr</groupId>

<artifactId>emr-maxcomputer_${scala.binary.version}</artifactId>

<version>${emr.maxcompute.version}</version>

</dependency>

其中 ${scala.binary.version} 是指 Scala 的版本,${emr.maxcompute.version} 是指 Data Collector 的版本。

设置属性:在 Spark 配置文件(例如 conf/spark-defaults.conf)中添加以下属性:

spark.sql.extensions=com.aliyun.emr.data.collector.datasource.spark.MaxComputeDataSourceRegister

spark.sql.catalogImplementation=hive

这将启用 MaxCompute 数据源注册和 Hive metastore 实现。

导入数据:现在,可以在 Spark 中导入 MaxCompute 表数据,并使用 SQL 查询:

val maxData = spark.read.format("maxcompute")

.option("url","http://...") // MaxCompute endpoint

.option("database","default") // database name

.option("table","my_table") // table name

.option("accessId","your_access_id") // Access ID

.option("accessKey","your_access_key") // Access Key

.load()

注意,Access ID 和 Access Key 需要替换为自己的 MaxCompute 认证信息。

运行查询:现在可以开始编写 Spark SQL 查询,例如:

maxData.createOrReplaceTempView("tmp_view")

spark.sql("SELECT * FROM tmp_view WHERE ...").show()

除此之外,还可以使用 EMR Studio 或者 EMR on-demand 来进行实时数据分析和可视化,这两个产品提供了更为友好的交互式界面。它们可以通过 JDBC 方式连接 MaxCompute 数据源,并使用 SQL 查询。如果您对此感兴趣,请参阅官方文档了解更多详情。

是的,Aliyun DataSource for Spark已经支持Scala 2.12版本。你可以使用以下依赖来在你的Spark项目中引入它:

<dependency>

<groupId>com.aliyun</groupId>

<artifactId>emr-maxcomputer_2.12</artifactId>

<version>最新版本</version>

</dependency>

请注意,你需要将最新版本替换为你需要的具体版本号。你可以在这个页面找到最新的版本号:https://mvnrepository.com/artifact/com.aliyun/emr-maxcomputer_2.12

另外,如果你想更方便地访问MaxComputer,你可以使用阿里云提供的ODPS SDK。这是一个Java库,可以方便地在Java程序中使用。虽然它是用Java编写的,但是你可以通过JNI将其集成到你的Scala程序中。具体的集成方式可以参考SDK的文档:https://help.aliyun.com/document_detail/92574.html

用 Hadoop 提供的 DataSource API:Spark 提供了 Hadoop 数据源 API,可以通过这个 API 访问 Hadoop 上的数据。在本地 Spark 中,你可以使用 Hadoop 的客户端模式来访问 Hadoop 上的数据。具体使用方法可以参考 Spark 官方文档中关于 Hadoop 数据源的介绍。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。