Flink这个问题怎么解决?

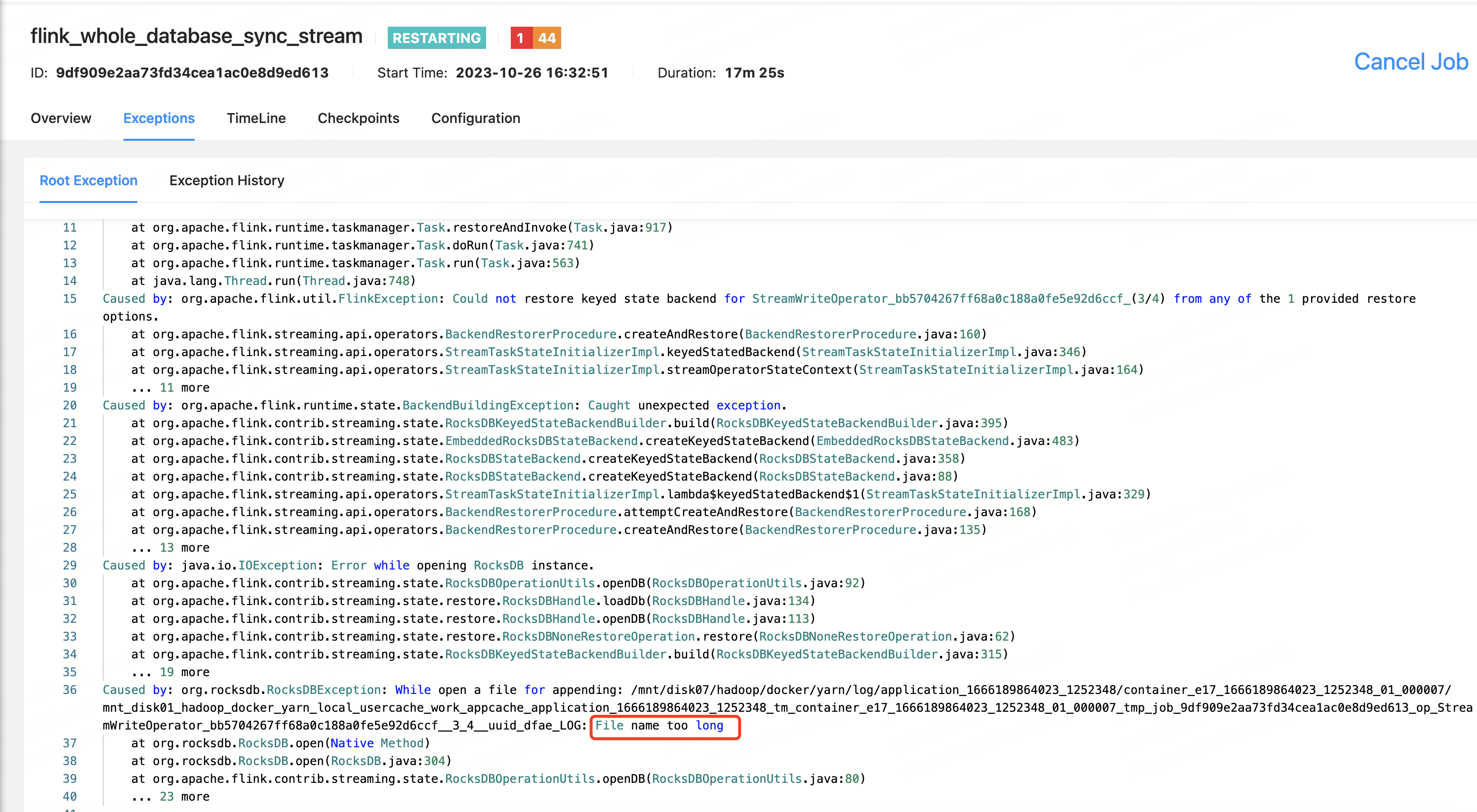

Flink这个问题怎么解决?代码实现mongo数据整库写hudi,采用RocksDBStateBackend状态后端,checkpoint产生的文件名太长报错

-

这个问题可能是因为Flink在进行Checkpoint时,生成的文件名超过了操作系统规定的最大文件名长度。在Linux系统中,文件名的最大长度通常是255字节。

你可以尝试以下几种方法来解决这个问题:

修改文件名:在生成Checkpoint文件时,你可以尝试修改文件名,使其不超过最大文件名长度。例如,你可以使用UUID或其他唯一ID来代替长文件名。

调整Flink配置:在Flink的配置中,你可以设置

state.backend.fs.file-name-prefix参数,用来指定Checkpoint文件的名称前缀。你可以将这个参数的值设置为较短的字符串,以避免文件名过长。使用其他状态后端:如果你在使用RocksDBStateBackend时遇到了这个问题,你可以尝试使用其他的状态后端,如MemoryStateBackend或FsStateBackend。这些状态后端可能会对文件名的长度有更宽松的限制。

增加文件系统的配额:如果你的文件系统支持配额管理,你可以尝试增加文件名长度方面的配额,以允许更长的文件名。

2023-11-02 15:42:45赞同 展开评论 打赏 -

针对 Flink 在采用 RocksDBStateBackend 状态后端时,checkpoint 文件名过长的问题,您可以尝试以下解决方案:

- 使用更短的 job 名称:在 Flink 程序中修改 job 名称,以降低文件路径的长度。

- 使用多级目录结构:您可以更改 checkpoint 的保存路径,将 checkpoint 文件分散到多个层级的目录中,从而避免单一路径太长。

- 使用简化的路径:您可以将 checkpoint 文件保存到相对路径,从而避免复杂绝对路径造成的问题。

- 更改 RocksDBStateBackend 配置参数:可以修改 RocksDBStateBackend 配置文件,以减少 checkpoint 文件名长度。

2023-11-01 21:46:18赞同 展开评论 打赏 -

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。