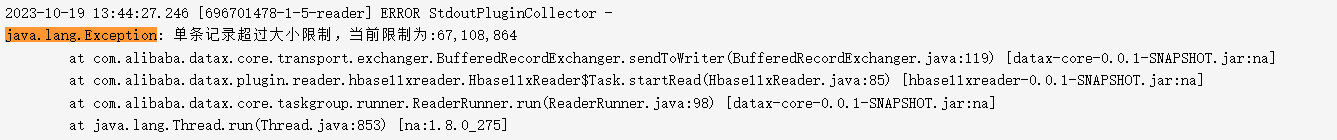

大数据计算MaxCompute我有一个离线同步任务,同步过程中出现脏数据丢失的情况,我想问一下,可以加参数据提高单条记录大小吗?如图:为错误日志

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

对于MaxCompute离线同步任务,您可以提高单条记录的大小。具体来说,MaxCompute支持通过DataWorks数据集成功能将其他数据源数据同步至MaxCompute。在配置离线同步节点的过程中,可以设置相关参数以调整单条记录的大小。请注意,尽管可以提高单条记录的大小,但同时也需要考虑到网络带宽和处理能力等因素,以保证数据的顺利同步和处理效率。

从你提供的错误日志来看,"脏数据丢失"可能是由于数据同步过程中的某些问题导致的,例如网络中断、系统故障等。增加单个记录的大小可能会对数据的同步产生一定影响,但这并不是解决"脏数据丢失"问题的根本方法。

为了解决这个问题,你可以尝试以下几种方法:

优化数据同步过程:检查数据同步的各个环节,确保数据在同步过程中不会被中断或者丢失。例如,你可以增加数据同步任务的容错性,使其能够在网络中断或者其他故障情况下自动恢复。

增加数据备份:定期备份数据,以防止数据丢失。这样即使发生了"脏数据丢失",你也可以从备份中恢复数据。

使用更稳定的数据同步工具:如果可能的话,你可以尝试使用其他更稳定的数据同步工具,以减少数据丢失的可能性。

增加单个记录的大小并不是解决"脏数据丢失"问题的最佳方法。你应该从数据同步过程的优化、数据备份和选择更稳定的数据同步工具等方面来解决问题。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。