求助一下 大佬

目前我遇到的机器学习PAI具体问题是:

每次要使用就打开实例,就可以使用了。

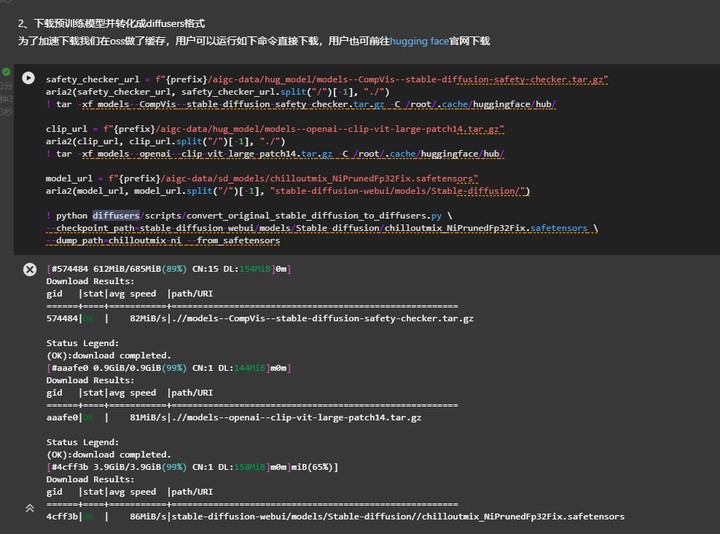

这个大模型了。chilloutmix_NiPrunedFp32Fix.safetensors

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在机器学习PAI中,将模型文件放到实例的JupyterLab中并存储在OSS (Object Storage Service) 中进行缓存是一种常见的做法。这样可以方便地在JupyterLab中使用模型文件,并确保模型在不同的任务之间持久化保存。

当你需要在JupyterLab中使用模型时,可以按照以下步骤进行操作:

将模型文件上传到OSS中。你可以使用机器学习PAI提供的API或者图形界面将模型文件上传到OSS桶中。

在JupyterLab中设置正确的OSS路径,并加载模型文件。首先,确保你已经安装了OSS相关的Python库(例如oss2),然后使用相应的代码来加载模型文件。

import oss2

# 设置OSS的访问凭证信息

access_key_id = 'your_access_key_id'

access_key_secret = 'your_access_key_secret'

endpoint = 'your_oss_endpoint' # 例如:http://oss-cn-hangzhou.aliyuncs.com

# 创建OSS的Bucket对象

bucket_name = 'your_bucket_name'

bucket = oss2.Bucket(oss2.Auth(access_key_id, access_key_secret), endpoint, bucket_name)

# 模型文件在OSS中的路径

model_path = 'oss://your_bucket_name/path/to/model.h5'

# 从OSS中下载模型文件到本地

local_model_path = '/path/to/local_model.h5'

bucket.get_object_to_file(model_path, local_model_path)

# 使用本地的模型文件

model = tf.keras.models.load_model(local_model_path)

在上述代码中,你需要根据实际情况设置正确的OSS访问凭证信息(Access Key ID、Access Key Secret和Endpoint),以及模型文件在OSS中的路径。然后使用 bucket.get_object_to_file() 方法将模型文件下载到本地,并使用 tf.keras.models.load_model() 函数加载模型。

上次到oss后,在同region,如果要用nas,可以通过在线迁移服务,从oss到nashttps://mgw.console.aliyun.com/?spm=5176.28197733.0.0.6cd474fdfBigGI#/source?_k=x58vc9在线迁移服务 旧版 支持oss到nas(同region),此回答整理自钉群“机器学习PAI交流群(答疑@值班)”

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。