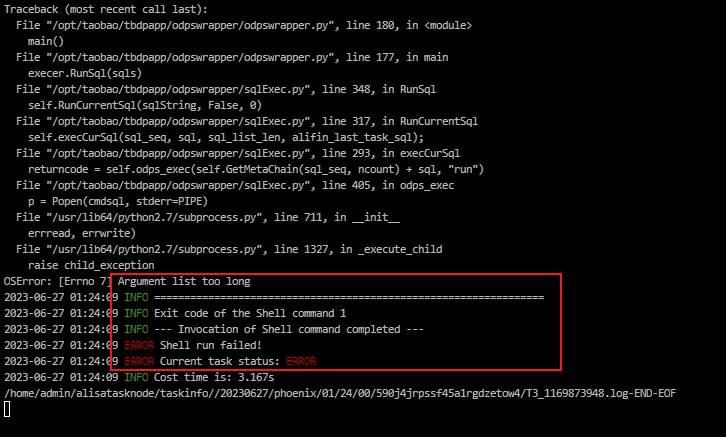

问题1:DataWorks中本地任务运行成功,定时任务运行不起来,显示代码过长是什么原因? 问题2:如果不能拆,有什么办法可以上传运行吗

问题2:如果不能拆,有什么办法可以上传运行吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 DataWorks 中,如果你的本地任务可以成功运行,但定时任务无法正常运行并显示代码过长的错误,可能是由于以下原因之一:

代码长度超过限制:DataWorks 对于任务中的代码长度有一定的限制。如果你的代码过长,超过了平台所允许的长度限制,那么定时任务将无法正常运行。这是为了保证任务的执行效率和稳定性。建议检查你的代码是否过长,如果超过限制,可以尝试优化代码结构或拆分代码逻辑。

依赖库或资源文件过大:如果你的任务涉及到依赖库或资源文件的使用,并且这些文件过大,也可能导致定时任务无法正常运行。在 DataWorks 中,依赖库和资源文件需要上传到平台上进行引用。如果文件过大,可能会导致传输和加载时间过长,从而出现定时任务无法启动的情况。建议检查你的依赖库和资源文件的大小,确保其在平台允许的范围内。

其他原因:除了以上两个原因外,还有其他可能导致定时任务无法正常运行的原因,如权限问题、网络连接等。建议检查你的定时任务的配置和权限是否正确,并确保网络连接正常。

如果你仍然遇到问题,建议联系 DataWorks 的管理员或技术支持团队,并提供详细的错误信息和任务配置,以便他们帮助你解决问题。

希望以上信息能对你有所帮助!如有其他问题,请随时提问。

在DataWorks中,本地任务运行和定时任务运行的执行环境是不同的。本地任务运行是在DataWorks的开发环境中运行,而定时任务运行是在MaxCompute的生产环境中运行。因此,如果在定时任务中出现了代码过长的问题,可能是由于代码中存在一些限制导致的。

在MaxCompute的生产环境中,代码的长度是有限制的,如果代码过长,可能会导致任务无法正常执行或者出现异常。具体的限制取决于MaxCompute的版本和配置,一般情况下,MaxCompute中的代码长度限制为64KB或者128KB。

如果您的代码过长无法在MaxCompute中正常执行,可以尝试以下解决方案:

对代码进行精简:可以对代码进行精简,去掉冗余的代码和注释,从而减小代码的长度。

将代码拆分为多个任务:可以将代码拆分为多个任务,分别运行,从而避免代码过长的问题。

使用UDF或者MapReduce等方式:可以使用UDF或者MapReduce等方式,对代码进行优化,从而减小代码的长度。

在DataWorks中,如果本地任务运行成功,但定时任务运行不起来,并且显示代码过长的原因可能有以下几个方面:

代码长度限制:DataWorks中的定时任务有一定的代码长度限制,如果代码过长可能会影响任务的正常运行。可以尝试缩短代码长度,或者将代码拆分成多个子任务来执行。 定时任务配置:定时任务的配置参数可能不正确,例如任务名称、执行周期、执行时间等。可以检查定时任务的配置信息,确保配置正确。 依赖关系问题:如果定时任务依赖于其他任务或数据源,可能存在依赖关系的问题。可以检查任务之间的依赖关系,确保它们能够按照预期的顺序执行。 系统资源限制:如果定时任务需要消耗大量的计算资源(如CPU、内存等),可能会因为系统资源不足而导致任务无法正常运行。可以尝试调整定时任务的执行参数,或者增加系统的资源分配。 总之,要解决定时任务运行不起来的问题,需要仔细检查代码、配置和系统资源等方面,找到问题的原因并进行相应的调整和优化。同时,可以在DataWorks社区或开发者论坛上寻求帮助,以获得更多的技术支持和建议。

回答1:脚本不能超过128kb 有中文注释之类的可以删减一下 或者拆分成两个任务,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。