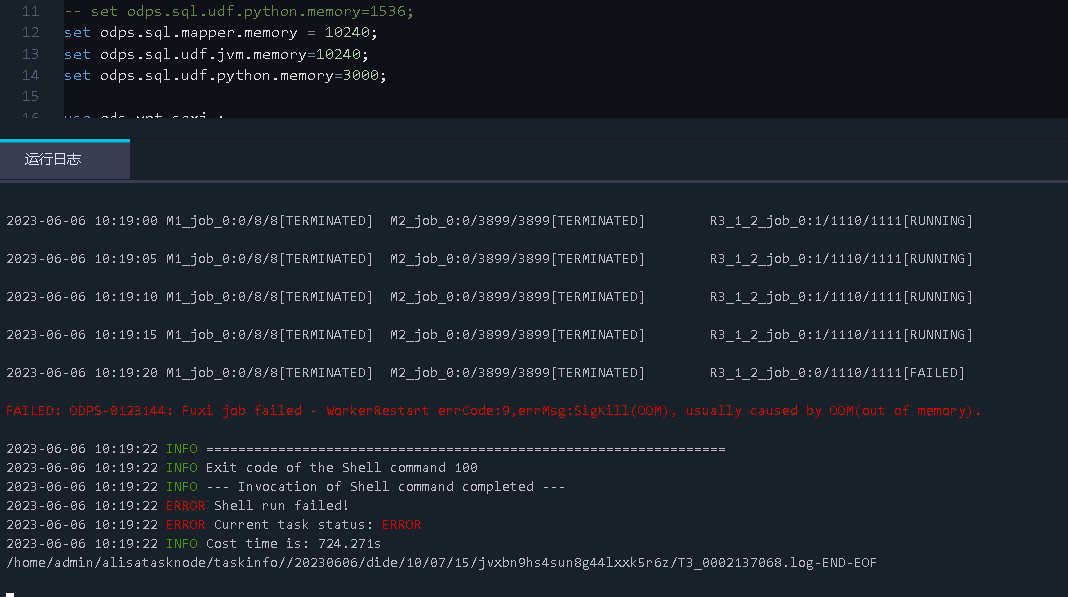

DataWorks中有个sql运行一直报oom,那几个memory的参数都要调满了也没什么用呢,数据量是5772231条,针对这些数据用了ow_number() over函数分组排序?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

由于数据量过大,且使用了ROW_NUMBER() OVER函数进行分组排序,可能导致内存溢出(OOM)的问题。调整内存参数可能会有所帮助,但是并不是完全解决问题的方法。

可以考虑对SQL进行优化,如使用更加高效的排序函数替代ROW_NUMBER() OVER函数,或者对数据进行分批处理,减少单次查询的数据量。另外,可以考虑在DataWorks中使用分布式计算引擎如MaxCompute等进行处理,以分摊计算负担,提高处理效率。

同时,也可以通过查询slow log,分析SQL执行的瓶颈所在,优化查询语句和数据结构,减少不必要的计算和IO操作,从而提高整个查询过程的效率和稳定性。

OOM(Out of Memory)错误通常是由于内存不足导致的。在这种情况下,即使将内存参数调到最大值,也可能无法解决问题。

针对这种情况,你可以尝试以下方法:

如果您的SQL运行一直报OOM (Out of Memory) 错误,即使将DataWorks中的内存参数调整到最大,那么很可能是由于数据量过大而导致的。在处理大数据量的情况下,可能需要使用一些优化技巧来减少内存的使用。

针对您提到的情况,您可以考虑以下优化技巧:

分区:对于大型表,可以使用分区来分割表,将数据分成更小的块来处理。这样可以减少每次处理的数据量,降低内存压力。

列剪裁:只选择需要的列,避免加载和处理不必要的数据,可以减少内存的使用。

适当增加并行度:在DataWorks中,可以通过增加节点数量来提高任务的并行度,减少单个节点的内存使用。

减少排序:ow_number() over函数需要对整个数据集进行排序,这将会导致大量的内存使用。可以尝试减少排序的数据量,或者使用其他更适合的排序方式。

增加JVM参数:在DataWorks中,可以通过在JVM参数中增加-Xmx和-Xms来增加内存空间。但是,这种方式并不能解决所有内存问题,因为内存使用的上限还受到其他因素的限制。

内存溢出(OOM)通常是由于查询所需的内存超过了限制而导致的。针对您的查询,有几个方法可以尝试解决这个问题:

增加JVM内存:您可以尝试增加DataWorks中JVM的内存限制。这可以通过编辑DataWorks服务器上的 nohup.out 文件来完成。打开该文件并查找以下行:

JVM_ARGS="-Xms512m -Xmx512m" 将 -Xmx512m 修改为您希望分配的更大内存值,例如 -Xmx4g。保存文件并重新启动DataWorks服务器。

减少数据量:如果可能的话,尝试减少数据量以减少查询所需的内存。您可以考虑使用采样数据集代替完整数据集,或者尝试使用更高效的数据结构和算法来处理数据。

优化查询:尝试优化您的查询以减少所需的内存。您可以尝试优化 ow_number() over 函数,例如使用 row_number() 函数代替。您还可以尝试使用更高效的数据访问模式,例如使用谓词 WHERE 和 ORDER BY 来过滤和排序数据。

增加Pheonix数据库内存:如果您的Pheonix数据库正在运行时出现内存溢出错误,您可以尝试增加Pheonix数据库的内存限制。这可以通过编辑Pheonix数据库配置文件来完成。打开该文件并查找以下行:

phoenix.spillover-threshold-mb phoenix.query-parallelism

将 phoenix.spillover-threshold-mb 修改为您希望分配的更大内存值,例如 1g。保存文件并重新启动Pheonix数据库。

请注意,这些方法可能不适用于所有情况,具体取决于您的数据集和查询。因此,您可能需要尝试不同的方法并测试它们的效果。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。