今天一堆离线同步导出的任务报错,失败了100多个任务全是导入导出的离线同步任务 clickhouse es都有?

今天一堆离线同步导出的任务报错,失败了100多个任务全是导入导出的离线同步任务 clickhouse es都有?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果DataWorks中的离线同步导出任务都报错了,可能是由于以下原因导致的:

数据源或目标表结构发生变化:如果您的数据源或目标表结构发生了变化,例如字段类型、字段名称、表名等,可能会导致离线同步任务失败。建议检查一下数据源和目标表是否发生了变化,如果有变化需要及时更新同步任务配置。

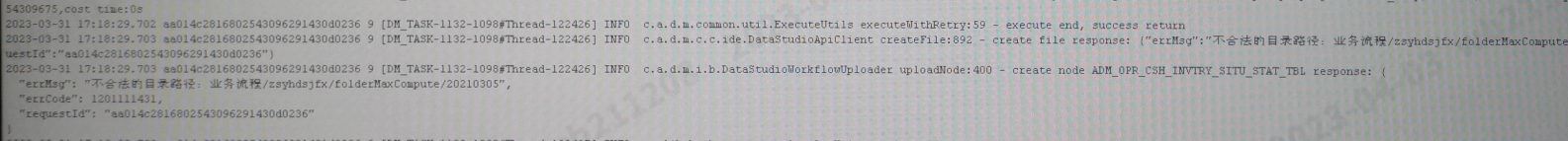

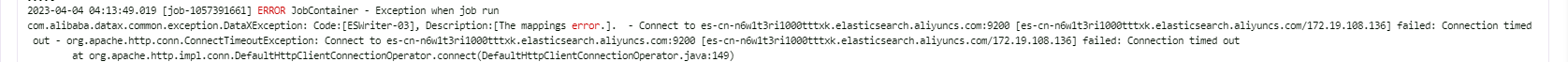

数据同步过程中发生异常:如果数据同步过程中发生了异常,例如网络中断、数据源宕机、目标表空间不足等,也会导致离线同步任务失败。建议检查一下同步任务执行过程中的日志,查看是否有异常信息。

数据量过大:如果同步的数据量过大,可能会导致离线同步任务失败。建议检查一下同步任务的数据量是否超过了系统的限制,如果超过了限制需要调整同步任务的配置。

服务端故障:如果DataWorks服务端发生故障,可能会导致离线同步任务失败。建议联系DataWorks的技术支持人员,查看是否有服务端故障的情况。

建议您先检查一下同步任务的配置和日志,找出具体的失败原因,然后根据具体情况进行调整或联系技术支持人员解决问题。

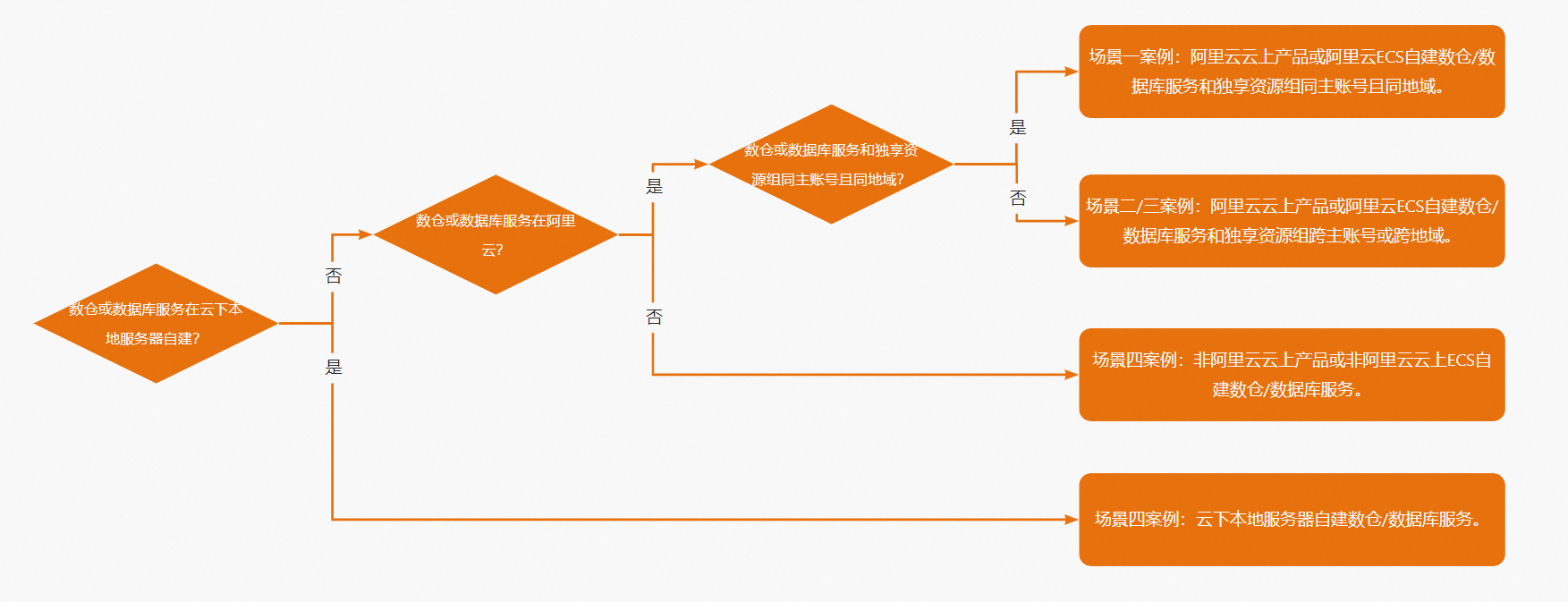

"都是网络不通 先在右上角-小扳手-数据源界面 测一下数据集成联通性看下 网络链路可能有被改动过 。 【网络打通解决方案】 >选择网络连通方案文档 step1:选择网络打通方式  在配置资源组与网络连通文档中搜索对应的场景,并参考案例图示打通。

在配置资源组与网络连通文档中搜索对应的场景,并参考案例图示打通。

云企业网使用场景示例,请参见云企业网。 高速通道使用场景示例,请参见高速通道。 VPN网关使用场景示例,请参见VPN网关。 net_read_timeout:datax将mysql根据splitpk对mysql的数据进行拆分成数条等量的取数sql(select取数语句),执行时某条sql执行时间超过rds侧允许的最大运行时间。 net_write_timeout:等待将一个block发送给客户端的超时时间过小导致。 只能优化sql、减少数据或者在源端继续增加参数值此答案整理自钉群“DataWorks交流群(答疑@机器人)”"

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。