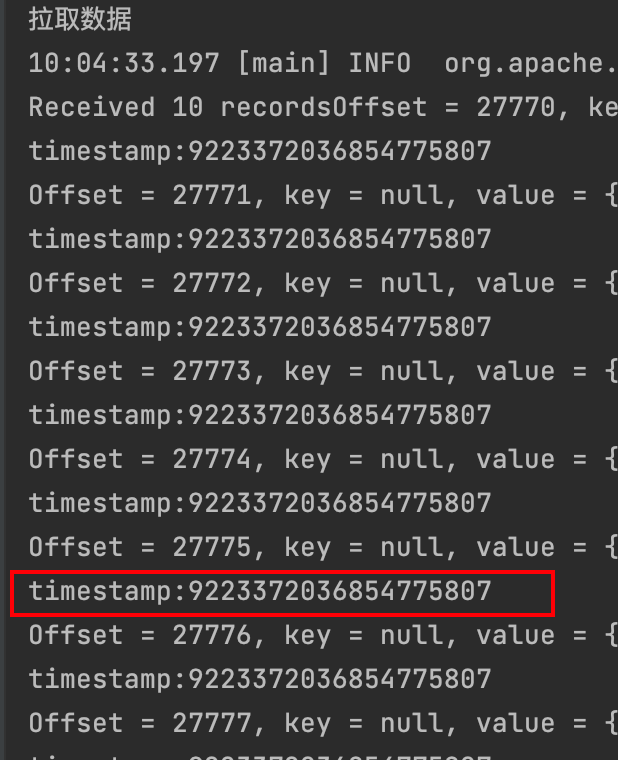

有人遇到过flink的kafkasink写kafka的,写进去的数据的timestamp不对的情况嘛?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果使用 Flink 的 Kafka Sink 将数据写入 Kafka 中,但是发现写入的数据的 timestamp 不正确,那么可能有以下几种情况和解决方案:

1、数据源的 timestamp 不正确:如果你的数据源本身的 timestamp 不正确,那么无论你如何调整 Kafka Sink 的配置,写入的数据的 timestamp 都不会正确。这种情况下,需要检查数据源的 timestamp 是否正确,并在数据源端进行修正。

2、Flink 程序中使用了 event time:如果你的 Flink 程序使用了 event time,并且在计算过程中修改了数据的 timestamp,那么需要确保在将数据写入 Kafka 之前,使用 Flink 的 assignTimestampsAndWatermarks() 方法重新设置一下数据的 timestamp。例如:

dataStream

.assignTimestampsAndWatermarks(new MyTimestampExtractor())

.addSink(new FlinkKafkaProducer<String>("my-topic", new SimpleStringSchema(), properties));

在 MyTimestampExtractor 中,可以根据业务逻辑重新设置数据的 timestamp。

3、Flink 程序中使用了 processing time:如果你的 Flink 程序使用了 processing time,那么需要在创建 FlinkKafkaProducer 实例时,将 FlinkKafkaProducer.Semantic.EXACTLY_ONCE 参数设置为 FlinkKafkaProducer.Semantic.AT_LEAST_ONCE。这样,Flink 将使用 Kafka 记录的 timestamp,而不是本地时间戳。例如:

FlinkKafkaProducer<String> kafkaProducer = new FlinkKafkaProducer<>("my-topic", new SimpleStringSchema(), properties);

kafkaProducer.setSemantic(FlinkKafkaProducer.Semantic.AT_LEAST_ONCE);

dataStream.addSink(kafkaProducer);

注意,这种方式可能会影响程序的性能和稳定性,因此需要根据具体情况进行权衡。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。