之前做好的数据加工,昨天都能跑,前天跑不起来

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,即“之前做好的数据加工任务昨天能正常运行,但前天的任务却无法成功执行”,我们可以按照以下步骤进行排查和解决:

状态检查:首先,请确认该任务在前天的具体状态。是否显示为失败或有其他异常状态?

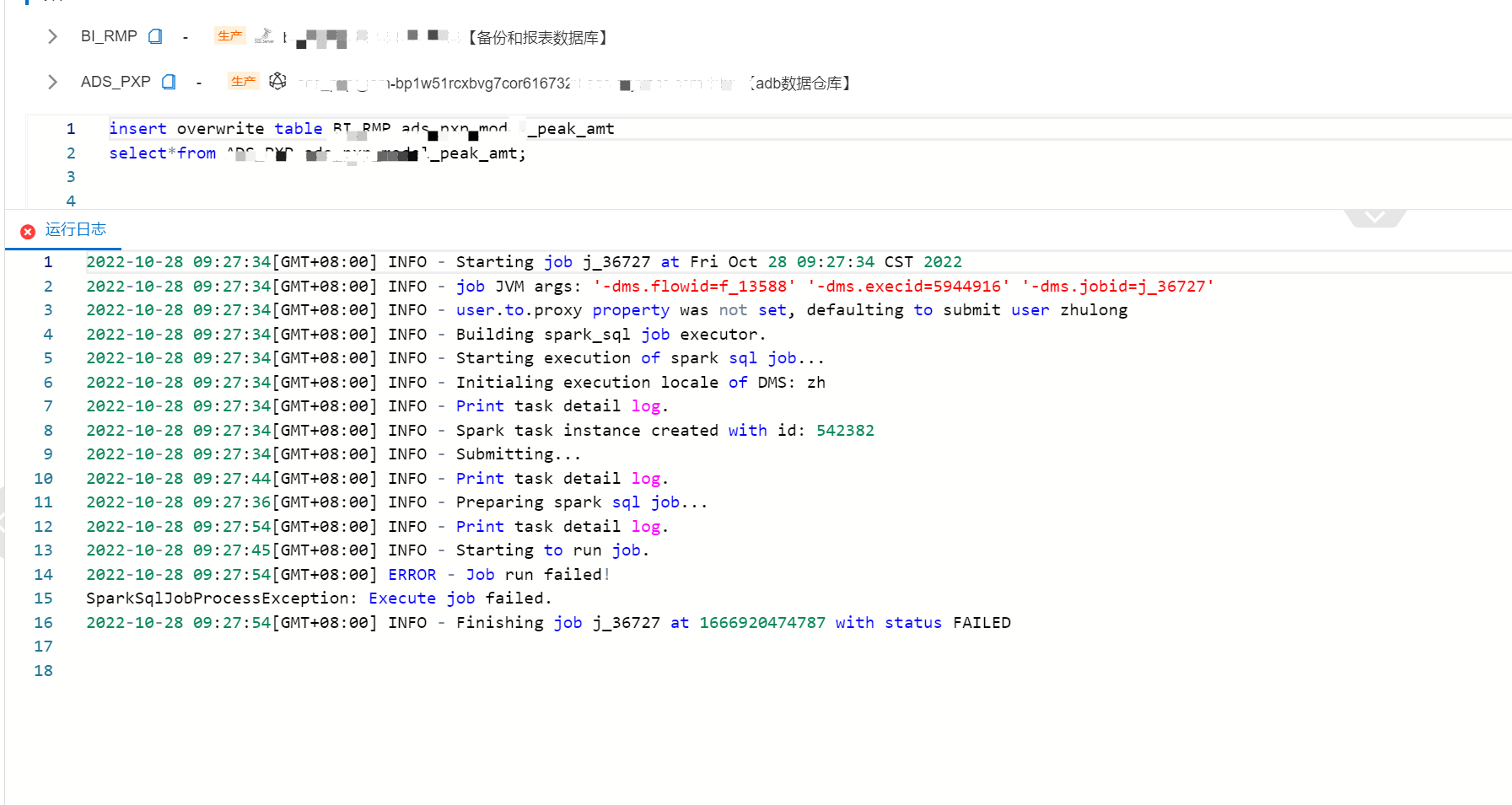

错误日志查看:查看internal-etl-log日志库中关于前天任务的错误信息,特别是message和reason字段,以定位问题原因。

依赖关系核实:如果任务存在时间依赖(如自依赖),请确认前天的任务是否因依赖于未完成或失败的上游任务而未能启动。

资源与权限验证:确保执行账户具有必要的权限,并检查是否有资源限制或网络问题导致任务无法执行。

配置复查:对比前天与昨天的数据加工配置,包括源Logstore、目标Logstore设置及加工规则,确认是否有变动或配置错误。

系统与版本兼容性:确认使用的DataWorks版本是否支持当前任务的所有特性,以及是否存在已知的版本兼容性问题。

查阅错误日志:登录DataWorks控制台,通过数据加工概览页面或直接访问internal-etl-log日志库,查找并分析前天任务的错误详情。

处理依赖问题:若发现是依赖问题,调整任务依赖配置或手动重跑上游失败任务。

配置修正:针对配置错误,修改相应的数据加工规则或输出目标配置后重新执行任务。

资源调整:若资源不足,考虑增加Shard数量或优化数据加工任务的资源配置。

技术支持求助:如果以上步骤均不能解决问题,建议联系阿里云技术支持,提供任务ID及相关日志,以便获取更专业的帮助。

通过上述步骤,您可以系统地诊断并尝试解决数据加工任务前天未能成功执行的问题。