版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误是因为 flink sql 写入表的时候,输出的列类型与表定义的列类型不一致,具体可以看到错误信息里面提到了 'windowStart' 列的类型不兼容。您需要确认一下表中 'windowStart' 列的数据类型,然后与查询中的列数据类型进行匹配。

如果您的查询结果中 'windowStart' 列的数据类型与表定义不一致,可以尝试使用 CAST 或者 CONVERT 函数将其转化成表定义的类型,例如:

INSERT INTO sink_table

SELECT CAST(windowStart as TIMESTAMP) AS windowStart, ...

FROM source_table

或者:

INSERT INTO sink_table

SELECT CONVERT(windowStart, TIMESTAMP) AS windowStart, ...

FROM source_table

上面的语句中,将查询结果中的 'windowStart' 列转化成 TIMESTAMP 类型,再进行写入。您需要将查询结果中的列类型,逐一转化成表定义的列类型,以避免类型不兼容的问题。

另外,如果有多个列类型不兼容,您可以逐一排查每一列的数据类型,逐个匹配数据类型,直至所有数据类型匹配完成,解决类型不兼容的问题。

Flink SQL中,需要将Java的Date类型转化为SQL的TIMESTAMP类型,可以使用如下方法: 1. 使用TO_TIMESTAMP函数将Java的Date类型转化为SQL的TIMESTAMP类型,例如:

SELECT TO_TIMESTAMP(RAW('java.util.Date', '2021-06-01 12:00:00'), 'yyyy-MM-dd HH:mm:ss') AS timestamp_col;

SELECT CAST(RAW('java.util.Date', '2021-06-01 12:00:00') AS TIMESTAMP(3)) AS timestamp_col;

这里需要注意的是,TIMESTAMP的精度可以通过括号中的数字来指定,例如TIMESTAMP(3)表示精确到毫秒。

如果查询结果的 schema 和 Sink 的 schema 不一致导致写入问题,可以尝试以下解决方法:

使用 CAST 函数显式地将查询结果中的字段类型转换为 Sink 中对应字段的类型。

使用 AS 关键字为查询结果中的字段重新命名,使其与 Sink 中的字段名称一致。

在创建 Sink 时,使用 WITH 参数指定 Sink 的 schema。例如,使用 CSV 格式写入数据时,可以使用以下参数:

'format' = 'csv', 'csv.field-delimiter' = ',', 'csv.ignore-parse-errors' = 'true', 'csv.allow-comments' = 'true', 'schema' = 'id INT, name STRING, age INT' 其中,schema 参数指定了 Sink 的 schema。

如果以上方法无法解决问题,可以考虑使用 Flink Table API 或者 Flink DataStream API 来实现数据写入,这些 API 可以更灵活地处理不同 schema 之间的转换。

Flink SQL 中写入数据时,查询结果的 schema 和 Sink 的 schema 不一致导致的问题。这可能是由于字段类型、字段名称或字段顺序等不一致所引起的

检查目标表的字段类型:首先,需要确认目标表中各个字段的数据类型是否正确,是否与您要写入的数据相匹配。例如,如果目标表中某个字段是日期类型,那么写入该字段时需要使用正确的日期格式。

检查写入数据的数据类型:其次,需要确认您要写入的数据的数据类型是否正确。例如,如果要写入一个日期类型的字段,需要使用正确

根据您提供的信息,似乎是 Flink SQL 中写入数据时,查询结果的 schema 和 Sink 的 schema 不一致导致的问题。这可能是由于字段类型、字段名称或字段顺序等不一致所引起的。要解决这个问题,您可以尝试以下几种方法:

确保查询结果的 schema 和 Sink 的 schema 完全一致,包括字段类型、字段名称和字段顺序。您可以在查询语句中使用 CAST 函数来显式转换字段类型,也可以使用 AS 关键字来指定字段名称。

如果查询结果的 schema 和 Sink 的 schema 只有部分字段不一致,您可以使用 Flink SQL 中的 SELECT 语句来重新定义查询结果的 schema,例如:

SELECT talId, CAST(windowStart AS TIMESTAMP(6)) AS windowstart, courseId, coursePlanId, stageId FROM ...

在上面的示例中,使用 CAST 函数将 windowStart 字段的类型转换为 TIMESTAMP(6),并使用 AS 关键字定义了查询结果中该字段的名称为 windowstart。

map 或 mapWith 等方法来进行类似的操作,例如:tableEnv.from("source_table")

.map(new MapFunction<Row, Row>() {

@Override

public Row map(Row row) throws Exception {

Date windowStart = (Date) row.getField(1);

Timestamp windowstart = new Timestamp(windowStart.getTime());

return Row.of(

row.getField(0), windowstart, row.getField(2), row.getField(3), row.getField(4)

);

}

})

.toAppendStream(...)

在上面的示例中,使用 map 方法重新定义了查询结果的 schema,并将 windowStart 字段的类型转换为 TIMESTAMP。最后通过 toAppendStream 方法将数据写入到 Sink 中。

总之,要解决 Flink SQL 写入数据时 schema 不一致的问题,关键是要确保查询结果的 schema 和 Sink 的 schema 完全一致或者通过转换、映射等方法将查询结果转换为 Sink 的 schema。

该错误提示是由于 Flink SQL 写入目标表的 schema 不匹配导致的。具体地,写入的字段与目标表的字段数或字段类型不匹配。

解决该问题的方法如下:

检查 Flink SQL 写入的字段数量是否与目标表的字段数量一致,以及字段类型是否匹配。如果不匹配,需要调整写入语句的字段数量或字段类型。

如果 Flink SQL 写入的字段与目标表的字段数量或字段类型一致,可以尝试在写入语句中使用 CAST 函数将字段类型强制转换为目标表的字段类型,例如:

Copy code

INSERT INTO target_table

SELECT CAST(field1 AS INT), CAST(field2 AS STRING), field3

FROM source_table;

在该语句中,使用 CAST 函数将 field1 和 field2 的类型分别强制转换为 INT 和 STRING,以满足目标表的类型要求。

如果以上方法均无法解决该问题,可以检查目标表的 schema 是否正确。如果目标表的 schema 与预期不符,需要调整目标表的 schema 以满足写入要求。

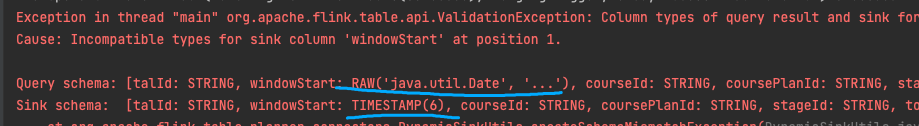

看你的截图查询结果中的 windowStart 列的类型是 RAW('java.util.Date',...),但是写入目标的 windowStart 列的类型是 TIMESTAMP(6)。

要解决这个问题,您需要对您的查询结果进行转换,使其与写入目标的列类型相匹配。您可以使用 Flink SQL 中的 CAST 函数将 windowStart 列转换为 TIMESTAMP(6) 类型。

这个异常是因为查询结果的列类型和写入目标的列类型不兼容。具体来说,您的查询结果中的 windowStart 列的类型是 RAW('java.util.Date',...),但是写入目标的 windowStart 列的类型是 TIMESTAMP(6)。

要解决这个问题,您需要对您的查询结果进行转换,使其与写入目标的列类型相匹配。您可以使用 Flink SQL 中的 CAST 函数将 windowStart 列转换为 TIMESTAMP(6) 类型。

例如,将查询结果中的 windowStart 列转换为 TIMESTAMP(6) 类型的示例代码如下:

SELECT talId, CAST(windowStart AS TIMESTAMP(6)), courseId, coursePlanId, stageId FROM your_query_result 请注意,您需要将 your_query_result 替换为实际的查询结果表名或子查询名称。

Flink SQL Job 在 Sink 端出现了一个 NullPointerException 错误。可能存在下列两种情况:

首先,请检查 Sink 的目标是否为空。如果 Sink 的目标使用的是文件、Kafka 等外部存储,检查存储位置或 topic 是否可用,同时确认数据是否为空。

在 Flink 中,数据会按照 Source -> Transformation -> Sink 的流程完成一个完整的数据处理过程。如果在这个过程中 Source 发出了 Null 数据,当这些空数据到达 Sink 时,就有可能出现了空指针异常。在这种情况下,应该在数据处理过程中增加过滤措施,丢弃那些无意义的数据以避免空指针异常的发生。

例如:

CREATE TABLE mySource (

`id` INT,

`name` STRING,

`age` INT

) WITH (

'connector' = 'kafka',

'topic' = 'myTopic',

...

);

CREATE TABLE mySink (

`name` STRING,

`age` INT

) WITH (

'connector' = 'kafka',

'topic' = 'myResultTopic',

...

);

INSERT INTO mySink

SELECT name, age FROM mySource WHERE id > 0;

在这个例子中,我们在 mySource 中定义了 id、name 和 age 三个字段。并在 mySink 中定义了 name 和 age 两个字段。如果输入数据中的 id 字段有可能出现 NULL 或者空字符串、0 等无意义的内容,为了避免源数据中出现空指针异常,可以在查询语句的 WHERE 子句中增加过滤措施:

SELECT name, age FROM mySource WHERE id IS NOT NULL AND id > 0;

在一些情形下,Sink 的输出异常可能与 Schema 有关。如果在 Sink 的 Schema 中,存在某些字段为空,则可能导致异常的发生。

请比较一下 query 中定义的 Field,以及目的地 connectors 的 Field 是否完全一致,并依此进行修改(可能需要手工调整 INSERT INTO 语句中的字段顺序),条件如下:

例如:

CREATE TABLE mySink (

`id` INT,

`name` STRING,

`age` INT

) WITH (

'connector' = 'jdbc',

'driver' = 'com.mysql.jdbc.Driver',

'url' = 'jdbc:mysql://localhost:3306/mydatabase',

'table-name' = 'user_info',

'username' = 'root',

'password' = 'root'

);

INSERT INTO mySink

SELECT

id,

name,

age

FROM myTable;

在这个例子中,我们在 mySink 中定义了 id、name 和 age 三个字段。假设 query 中存在 id、name、age 三个字段,并且数据类型也相同,如果在数据处理过程中出现 Schema 不一致的情况,则可能导致空指针异常。此时,需要在 query 中进行对应的字段映射:

INSERT INTO mySink (id, name, age)

SELECT

id,

name,

age

FROM myTable;

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。