》》》》》魏红斌带你学shell脚本《《《《《

更多shell脚本学习点击个人主页

作为一个资深程序猿,我将带领您从零开始,一步步踏上运维之旅,无论您是否拥有现成的服务器,都将学会如何轻松购买、部署,并通过编写及应用精心设计的Shell脚本,解决实际工作中遇到的问题。这些脚本不仅源自真实的业务场景,经历了反复实践与严格测试,确保了其简洁高效、易于理解且便于使用。更重要的是,我们将全程免费分享,并深度解析背后原理,助您深入理解并灵活运用,每一款脚本均经过真实业务场景的反复打磨与严格测试,秉持着简洁高效、易于理解和使用的理念设计,无偿提供并且提供相关解析过程,让读者能更深入了解相关内容。

无服务器的朋友们:

让我们先从选购并部署服务器开始。只需简单三步,即可拥有您的专属云服务器:

- 访问ECS官网:点击链接直达阿里云ECS网站:ECS选择网址。这是您获取高质量云服务器的第一站。

- 选择并购买:在琳琅满目的服务器配置中,挑选符合您需求的那一款,一键下单,完成支付。整个过程犹如在线购物般便捷。

- 进入ECS控制台:支付成功后,您将被引导至ECS管理控制台。在这里,您可以全面掌控您的服务器资源,后续的所有运维操作都将在此展开。

已有服务器的朋友们:

如果您已拥有ECS实例,那么请直接登录ECS管理控制台。在左侧导航栏中,依次选择“实例与镜像” > “实例”,确保您已定位到目标资源所在的资源组和地域。接下来,在实例列表中找到待连接的实例,点击操作列下的“远程连接”,选择“通过Workbench远程连接”并点击“立即登录”。

登录实例:

无论是新购还是已有服务器,接下来都需要进行实例登录。这里支持多种认证方式,以最常见的“密码认证”为例:

- 输入用户名(通常为

root或ecs-user)。 - 接着,输入登录密码。如果您忘记了密码,无需担忧,您可以在ECS实例详情页面查询,或者通过“更改密码”功能进行修改。

编写与运行Shell脚本:

成功登录后,您将看到一个熟悉的命令行界面——这就是您的运维主战场。现在,键入vim test.sh,我们便进入了文本编辑模式,准备创建第一个Shell脚本。

按下键盘上的i键,进入插入模式,此刻您可以自由地复制粘贴今天要学习的脚本代码,粘贴后按ecs后,按:wq保存脚本,可以用./ test.sh或者sh test.sh进行脚本执行。

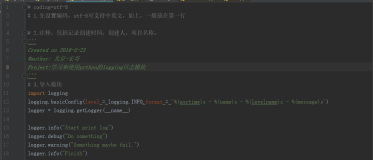

今天我们要学习的脚本是(脚本内容直接复制粘贴即可):

如果想

#!/bin/bash # 创新性Shell脚本:多源数据同步与自动化日志分析 # 定义源数据路径和目标数据路径 SOURCE_DIR="/path/to/source/data" TARGET_DIR="/path/to/target/data" LOG_FILE="/path/to/logfile.log" # 函数:同步源数据到目标数据路径 sync_data() { rsync -avh --progress "$SOURCE_DIR/" "$TARGET_DIR/" echo "$(date): Data synchronized from $SOURCE_DIR to $TARGET_DIR" >> "$LOG_FILE" } # 函数:分析日志文件并输出统计信息 analyze_log() { # 统计今日同步次数 sync_count=$(grep -c "$(date +'%Y-%m-%d')" "$LOG_FILE") echo "Today's synchronization count: $sync_count" # 统计最频繁同步的时间段 most_frequent_time=$(grep -oP "\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}" "$LOG_FILE" | sort | uniq -c | sort -nr | head -n 1 | awk '{print $2}') echo "Most frequent synchronization time: $most_frequent_time" } # 主程序 while true; do # 同步数据 sync_data # 等待5分钟 sleep 300 # 分析日志 analyze_log # 发送统计信息到指定邮箱(需要配置sendmail或其他邮件发送工具) # echo "Synchronization report:" | cat - "$LOG_FILE" | mail -s "Daily Sync Report" user@example.com done

逐行解析:

#!/bin/bash:指定脚本使用bash shell来执行。- 注释:简要描述脚本的功能。

3-5. 定义源数据路径、目标数据路径和日志文件路径的变量。 sync_data()函数定义:用于同步源数据到目标数据路径。rsync命令:使用rsync工具进行数据的同步,-avh --progress参数表示归档模式、显示传输进度等。echo命令:将同步信息追加到日志文件中。analyze_log()函数定义:用于分析日志文件并输出统计信息。grep命令:统计今日同步次数。grep -oP命令:结合正则表达式提取日志中的时间戳。sort、uniq -c、sort -nr、head -n 1命令组合:统计最频繁同步的时间段。echo命令:输出统计结果。while true; do:无限循环,确保脚本持续运行。- 调用

sync_data函数进行数据同步。 sleep 300:脚本暂停300秒(5分钟)。- 调用

analyze_log函数分析日志并输出统计信息。 echo和cat命令组合:将统计信息和日志文件内容发送到指定邮箱(需要配置邮件发送工具)。done:结束无限循环。

总结:

这个创新性的Shell脚本实现了多源数据到目标路径的自动同步,并通过对日志文件的自动化分析,提供了有关同步活动的统计信息。脚本使用了rsync工具进行高效的数据同步,并通过自定义函数简化了脚本的结构和可读性。此外,脚本还包含了将统计信息发送到指定邮箱的功能(需要额外配置邮件发送工具),从而实现了监控和通知的自动化。

上手操作练代码的同学们可以通过阿里云ecs服务器免费试用参与!

入口:新老同学免费试用