大数据计算MaxComputedelete语句这两者有什么好的办法结合吗?

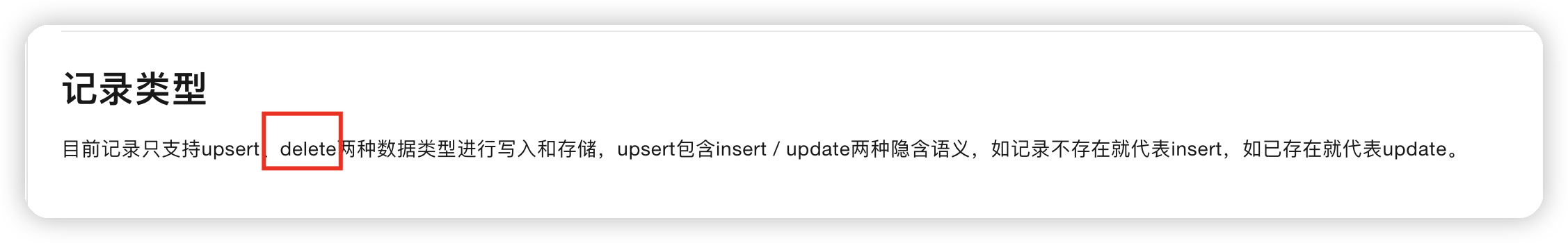

大数据计算MaxCompute中tables2.0我看说是支持delete的,我增量数据是dts同步出来的log,insert和update是可以行的通的,但是delete语句这两者有什么好的办法结合吗,确保查询的最新数据的时候不把delete的查出来?

目前是拿dts的log增量数据,然后insert into 原来的全量数据,获取最新的数据,但是这种方案处理不了源库的delete的语句。

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

在MaxCompute中,tables2.0支持delete操作,可以用于删除表中的数据。对于增量数据同步的情况,您可以结合使用insert、update和delete操作来确保查询的最新数据时不包含已删除的数据。

以下是一些建议的方法:

- 使用增量同步:确保您的增量数据同步工具(如DTS)能够正确地处理delete操作,并将删除的数据同步到MaxCompute表中。这样,当您执行查询时,已删除的数据将不会出现在结果中。

- 使用分区表:如果您的表是分区表,您可以根据时间或其他条件对数据进行分区。通过定期删除旧的分区数据,您可以有效地管理表的大小并避免不必要的存储成本。

- 使用视图:您可以创建一个视图来过滤掉已删除的数据。视图可以根据需要选择要显示的列和行,并且可以应用各种过滤条件。通过创建适当的视图,您可以确保查询的结果只包含未被删除的数据。

- 定期清理数据:根据您的业务需求,您可以定期清理已删除的数据。这可以通过编写自定义脚本或使用MaxCompute提供的内置函数来实现。清理后的数据将不再出现在查询结果中。

请注意,具体的实现方法可能因您的数据模型和业务需求而有所不同。建议您根据您的具体情况进行调整和优化。

2024-03-04 13:40:27赞同 1 展开评论 打赏 -

在 MaxCompute 中,如果您的增量数据是通过 DTS 同步出来的日志,并且需要处理 delete 操作,有一种常见的做法是利用分区表(Partitioned Table)和历史数据表(Snapshot Table)结合的方式来实现。

具体步骤如下:

创建两张表:原始表(用于存储最新数据)和历史表(用于存储历史数据)。

原始表(最新数据)按照时间分区存储,每次 DTS 同步数据后,将新数据插入到原始表的对应分区中。

历史表则用于存储所有数据的完整历史记录,包括被删除的数据。当有数据被删除时,将对应的数据复制到历史表中。

在查询时,根据具体需求选择从原始表还是历史表中获取数据。如果需要查询最新数据,只查询原始表;如果需要包含被删除数据的完整历史记录,则查询历史表。

这种方式能够确保查询最新数据时不会将已删除的数据查出来,并且可以保留完整的历史记录以便后续分析和回溯。

需要注意的是,这种方式可能会增加存储成本,并且需要定期清理历史数据以避免数据过多导致存储资源浪费。另外,在实际操作中,您也可以根据具体业务需求和数据规模选择合适的策略来处理 delete 操作的数据同步和查询。

2024-03-04 13:22:28赞同 展开评论 打赏 -

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。