鉴于urllib请求模块的功能已经无法满足开发者的需求,出现了功能更强大的urllib3模块,urllib3模块是一个第三方的网络请求模块。

安装命令:pip install urllib3

1.发送网络请求

使用urllib3发送网络请求时,需要首先创建PoolManager对象,再通过该对象调用 request() 方法发送请求。

request(method,url,fields=None,headers=None)

- method 必选参数,用于指定请求方式,如GET,POST,PUT等。

- url 必须按参数,要访问的url

- fields 可选参数,设置请求的参数

- headers 可选参数,请求头

1.1GET请求

import urllib3 # 导入urllib3模块

url = 'https://www.python.org/'

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('GET', url) # 发送GET请求

print(r.status) # 打印请求状态码

程序运行结果:

使用 PoolManager对象(即连接池管理对象) 可以实现向多个服务器发送请求。

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

jingdong_url = 'https://www.jd.com/' # 京东url地址

python_url = 'https://www.python.org/' # Python url地址

baidu_url = 'https://www.baidu.com/' # 百度url地址

http = urllib3.PoolManager() # 创建连接池管理对象

r1 = http.request('GET', jingdong_url) # 向京东地址发送GET请求

r2 = http.request('GET', python_url) # 向python地址发送GET请求

r3 = http.request('GET', baidu_url) # 向百度地址发送GET请求

print('京东请求状态码:', r1.status)

print('python请求状态码:', r2.status)

print('百度请求状态码:', r3.status)

程序运行结果:

1.2POST请求

发送post请求同样使用request方法,只需要将request方法中的method参数设置为POST,将fields参数设置为字典类型的表单参数。

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'https://www.httpbin.org/post' # post请求测试地址

params = {

'name': 'Jack', 'country': '中国', 'age': 30} # 定义字典类型的请求参数,这里可以随意写进行测试

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('POST', url, fields=params) # 发送POST请求

print('返回结果:', r.data.decode('utf-8'))

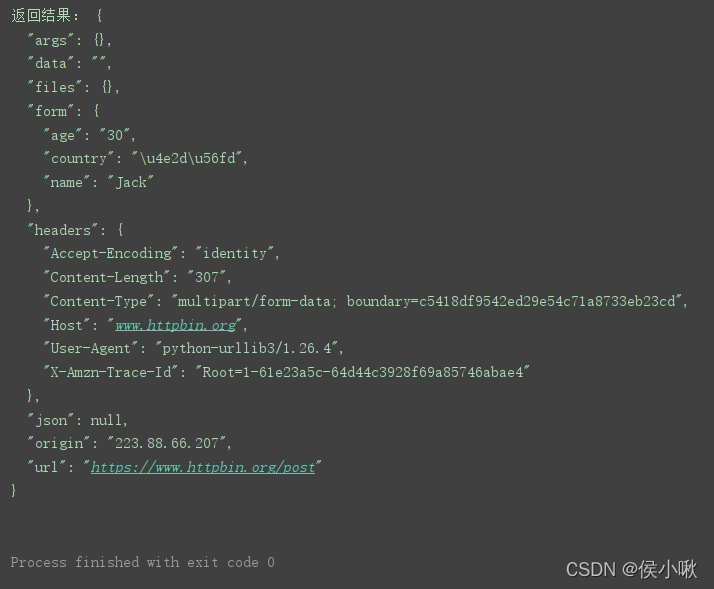

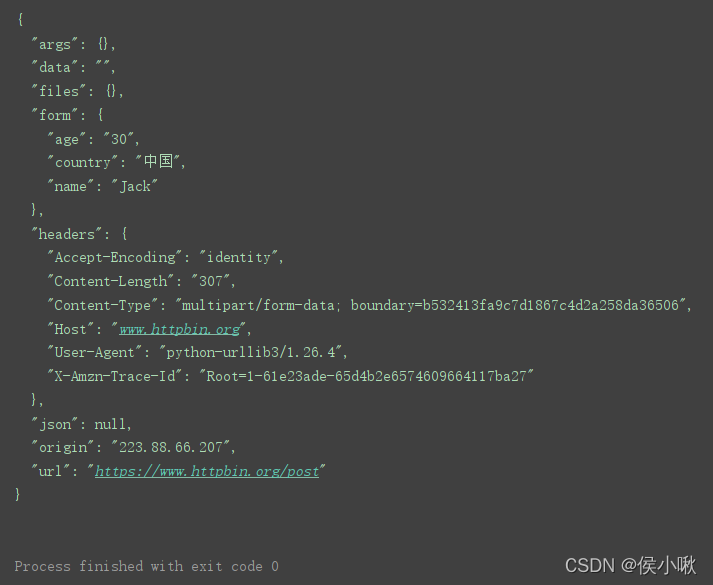

可以看出表单中的"中国"两个汉字没有正常显示。而是显示了一段unicode编码,对此可以将编码方式设置为unicode_escape。

print(r.data.decode('unicode_escape'))

这样就正常显示了。

1.3 重试请求

urllib3可以自动重试请求,request()方法请求重试次数默认为3次,如果要修改重试次数,可以设置retires参数。

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'https://www.httpbin.org/get' # get请求测试地址

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('GET', url) # 发送GET请求,默认重试请求

r1 = http.request('GET', url, retries=5) # 发送GET请求,设置5次重试请求

r2 = http.request('GET', url, retries=False) # 发送GET请求,关闭重试请求

print('默认重试请求次数:', r.retries.total)

print('设置重试请求次数:', r1.retries.total)

print('关闭重试请求次数:', r2.retries.total)

程序运行结果:

1.4 处理响应内容

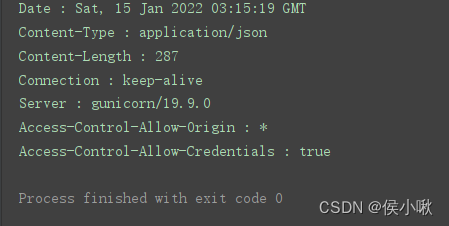

可通过info()方法获取响应头信息。

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'https://www.httpbin.org/get' # get请求测试地址

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('GET', url) # 发送GET请求,默认重试请求

response_header = r.info() # 获取响应头

for key in response_header.keys(): # 循环遍历打印响应头信息

print(key, ':', response_header.get(key))

处理服务器返回的JSON信息

通过json模块的 loads() 方法将响应json数据转换为字典类型。

import urllib3 # 导入urllib3模块

import json # 导入json模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'https://www.httpbin.org/post' # post请求测试地址

params = {

'name': 'Jack', 'country': '中国', 'age': 30} # 定义字典类型的请求参数

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('POST', url, fields=params) # 发送POST请求

j = json.loads(r.data.decode('unicode_escape')) # 将响应数据转换为字典类型

print('数据类型:', type(j))

print('获取form对应的数据:', j.get('form'))

print('获取country对应的数据:', j.get('form').get('country'))

二进制数据

如果响应数据为二进制数据,则可以使用open()函数将二进制数据转换为图片。

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'http://sck.rjkflm.com:666/spider/file/python.png' # 图片请求地址

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('GET', url) # 发送网络请求

print(r.data) # 打印二进制数据

f = open('python.png', 'wb+') # 创建open对象

f.write(r.data) # 写入数据

f.close() # 关闭

运行结果省略。生成图片文件如下:

2.发送复杂请求

2.1 设置请求头

示例如下:

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

url = 'https://www.httpbin.org/get' # get请求测试地址

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.45 Safari/537.36'}

http = urllib3.PoolManager() # 创建连接池管理对象

r = http.request('GET', url, headers=headers) # 发送GET请求

print(r.data.decode('utf-8')) # 打印返回内容

2.2 设置超时

超时的参数与时间可以写在request()方法中,也可以写在PoolManager()实例对象中。

示例:

import urllib3 # 导入urllib3模块

urllib3.disable_warnings() # 关闭ssl警告

baidu_url = 'https://www.baidu.com/' # 百度 超时请求测试地址

python_url = 'https://www.python.org/' # Python 超时请求测试地址

http = urllib3.PoolManager() # 创建连接池管理对象

try:

r = http.request('GET', baidu_url, timeout=0.01) # 发送GET请求,并设置超时时间为0.01秒

except Exception as error:

print('百度超时:', error)

http2 = urllib3.PoolManager(timeout=0.1) # 创建连接池管理对象,并设置超时时间为0.1秒

try:

r = http2.request('GET', python_url) # 发送GET请求

except Exception as error:

print('Python超时:', error)

如果需要更精准,则可以使用 Timeout 实例对象设置连接超时与读取超时。

示例代码:

import urllib3

from urllib3 import Timeout

urllib3.disable_warnings()

timeout = Timeout(connect=0.5, read=0.1)

http = urllib3.PoolManager(timeout=timeout)

http.request('GET', "https://www.python.org/")

或者

import urllib3

from urllib3 import Timeout

urllib3.disable_warnings()

timeout = Timeout(connect=0.5, read=0.1)

http = urllib3.PoolManager()

http.request('GET', "https://www.python.org/", timeout=timeout)

2.3设置代理

设置代理IP需要创建ProxyManager对象,该对象需要有两个参数;proxy_url表示需要使用的代理IP,headers即请求头。

import urllib3 # 导入urllib3模块

url = "http://httpbin.org/ip" # 代理IP请求测试地址

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.45 Safari/537.36'

}

# 创建代理管理对象

proxy = urllib3.ProxyManager('xxxxxxxxxxxx', headers=headers)

r = proxy.request('get', url, timeout=2.0) # 发送请求

print(r.data.decode()) # 打印返回结果

(代理IP自行设置)

3.上传文件

request()方法提供了两种比较常用的文件上传方式:

①一种是通过fields参数以元组的形式分别指定文件名、文件内容以及文件类型

②另一种指定body参数,该参数对应值为图片的二进制数据,然后还需要headers参数指定文件类型

- 上传文本文件

创建一个test.txt文件放在相同目录下进行测试。

import urllib3 # 导入urllib3模块

import json # 导入json模块

with open('test.txt') as f: # 打开文本文件

data = f.read() # 读取文件

http = urllib3.PoolManager() # 创建连接池管理对象

# 发送网络请求

r = http.request('POST', 'http://httpbin.org/post', fields={

'filefield': ('example.txt', data),})

files = json.loads(r.data.decode('utf-8'))['files'] # 获取上传文件内容

print(files)

创建一个python.jpg文件放在相同目录下进行测试。

- 上传图片文件

import urllib3 # 导入urllib3模块

with open('python.jpg', 'rb') as f: # 打开图片文件

data = f.read() # 读取文件

http = urllib3.PoolManager() # 创建连接池管理对象

# 发送请求

r = http.request('POST', 'http://httpbin.org/post', body=data, headers={

'Content-Type': 'image/jpeg'})

print(r.data.decode()) # 打印返回结果

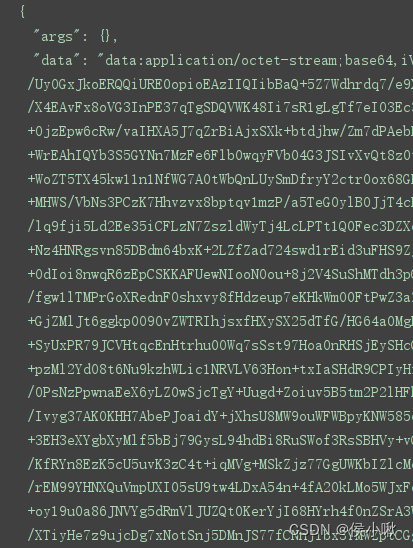

程序测试结果(部分):