SLS 配置

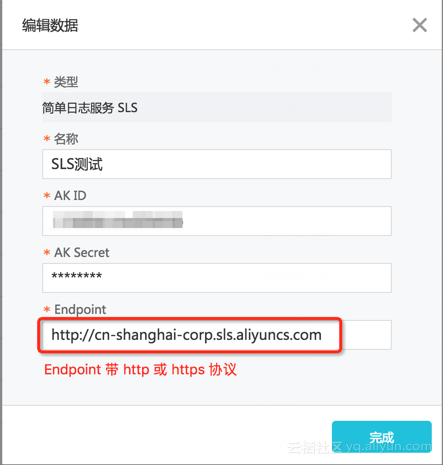

DataV 可以使用日志服务作为组件的数据源,数据源配置:

查询参数如下:

{

"projectName": "xxx",

"logStoreName": "xxx",

"from":150000000,

"to": 1514164461,

"topic": "",

"query": "select count(*) as c",

"line": 1000,

"offset": 0

}参数说明:

projectName: 日志服务的 project 名

logStoreName: 日志服务的 logStore 名

query: 日志服务 GetLogs接口的 query 查询,详细见文档:

https://help.aliyun.com/document_detail/29029.html

from 和 to 是以秒计算的起止时间

其余的参数和 GetLogs接口的参数含义相同

产生动态回调

由于 sls 的查询里需要指定起止时间,是以秒为单位的时间戳,如果我们需要实现的查询时间段是动态的,比如最近一天,那么这个 from 和 to 就需要动态产生。

在 DataV 里,动态参数的产生使用回调 id 实现,但是多数的组件的回调 id 的产生需要联动,也就是需要人工操作,如果希望能够实时地不断地产生回调 id,需要使用时间轴组件+过滤器。

时间轴可以设置定时产生回调 id,而回调 id 的值会在时间轴的数据里轮播。我们可以通过设置时间轴的数据自动更新和配置过滤器,从而让时间轴的数据动态生成,然后通过时间轴定时产生回调 id 的功能,提供这个动态的数据给其他的组件使用。

流程如下:

时间轴数据自动更新 -> 过滤器 -> 定时产生回调 id -> 其他组件使用回调 id(数据库、sls 等)

首先产生 sls查询的 from字段:

准备时间轴的数据,由于我们需要的是最近一天的 from,不需要额外的信息,所以数据使用静态数据即可:

设置自动更新,时间根据自己的需求来确定。

设置了自动更新之后,数据会每隔一段时间自动更新。由于我们的数据是静态数据,实际上每次自动更新的数据并没有发生变化,我们设置自动更新,只是为了执行过滤器,在过滤器里面产生当前时间前一天的时间戳。

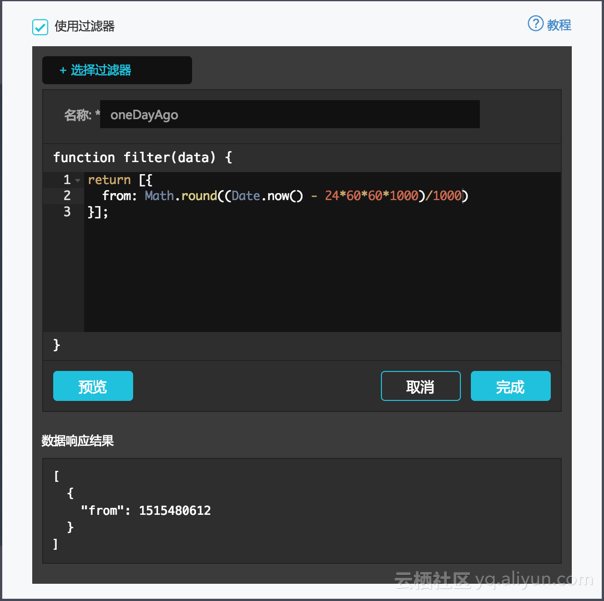

过滤器编辑:

return [{

from: Math.round((Date.now() - 24*60*60*1000)/1000)

}];

过滤器产生的时间轴数据:

这样,时间轴就会每一秒产生一个新的数据,里面有一个字段是 from,就是一天前的以秒计算的时间戳,如果你想要产生其他的数据,就在过滤器里计算就可以了,也可以对数据源的数据进行加工、格式转换。由于这里是产生时间戳,实际上对数据源查询的数据并没有使用。

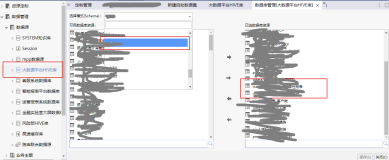

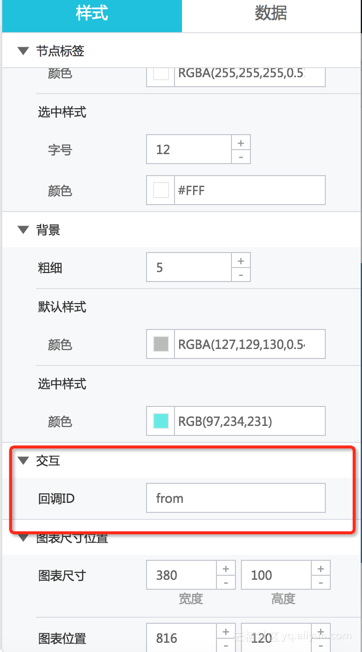

接下来就要将时间轴的数据作为回调设置:

使用回调 id

现在,我们已经有了一个动态的 from 回调 id,这个值就是一天前的时间戳,我们可以再 sls 的查询中使用:

{

"projectName": "xxx",

"logStoreName": "xxx",

"from":":from",

"to": 1515567884,

"topic": "",

"query": "select count(*) as c",

"line": 1000,

"offset": 0

}也可以在 sql 中使用:

select :from as a之后只有再加一个时间轴来产生 to 回调,值为当前的时间戳,name 动态的 sls 查询就是:

{

"projectName": "xxx",

"logStoreName": "xxx",

"from":":from",

"to":":to",

"topic": "",

"query": "select count(*) as c",

"line": 1000,

"offset": 0

}总结

时间轴组件的左右就是定期地产生一个回调的值,典型应用就是轮播一系列的数据。比如轮播2010年-2017年的数据。现在我们利用其定期产生回调的特性,在过滤器里面算出一个我们需要的值(本文里是需要的 from、to),就实现了定期产生一个动态的回调值的效果,来让需要动态参数的查询,比如 sls、sql 等可以使用动态的参数作为查询条件。