弹性计算Clouder认证:ECS基础运维管理

弹性计算Clouder认证:ECS基础运维管理

弹性计算Clouder认证:ECS快速入门

弹性计算Clouder认证:ECS快速入门

技术工作者

了解 AI 原生应用开发的前沿趋势和核心产品技术,全面 get 典型应用场景及硬核实战经验,现场完成实操,颁发专属证书与精美礼品。

阿里云实时数仓 Hologres,联合函数计算 FC 推出「Hologres + 函数计算 FunctionAI + Qwen 构建企业级数据分析 Agent」方案,帮助用户快速对接 MCP,高效跨越企业级数据分析 Agent 构建困境。

依托于阿里云函数计算 FC 算力,Serverless + AI 开发平台 FunctionAI 现已提供模型服务、应用模版两种部署方式辅助您部署 Qwen3 系列模型。完成模型部署后,您即可与模型进行对话体验;或以 API 形式进行调用,接入 AI 应用中,欢迎您立即体验。

内附 KubeCon China 2025 阿里云相关演讲视频回放及 KubeCon China 2025 分论坛 | 阿里云 AI 基础设施技术沙龙演讲 PDF。

微服务引擎 MSE 及云原生 API 网关 2025 年 6 月产品动态

从跨境电商 ERP 到“睿观 AI 助手”,阿里云函数计算的支持下,深圳三态股份利用 AI 技术快速完成专利、商标、版权等多维度的侵权风险全面扫描。结合函数计算实现弹性算力支持,降低成本并提升效率,实现业务的快速发展。

今日投资的技术负责人介绍了如何通过Higress MCP 市场完善的解决方案,快捷地将丰富的金融数据 API 转化为 MCP 工具,帮助用户通过 MCP 的方式非常轻松地调用专业金融数据,自由快速地构建自己的金融大模型应用。

Higress MCP 服务管理模块通过 OpenAPI、数据库及直接路由等方式快速构建 AI Agent 可调用的 MCP 服务,支持认证授权、流量控制等能力,助力企业高效打造私有化 MCP 市场。

一起知名线上故障:一个新功能在没有经过充分测试和灰度发布的情况下被直接部署到生产环境,并且处理推送关键配置没有灰度过程。导致全球大规模服务中断约7小时。故障由空指针异常引发,暴露了错误处理不足和灰度机制缺失等问题。配置灰度发布,如Nacos支持的IP或标签灰度,可有效降低风险,提升系统稳定性。

近日,软件领域国际顶会ISSTA 2025(International Symposium on Software Testing and Analysis)公布最高奖项-杰出论文奖——「通义灵码软件工程大模型SWE-GPT」成为唯一获得该奖项的企业论文

通过本次升级,FC 函数计算与 OpenTelemetry 的深度融合实现了全链路透明化,覆盖从系统层到业务层的完整追踪,并基于统一的 W3C 协议标准打破数据孤岛,确保跨环境一致性。同时,动态采样策略的引入有效平衡了性能与成本,为可观测性提供经济高效的解决方案。

通过“小游戏开发”和“MCP场景实践”两大趣味赛道,降低AI技术门槛,让开发者轻松体验“一句话生成代码”的魔力。

阿里云消息团队基于 Apache RocketMQ 构建 Serverless 消息系统,适配多种主流消息协议(如 RabbitMQ、MQTT 和 Kafka),成功解决了传统中间件在可伸缩性、成本及元数据管理等方面的难题,并据此实现 ApsaraMQ 全系列产品 Serverless 化,助力企业提效降本。

本文介绍了如何使用 llmaz 快速部署基于 vLLM 的大语言模型推理服务,并结合 Higress AI 网关实现流量控制、可观测性、故障转移等能力,构建稳定、高可用的大模型服务平台。

君润人力是一家科技驱动的人力资源服务公司,专注于为服务业提供一站式人力资源解决方案。通过AI与数字员工技术,公司在招聘、社保等领域实现自动化服务,提升效率并降低成本。同时,君润积极探索MCP协议和Higress网关技术,构建“数字灵工”平台,推动人服行业的智能化转型。

我们将分析一部红楼梦中关键角色出场次数前10位有哪些,并生成一个饼图。

在多云环境下,企业面临数据分散、整合效率低、弹性能力不足等挑战。阿里云日志服务(SLS)推出对象导入功能,支持从阿里云OSS和AWS S3高效导入多云日志文件,具备智能文件发现、弹性扩缩容、多种格式解析等能力,实现亿级文件下新增数据分钟级可见,并通过统一分析平台提升跨云数据治理效率。

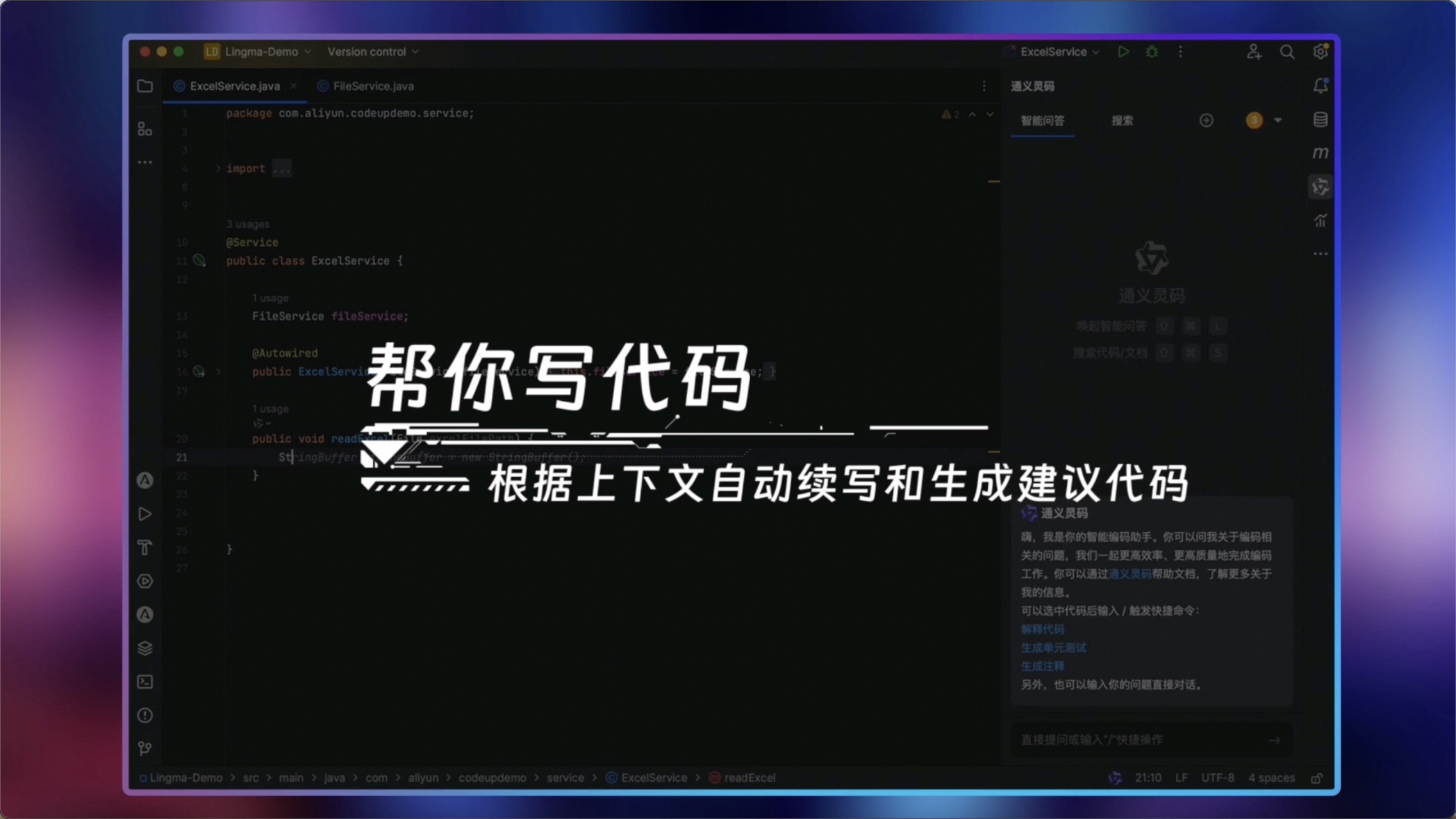

通过通义灵码编程智能体模式和 MCP 的集成,开发者可以高效构建在线菜品推荐网站。智能体模式大幅提升了开发效率,MCP 服务则为功能扩展提供了无限可能。

Nacos 3.0 正式发布,定位升级为“一个易于构建 AI Agent 应用的动态服务发现、配置管理和 AI 智能体管理平台”。架构上强化了安全性,引入零信任机制,并支持 MCP 服务管理、AI Registry 等新特性,助力 AI 应用高效开发与运行。

通义灵码现已全面支持Qwen3,新增智能体模式,具备自主决策、环境感知、工具使用等能力,可端到端完成编码任务。支持问答、文件编辑、智能体多模式自由切换,结合MCP工具与记忆功能,提升开发效率。AI IDE重构编程流程,让开发更智能高效。

本文总结了 Andrej Karpathy 在 YC AI Startup School 的分享核心观点,涵盖软件发展的三个阶段、LLM 的定位与挑战、Agent 的产品工程思路以及编程与部署的未来趋势。内容适合 AI 领域从业者参考,强调通过提升工程能力实现 AI 应用的稳定性与可控性。完整视频链接附于文末,便于深入学习。

语音合成技术正快速发展,广泛应用于智能座舱、儿童教育等领域。CosyVoice2凭借多语言生成、零样本生成等优势,成为企业优选。然而,企业仍面临GPU算力依赖、部署运维复杂及成本高等挑战。阿里云函数计算Function AI推出Serverless化语音合成方案,支持CosyVoice2一键部署与弹性扩容,简化调试与运维流程,显著降低成本,助力企业高效落地AI语音应用。

鸣鸣很忙集团作为中国最大的休闲食品饮料连锁零售商,旗下“零食很忙”和“赵一鸣零食”两大品牌已覆盖全国28个省份,门店数量超14000家。通过数字化转型,集团在4年内完成了传统企业10多年的数字化进程,实现了人、货、场的全面数字化管理。借助阿里云的全栈云原生方案,集团构建了弹性计算、大数据分析及智能监控体系,保障日均超430万级交易数据的一致性与稳定性,同时优化IT成本并提升运营效率。

本文介绍了基于函数计算 FC 打造的全新 Function AI 工作流服务,该服务结合 AI 技术与流程自动化,实现从传统流程自动化到智能流程自动化的跨越。文章通过内容营销素材生成、内容安全审核和泛企业 VOC 挖掘三个具体场景,展示了 Function AI 工作流的设计、配置及调试过程,并对比了其与传统流程的优势。Function AI 工作流具备可视化、智能性和可扩展性,成为企业智能化转型的重要基础设施,助力企业提升效率、降低成本并增强敏捷响应能力。

本文探讨了敏感数据的安全风险及降低账密泄漏风险的策略。国家颁布的《网络安全二级等保2.0标准》强调了企业数据安全的重要性。文章介绍了Nacos作为配置中心在提升数据库访问安全性方面的应用,并结合阿里云KMS、Druid连接池和Spring Cloud Alibaba社区推出的数据源动态轮转方案。该方案实现了加密配置统一托管、帐密全托管、双层权限管控等功能,将帐密切换时间从数小时优化到一秒,显著提升了安全性和效率。未来,MSE Nacos和KMS将扩展至更多组件如NoSQL、MQ等,提供一站式安全服务,助力AI时代的应用安全。

通义灵码近期新增了哪些功能?用户快速上手指南来了!

Spring-ai-alibaba-nl2sql 是析言 GBI 产品在数据问答领域的一次重要开源尝试,专注于 NL2SQL 场景下的核心能力开放。

本文将详细介绍如何利用云效MCP服务,根据工作项内容生成对应代码、创建分支、提交代码,并发起合并请求。

编程智能体与 MCP 的结合,不只是“工具+助手”,而是一次范式上的跃迁——从“手动调用工具”过渡到“AI 主动调度资源”。

通过与阿里云深度合作,国诚投顾完成了从传统 ECS 架构向云原生 Serverless 架构的全面转型。新的技术架构不仅解决了原有系统在稳定性、弹性、运维效率等方面的痛点,还在成本控制、API 治理、可观测性、DevOps 自动化等方面实现了全方位升级。

Nacos MCP Router 发布全新版本。带来了多项重要更新,包括对 SSE 和 StreamableHTTP 协议的全面支持、Docker 容器化部署方案以及革命性的 MCP Server 协议一键转换功能。文章中详细的介绍更新内容并简单演示了使用过程。Nacos MCP Router 新版本的发布,不仅提升了开发者的使用体验,也为 MCP 服务的广泛应用和生态繁荣奠定了基础,欢迎关注。

在 2025 年春季招聘季的激战中,智联招聘凭借阿里云 ACK One 注册集群与弹性 ACS 算力的深度融合,成功突破传统 IDC 机房的算力瓶颈,以云上弹性架构支撑千万级用户的高并发访问,实现招聘服务效率与稳定性的双重跃升。文章介绍了 ACK One+ACS 的弹性架构如何解决了春招的燃眉之急,让智联招聘的技术团队能够聚焦创新业务开发,欢迎关注。

通义灵码 AI IDE 已正式上线,即日起用户可在通义灵码官网免费下载开箱即用。

通义灵码5月升级了智能问答(Ask)模式至Agentic模式,支持自主调用工程感知和网络检索工具,使开发者互动更贴合工程场景。新增行间会话(Inline Chat)与行间建议预测(NES)功能,大幅提升代码修改效率。同时发布AI IDE——Lingma IDE,全面集成智能编码能力,开箱即用,无需额外插件。此外,还优化了上下文文件添加体验及其他多项功能,进一步提升开发效率和用户体验。

本文介绍了如何使用通义灵码编程智能体与高德 MCP 2.0 制作北京端午3天旅行攻略页面。首先需下载通义灵码 AI IDE 并获取高德申请的 key,接着通过添加 MCP 服务生成 travel_tips.html 文件,最终在手机端查看已发布上线的攻略。此外还详细说明了利用通义灵码打造专属 MCP 服务的过程,包括开发计划、代码编写、部署及连接服务等步骤,并提供了自由探索的方向及相关资料链接。

本文将深入剖析 MCP Server 的五种主流架构模式,并结合 Nacos 服务治理框架,为企业级 MCP 部署提供实用指南。

常见的问题,来找答案。

作为AI原生的开发环境工具,通义灵码AI IDE深度适配了最新的千问3大模型,并全面集成通义灵码插件能力,具备编程智能体、行间建议预测、行间会话等功能。

Nacos3.0 开源开发者沙龙 Agent&MCP 专场,本次活动是 Nacos 社区成员今年首次线下分享最新的能力和实践,并邀请了 Spring AI Alibaba 和 Higress 一起分享一站式的开源解决方案。欢迎大家来现场交流。

PromQL AI 智能体上线。本文将从自然语言生成 PromQL 实践视角,探讨如何构建知识库、与大模型进行交互、最终生成符合需求的 PromQL 语句。本文还介绍了在 MCP 和云监控控制台下使用 AI 智能体的用例。

本文介绍了阿里云在云原生与AI结合领域的最新产品发布和技术创新。首先,通过弹性智能的一体化架构,阿里云为AI场景提供了开箱即用的云原生能力,助力企业出海。其次,详细解析了云原生如何助力AI应用构建,包括Function AI平台、GPU极速模式、MCP Server开发托管及AI网关等核心功能。

OSSFS 2.0通过轻量化协议设计、协程化技术及FUSE3低级API重构,实现大文件顺序读写与小文件高并发加载的显著提升,在实际测试中表现出高达数十倍的吞吐量增长。适用于机器学习训练、推理等对高带宽低延迟要求严苛的场景,同时支持静态和动态挂载方式,方便用户在ACK集群中部署使用。

Higress是一个基于Istio和Envoy的云原生API网关,支持AI功能扩展。它通过Go/Rust/JS编写的Wasm插件提供可扩展架构,并包含Node和Java的console模块。Higress起源于阿里巴巴,解决了Tengine配置重载及gRPC/Dubbo负载均衡问题,现已成为阿里云API网关的基础。本文介绍Higress的基本架构、功能(如AI网关、API管理、Ingress流量网关等)、部署方式以及如何参与开源贡献。此外,还提供了有效的开源贡献指南和社区交流信息。

通义灵码提供智能会话能力,支持智能问答、文件编辑和智能体三种模式,帮助开发者解决编码问题,进行代码修复、调试及运行错误排查。它具备多文件修改、自主决策等能力,可端到端完成编码任务。在智能会话中,支持丰富的上下文(如代码文件、目录、图片、Git Commit 等),并允许用户自由组合提示词与上下文。插件可通过链接下载。此外,还支持多种上下文类型(#file、#folder、#image 等),便于开发者精准表达需求。

本文将以 MCP Server 在函数计算平台的深度集成为研究载体,解构基于 SSE 长连接通信模型,剖析会话亲和、优雅升级等关键技术,揭示 Serverless 架构在 MCP 场景中的亲和性创新实践。

本文介绍了Spring AI Alibaba MCP的开发与应用,旨在解决企业级AI Agent在分布式环境下的部署和动态更新问题。通过集成Nacos,Spring AI Alibaba实现了流量负载均衡及节点变更动态感知等功能。开发者可方便地将企业内部业务系统发布为MCP服务或开发自己的AI Agent。文章详细描述了如何通过代理应用接入存量业务系统,以及全新MCP服务的开发流程,并提供了完整的配置示例和源码链接。未来,Spring AI Alibaba计划结合Nacos3的mcp-registry与mcp-router能力,进一步优化Agent开发体验。

5月22日 14:00「飞天发布时刻」,阿里云云原生应用平台产品负责人李国强将重磅揭晓面向 AI 场景的云原生产品体系升级,通过弹性智能的全球一体化架构、开箱即用的云原生 AI 工程化能力,为中国企业出海提供全新技术引擎。

SLS 是阿里云可观测家族的核心产品之一,提供全托管的可观测数据服务。本文以 o11y 2.0 为引子,整理了可观测数据 Pipeline 的演进和一些思考。

通过AI技术,即使不编写代码也能高效开发项目。从生成诗朗诵网页到3D游戏创建,这些令人惊叹的操作如今触手可及。经过摸索,我利用AI成功上线了个人站点:https://koi0101-max.github.io/web。无需一行代码,借助强大的工具即可实现创意,让开发变得简单快捷!

本文对比了Apache Airflow与Argo Workflows两大分布式任务调度系统。两者均支持复杂的DAG任务编排、社区支持及任务调度功能,且具备优秀的用户界面。Airflow以Python为核心语言,适合数据科学家使用,拥有丰富的Operator库和云服务集成能力;而Argo Workflows基于Kubernetes设计,支持YAML和Python双语定义工作流,具备轻量化、高性能并发调度的优势,并通过Kubernetes的RBAC机制实现多用户隔离。在大数据和AI场景中,Airflow擅长结合云厂商服务,Argo则更适配Kubernetes生态下的深度集成。

发表了文章

2025-12-04

发表了文章

2025-12-04

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-02

发表了文章

2025-12-02

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

回答了问题

2025-07-24

回答了问题

2025-07-24

回答了问题

2025-05-05

回答了问题

2025-05-05

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2024-10-25

回答了问题

2024-10-25

提交了问题

2024-07-04

提交了问题

2024-07-04

回答了问题

2024-05-29

回答了问题

2024-05-29

回答了问题

2024-05-15

回答了问题

2024-05-15

提交了问题

2024-04-09

提交了问题

2024-04-09

提交了问题

2023-11-06

提交了问题

2023-11-06