弹性计算Clouder认证:ECS基础运维管理

弹性计算Clouder认证:ECS基础运维管理

弹性计算Clouder认证:ECS快速入门

弹性计算Clouder认证:ECS快速入门

技术工作者

本文助力解决传统开发流程中的一些挑战。

在 AI 时代,随着模型和应用侧的快速演化,对于推理过程,成本和性能显得尤为重要,而端到端的 AI 可观测是其中至关重要的一环。本文将介绍端到端 AI 可观测的基本概念与痛点,并通过阿里云可观测团队最新开源的 AI 采集套件 LoongSuite Agent 来对大模型应用进行全链路可观测以解决这些痛点。帮助客户无侵入,低成本地进行全链路的大模型可观测。

Higress AI 网关通过提供关键桥梁作用,支持 Dify 应用便捷对接业界成熟的 RAG 引擎。通过 AI 网关将 Dify 的高效编排能力与专业 RAG 引擎的检索效能结合,企业可在保留现有 Dify 应用资产的同时,有效规避其内置 RAG 的局限,显著提升知识驱动型 AI 应用的生产环境表现。

近期,1688 推出了 1688 AI App,这貌似是国内第一个电商领域的独立 AI App 应用(若不是,欢迎评论指正)。本文试图通过产品界面这一入口,窥探其背后的系统工程。

本次大赛由阿里云主办,云原生应用平台承办,聚焦 Operation Intelligence 的智能运维(AIOps)赛道,为热爱 AI 技术的开发者提供发挥创意和想象力的舞台,借助 LLM 强大的推理能力与标准化整合的多源可观测数据,找到 AI 应用在智能运维(AIOps)场景上的新方式。

阿里云云速搭 CADT(Cloud Architect Design Tools)推出智能化升级——云小搭,一款基于大模型的 AI 云架构助手,致力于让每一位用户都能“动动嘴”就完成专业级云架构设计。

如果现有的MCP服务不满足您的需求,通义灵码智能体能够帮助您开发专属MCP服务,直达业务目标。本案例以高德提供的基础MCP服务为基础,借助智能体开发一个订制旅游攻略的高级MCP服务。

阿里云诚挚邀请您参加【AI原生,智构未来——AI原生架构与企业实践】工作坊,8月29日13:30于深圳·LandMarkCoffee 蓝马咖啡(南山区科技园桑达科技大厦1楼)从开发范式到工程化实践,全链路解析AI原生架构奥秘,与AI先行者共探增长新机遇。立即报名:https://hd.aliyun.com/form/6638

0-1 完全通过自然语言交互 实现一个 AI 高考志愿填报系统,结合通义千问 AI 模型提供专业推荐。该项目旨在帮助高考学生和家长根据个人情况智能推荐合适的专业和学校,减少志愿填报的盲目性。

本文深入探讨了AI时代数据处理的变革与挑战,分析了事件驱动架构(EventBridge)在AI数据处理中的技术优势,并结合实践案例,展示了其在多源数据接入、向量数据库优化、智能数据转换等方面的应用价值。

MCP(Model Control Protocol)作为AI应用上下文工程中的关键组成部分,正广泛应用于企业AI转型实践。企业开发人员通过Cursor、Cline、灵码等AI工具使用MCP,结合自定义MCP实现创新,但也面临生产发布、沉淀复用等挑战。Function AI提供完整的企业级MCP解决方案,通过标准化流程解决MCP构建与发布问题,并通过MCP市场模板打造企业专属服务中心,提升复用效率。方案支持快速部署、测试及集成,助力企业高效构建智能化体系。

本文探讨了事件驱动架构(EDA)在AI时代的重要价值。首先,通过RAG技术缓解AI幻觉问题,提高大模型回答的准确性;其次,作为推理触发器,实现自动化任务处理和系统联动;最后,构建Agent通信基础设施,推动AI系统间的高效协作。EDA以其事件为中心、实时响应的特点,为AI系统提供感知与行动能力,是构建智能系统的关键支撑。

邀您参与 “直通乌镇” Spring AI Alibaba 开源竞技挑战赛!

阿里云 FC+Redis 驱动下轻休闲游戏服务器架构的革新与突破

在企业云原生转型过程中,如何实现传统微服务与 Kubernetes 服务的配置统一管理、服务互通及协议转换成为关键挑战。MSE Nacos Controller 应运而生,作为连接 Kubernetes 与 Nacos 的桥梁,支持 ConfigMap 与 Nacos 配置双向同步、服务自动注册发现,并助力 Higress 等 MCP 网关实现 REST API 向 AI 可调用 MCP 服务的转换,全面提升系统治理能力与智能化水平。

本文深入解析了 Apache Flink 架构中 ZooKeeper 的核心作用,包括 Leader 选举、Checkpoint 管理、作业协调及配置管理等关键功能,并结合金融风控与电商推荐等典型场景,分析了 ZooKeeper 在实际应用中的技术实现。

本文内容整理自「 2025 中企出海大会·游戏与互娱出海分论坛」,灵犀互娱基础架构负责人朱晓靖的演讲内容,从技术层面分享云原生架构护航灵犀互娱游戏出海经验。

近日,Gartner® 发布了 2025 年度全球《云原生应用平台魔力象限》报告,阿里云凭借 Serverless 应用引擎 SAE(以下简称 SAE)和函数计算 FC,成为亚太地区唯一入选「领导者象限」的科技公司。

Apache Dubbo 最新升级带来云原生能力全面增强,支持一键部署微服务集群与全新可视化控制台,提升全生命周期管理体验。

金蝶云•星辰通过阿里云日志服务 SLS 替换自建 ELK 系统,构建统一可观测平台,有效应对业务高速增长带来的稳定性挑战,提升运维效率与系统稳定性,助力企业数字化转型。

近日,Gartner®发布了2025年度全球《云原生应用平台魔力象限》报告,阿里云凭借Serverless应用引擎SAE(以下简称SAE)和函数计算FC,成为亚太地区唯一入选「领导者象限」的科技公司。

2025杭州·云栖大会,来了!

在 AI 与云原生融合的趋势下,开发者面临模型协同与云端扩展的挑战。MCP(模型上下文协议)提供统一的交互规范,简化模型集成与服务开发。Function AI 支持 MCP 代码一键上云,提供绑定代码仓库、OSS 上传、本地交付物部署及镜像部署等多种构建方式,助力开发者高效部署智能服务,实现快速迭代与云端协同。

JSON 日志因灵活易扩展而广泛应用,但其海量数据也带来分析挑战。本文系统介绍阿里云日志服务(SLS)中处理 JSON 日志的最佳实践,涵盖数据预处理、索引配置、JSON 函数使用及 SQL 智能生成,助你高效挖掘日志价值。

阿里云可观测 2025 年 7 月产品动态

Nacos社区推出MCP Router与MCP Registry开源解决方案,助力AI Agent高效调用外部工具。Router可智能筛选匹配的MCP Server,减少Token消耗,提升安全性与部署效率。结合Nacos Registry实现服务自动发现与管理,简化AI Agent集成复杂度。支持协议转换与容器化部署,保障服务隔离与数据安全。提供智能路由与代理模式,优化工具调用性能,助力MCP生态普及。

阿里云微服务引擎 MSE ZooKeeper 企业版正式发布,提供比专业版更高的稳定性与安全能力,SLA 达 99.99%,整体性能提升 100%。企业版通过独享资源池实现更高规格配额,满足大规模需求,并新增数据备份容灾、容量管理、反脆弱限流等功能,助力企业应对复杂业务挑战。

AI 调酒师上岗!

Qwen3 Coder 是全球领先的开源编程大模型,具备强大的代码生成能力与1M超长上下文支持,适用于构建复杂应用。本文通过实际案例展示其在电商网站开发中的应用,并详解提示词设计、技术拆解与部署方案,探讨Agentic AI落地的挑战与经验。

Serverless 是当前技术领域最有可能演进为 AI Native Infra 的技术架构,函数计算正着力于打造模块化的 Agent Infra 之剑,助力开发者从“生态应用者”进阶为“能力定义者”,最终推动 AI 技术走向开放共享的创新之路。

阿里云微服务引擎 MSE 及 API 网关 2025 年 7 月产品动态

在2025年世界人工智能大会上,通义灵码助力蔚来汽车提升研发效能,成功入选“人工智能+”行业标杆案例。蔚来已有近1000名工程师常态化使用该工具,AI生成代码占比超30%,在“天探”系统中更达70%,显著提升开发效率与代码质量,并正向更多核心领域扩展。

2025可信云大会发布Serverless云服务能力评估结果,阿里云作为首批入选单位,凭借ApsaraMQ for RocketMQ和Kafka展现出卓越能力。ApsaraMQ全系产品已完成Serverless化升级,具备全场景覆盖、低成本、高稳定、高效率及生态集成优势,广泛应用于电商、游戏、出行、旅游等多个行业,助力企业实现降本增效。未来将持续推动高弹性、智能化、免运维的消息服务创新。

Higress 入选《AI Cloud 大模型推理与交互典型案例》

欢迎大家在通义灵码里免费体验最新 Qwen3-Coder 模型,一起 AI Coding。

无论是编码方式构建 AI Agent,还是可视化流程式构建 AI Agent,一旦脱离了 LLM,就不存在 AI 一说了。所以 AI Agent 如何合理地、生产级地与 LLM 结合,将是我们今天文章的核心内容。

阿里云可观测 2025 年 6 月产品动态

Apache RocketMQ 顺应AIGC浪潮,针对长时会话、稀缺算力调度及AI Agent协作等挑战,推出专为AI时代打造的消息引擎。通过“会话即主题”的Lite-Topic机制,实现百万级队列动态管理,保障会话连续性与断点续传;结合智能资源调度能力,如定速消费与优先级队列,提升算力利用率与服务公平性;同时构建高效异步通信枢纽,支撑Agent-to-Agent及AI工作流的非阻塞协同。已在阿里集团与阿里云多个AI产品中大规模验证,助力开发者构建稳定、高效、可扩展的AI应用基础设施。

随着大模型技术的广泛应用,大语言模型(LLM)在对话系统、检索增强生成(RAG)、智能体(Agent)等场景中展现出无限的想象力与创造力。同时,基于 LLM 以及 AI 生态技术栈构建的应用以及业务场景也如雨后春笋般不断涌现。然而,LLM 应用在生产落地过程中面临着模型不确定性大、架构链路复杂、用户体验难以评估等诸多痛点。如何构建 LLM 应用的全链路可观测性体系以及如何评估可观测性能力是否完善,业界缺乏统一且完整细致的标准。

本文对比了两种AI网关——OpenRouter与Higress的定位、功能及演进历程。OpenRouter以简化AI模型调用体验为核心,服务于开发者群体;Higress则基于云原生架构,为企业级AI应用提供全面的流量治理与安全管控能力。两者分别代表了AI网关在不同场景下的发展方向。

阿里云 AI 原生应用开发实战营——Serverless AI 专场将于 2025 年 8 月 1 日在北京举办。活动聚焦 Serverless 架构如何助力 AI 应用解决算力成本高、资源弹性需求高、运维复杂等难题,提供分钟级构建生产级 AI 应用的实战体验。

LoonCollector 是一款轻量级日志采集工具,支持多源安全日志的标准化接入,兼容 Syslog、JSON、CSV 等格式,适用于长亭 WAF、FortiGate、Palo Alto 等主流安全设备。通过灵活配置解析规则,LoonCollector 可将原始日志转换为结构化数据,写入阿里云 SLS 日志库,便于后续查询分析、威胁检测与合规审计,有效降低数据孤岛问题,提升企业安全运营效率。

本文介绍了如何使用 Nacos 3.0.1 与 Higress 配合,实现 HTTP 服务转化为 MCP 协议服务,并支持自动注册与代理。通过 Docker 部署环境,结合 Spring AI Alibaba 框架,可实现服务的自动暴露和动态配置管理,适用于零改造存量应用适配 MCP 协议的场景。

本课程通过通义灵码实现零代码数据分析全流程,涵盖数据读取、清洗、可视化、报告生成及内容仿写,无需编程基础,轻松掌握从CSV导入到PDF报告输出的实战技能。

AI Agent技术架构的演进正在重塑软件工程实践方式。开发者可通过智能编程助手提升效率,也可依托专业框架构建智能体系统。技术生态呈现多维度发展,涵盖高代码与低代码方案,并支持Java和Python等多语言。新型开发范式如AutoGen和LangChain降低了开发门槛。LoongSuite作为可观测采集套件,助力企业高效构建AI时代可观测体系,推动标准化数据规范,提升系统稳定性与运维效率。

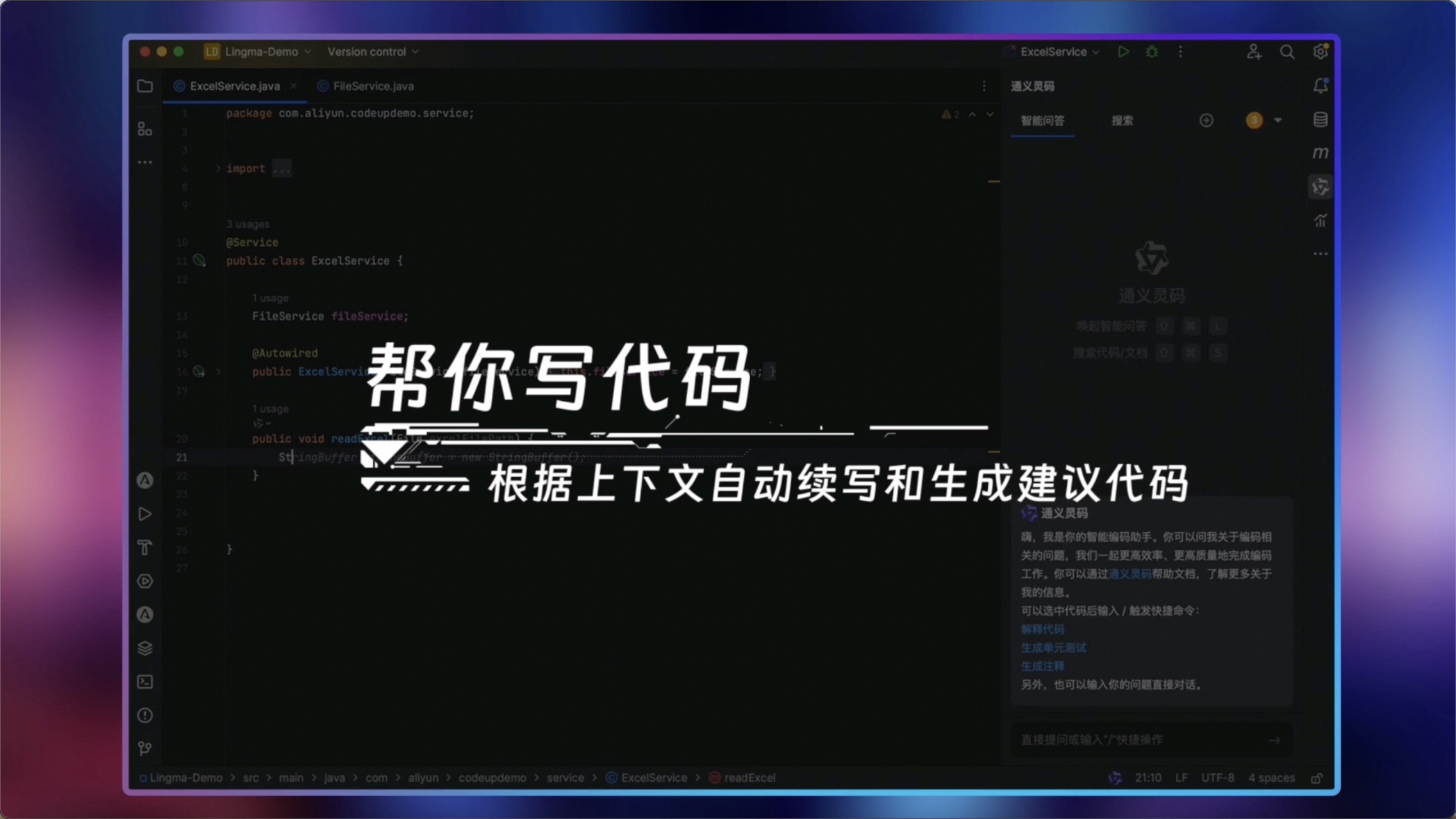

本文深入探讨通义灵码的高阶功能与实用技巧,助你从基础交互迈向精通。内容涵盖项目级理解、精准调试、架构设计协同、高效提示工程及开发流水线集成等多方面,帮助开发者将AI融入深层次工作流。同时提醒用户注意敏感信息保护、保持批判性思维,并关注版本更新与伦理问题。未来,通义灵码将进一步实现深度上下文感知和无缝工具链集成,助力开发者效率革命与思维方式转变。

通义灵码 2.5,支持通过一句话生成可运行的完整应用。用户只需描述需求,如“提醒上下班打卡”,工具即可自动生成代码、安装脚本、打包文件,并创建桌面快捷方式和后台运行设置,极大简化了开发流程。整个过程几乎无需手动编码,让创意快速落地为实际应用。

7 月 25-27 日,Community Over Code Asia 2025 将重返北京。本次会议设有 18 个论坛方向。阿里云云原生应用平台团队将携手开源社区贡献者和用户们,在微服务、消息、可观测、AI 网关领域,分享 16 个议题,欢迎大家报名参加,关注阿里云云原生公众号,在公众号《赠送 10 张三天通票,和我们来畅聊 CommunityOverCode Asia 2025》文章的评论区留言回复“ASFC+你想听的议题”,前 10 名参与互动的用户将获得大会三天通票一张(价值 999 元)。

本文深入解析通义灵码的高阶功能与实用技巧,涵盖项目理解、精准调试、架构协同、提示工程及开发流水线集成等内容,助开发者将AI深度融入工作流。

阿里云可观测 2025 年 4 月产品动态

发表了文章

2025-12-04

发表了文章

2025-12-04

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-03

发表了文章

2025-12-02

发表了文章

2025-12-02

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-27

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-26

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

发表了文章

2025-11-25

回答了问题

2025-07-24

回答了问题

2025-07-24

回答了问题

2025-05-05

回答了问题

2025-05-05

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2025-04-22

回答了问题

2024-10-25

回答了问题

2024-10-25

提交了问题

2024-07-04

提交了问题

2024-07-04

回答了问题

2024-05-29

回答了问题

2024-05-29

回答了问题

2024-05-15

回答了问题

2024-05-15

提交了问题

2024-04-09

提交了问题

2024-04-09

提交了问题

2023-11-06

提交了问题

2023-11-06