能力说明:

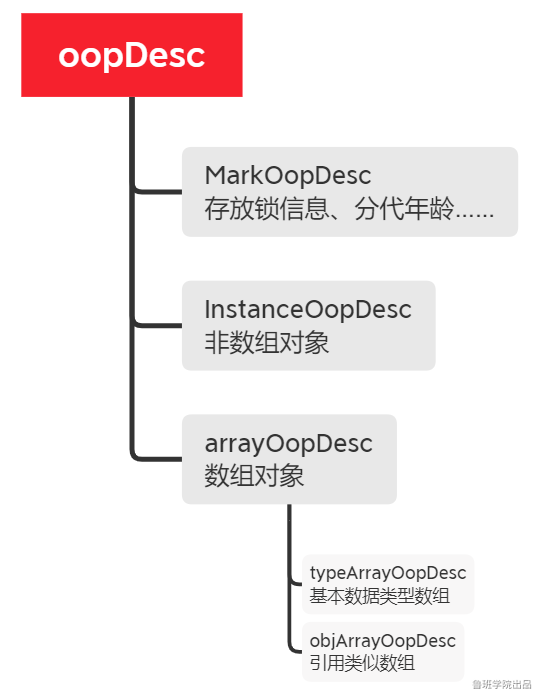

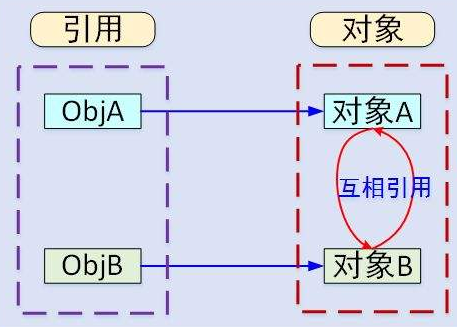

精通JVM运行机制,包括类生命、内存模型、垃圾回收及JVM常见参数;能够熟练使用Runnable接口创建线程和使用ExecutorService并发执行任务、识别潜在的死锁线程问题;能够使用Synchronized关键字和atomic包控制线程的执行顺序,使用并行Fork/Join框架;能过开发使用原始版本函数式接口的代码。

能力说明:

熟悉微服务常用开放框架,理解Spring、Spring Boot,以及Spring Cloud的概念和不同,对Spring Cloud Alibaba有较为全面的认知。对Istio具备基础运维能力,掌握基本组件的知识。

能力说明:

可对MySQL数据库进行备份与恢复,可较为熟练的使用SQL语句进行单表多表查询等操作,可快速上手阿里云RDS MySQL数据库,可进行MySQL云数据库的创建、设置、数据迁移等工作。了解常见NOSQL数据库,如MongoDB、Redis、Memcached的概念、安装、配置等相关基础知识。

暂时未有相关云产品技术能力~

本人csdn 博客地址https://liuyunshengsir.blog.csdn.net/ 推荐的chatgpt地址:http://124.220.104.235/web/chatgpt

2022年06月

回答了问题

2022-06-16 09:09:46

回答了问题

2022-06-16 09:09:46

发表了文章

2022-06-15 19:32:06

发表了文章

2022-06-15 19:32:06

发表了文章

2022-06-15 15:36:56

发表了文章

2022-06-15 15:36:56

发表了文章

2022-06-15 13:47:18

发表了文章

2022-06-15 13:47:18

发表了文章

2022-06-14 15:32:47

发表了文章

2022-06-14 15:32:47

回答了问题

2022-06-11 14:48:00

回答了问题

2022-06-11 14:48:00

发表了文章

2022-06-11 14:44:14

发表了文章

2022-06-11 14:44:14

发表了文章

2022-06-11 14:42:08

发表了文章

2022-06-11 14:42:08

发表了文章

2022-06-11 14:40:20

发表了文章

2022-06-11 14:40:20

发表了文章

2022-06-09 16:42:54

发表了文章

2022-06-09 16:42:54

发表了文章

2022-06-09 16:41:33

发表了文章

2022-06-09 16:41:33

发表了文章

2022-06-09 16:40:48

发表了文章

2022-06-09 16:40:48

发表了文章

2022-06-08 17:41:09

发表了文章

2022-06-08 17:41:09

发表了文章

2022-06-08 17:03:52

发表了文章

2022-06-08 17:03:52

发表了文章

2022-06-08 09:28:12

发表了文章

2022-06-08 09:28:12

发表了文章

2022-06-05 10:58:49

发表了文章

2022-06-05 10:58:49

发表了文章

2022-06-01 15:06:04

发表了文章

2022-06-01 15:06:04

2022年05月

发表了文章

2022-05-31 17:17:01

发表了文章

2022-05-31 17:17:01

回答了问题

2022-05-30 20:55:03

回答了问题

2022-05-30 20:55:03

发表了文章

2022-05-30 20:52:36

发表了文章

2022-05-30 20:52:36

发表了文章

2022-05-29 09:25:56

发表了文章

2022-05-29 09:25:56

发表了文章

2022-05-26 15:53:32

发表了文章

2022-05-26 15:53:32

发表了文章

2022-05-23 17:10:42

发表了文章

2022-05-23 17:10:42

发表了文章

2025-02-10

发表了文章

2025-02-10

发表了文章

2024-12-03

发表了文章

2024-12-03

发表了文章

2024-12-03

发表了文章

2024-12-03

发表了文章

2024-11-13

发表了文章

2024-11-13

发表了文章

2024-11-13

发表了文章

2024-11-13

发表了文章

2024-11-02

发表了文章

2024-11-02

发表了文章

2024-11-02

发表了文章

2024-11-02

发表了文章

2024-10-28

发表了文章

2024-10-28

发表了文章

2024-10-28

发表了文章

2024-10-28

发表了文章

2024-10-26

发表了文章

2024-10-26

发表了文章

2024-10-26

发表了文章

2024-10-26

发表了文章

2024-10-16

发表了文章

2024-10-16

发表了文章

2024-09-25

发表了文章

2024-09-25

发表了文章

2024-09-25

发表了文章

2024-09-25

发表了文章

2024-09-23

发表了文章

2024-09-23

发表了文章

2024-09-23

发表了文章

2024-09-23

发表了文章

2024-09-14

发表了文章

2024-09-14

发表了文章

2024-09-14

发表了文章

2024-09-14

发表了文章

2024-09-09

发表了文章

2024-09-09

发表了文章

2024-09-07

发表了文章

2024-09-07

回答了问题

2025-07-17

回答了问题

2025-07-17

回答了问题

2025-07-17

回答了问题

2025-07-17

回答了问题

2025-06-07

回答了问题

2025-06-07

回答了问题

2025-01-13

回答了问题

2025-01-13

回答了问题

2025-01-07

回答了问题

2025-01-07

回答了问题

2025-01-06

回答了问题

2025-01-06

回答了问题

2024-11-15

回答了问题

2024-11-15

回答了问题

2024-11-15

回答了问题

2024-11-15

回答了问题

2024-11-04

回答了问题

2024-11-04

回答了问题

2024-10-16

回答了问题

2024-10-16

回答了问题

2024-09-26

回答了问题

2024-09-26

回答了问题

2024-09-14

回答了问题

2024-09-14

回答了问题

2024-09-05

回答了问题

2024-09-05

回答了问题

2024-08-30

回答了问题

2024-08-30

回答了问题

2024-08-27

回答了问题

2024-08-27

回答了问题

2024-08-15

回答了问题

2024-08-15

回答了问题

2024-08-12

回答了问题

2024-08-12

回答了问题

2024-08-10

回答了问题

2024-08-10

回答了问题

2024-08-10

回答了问题

2024-08-10

回答了问题

2024-08-10

回答了问题

2024-08-10