GLM4.5推理可以跑通,但是设置精度为FP8再跑就报错了,看上去是不支持FP8,有哪位大佬了解解决方法么?

报错的原因是 raise ValueError(f"Unsupported quant_config: {quant_config}")

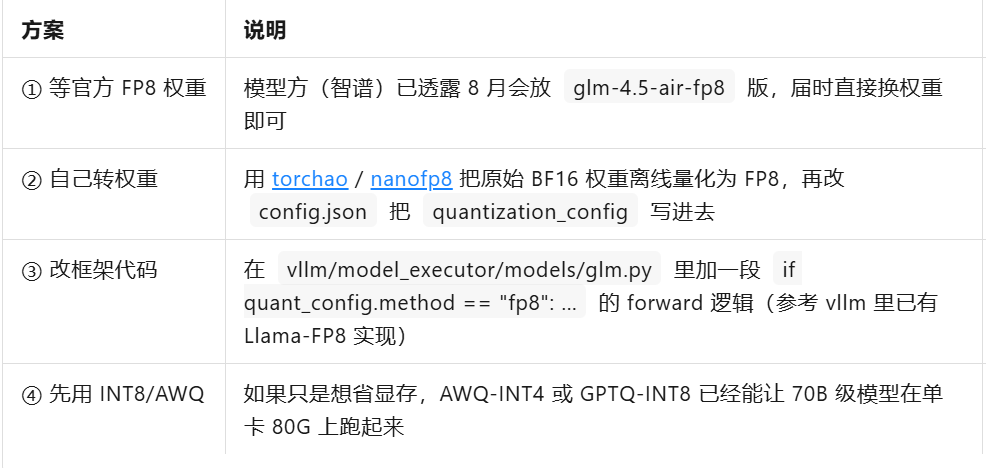

GLM4.5 目前 官方权重和代码都没有放出 FP8 版本,你看到的 raise ValueError(f"Unsupported quant_config: {quant_config}") 是因为:

你传入的 quant_config={"quantmethod":"fp8"}(或 --quantization fp8)

但 GLM4.5 的 modeling*.py 里 只登记了 ["awq","gptq","bnb","eetq"] 等量化方案,没有 "fp8" 这一项,于是被框架直接 ValueError 拦下来。

换句话说——不是 GPU 不支持 FP8,而是模型代码还没写 FP8 分支。

改用 AWQ-INT4(已验证)

vllm serve zai-org/glm-4.5-air-awq \

--quantization awq \

--tensor-parallel-size 2

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352