对于上述通义千问模型的openapi的调用限流,有没有申请取消或增加限流数的途径。60次调用,满足不了目前的需求。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

对于通义千问模型的OpenAPI调用限流,确实存在申请增加限流数的途径。以下是详细说明和操作步骤:

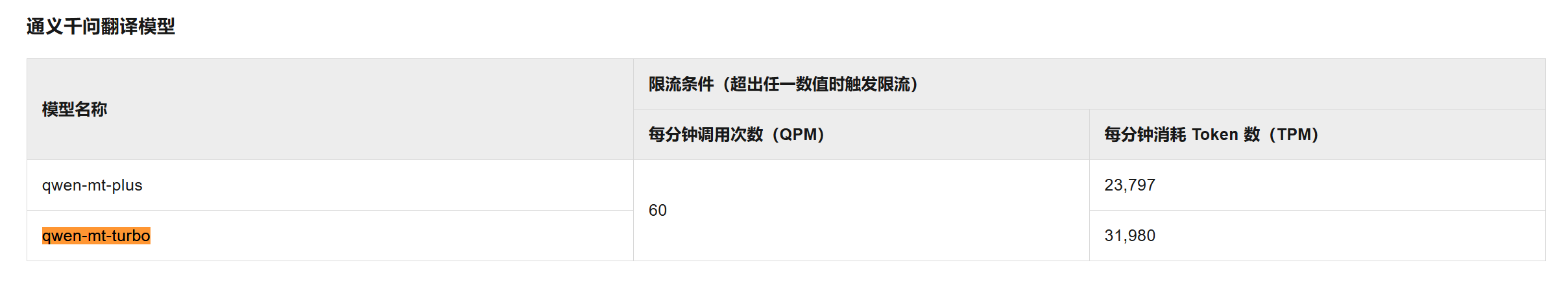

通义千问模型的限流规则是基于模型维度设置的,并与用户的阿里云主账号相关联。限流条件通常包括以下两个维度: - 每分钟调用次数(QPM):例如,某些模型限制为60次/分钟。 - 每分钟消耗Token数(TPM):例如,某些模型限制为100,000 Token/分钟。

如果超出上述任一限制,API请求将因限流而失败,用户需要等待至满足限流条件后才能继续调用。

如果您当前的限流数(如60次/分钟)无法满足需求,可以通过以下方式申请增加限流数:

阿里云提供了扩容申请的渠道,您可以根据实际业务需求申请更高的限流配额。具体步骤如下: 1. 登录阿里云控制台。 2. 进入百炼大模型服务平台。 3. 找到目标模型(如通义千问相关模型),点击查看详情。 4. 在模型详情页面中,查找并点击扩容申请按钮。 5. 填写扩容申请表单,详细说明您的业务场景、预期调用量以及申请的限流数值。 6. 提交申请后,阿里云团队会根据您的需求进行评估,并在一定时间内反馈结果。

如果您在扩容申请过程中遇到问题,或者需要更快速的响应,可以直接联系阿里云的技术支持团队: - 通过阿里云控制台的工单系统提交问题。 - 或拨打阿里云官方客服热线,说明您的需求并请求协助。

部分通义千问模型(如qwen-max和qwen-plus)在使用Batch API调用服务时,不受限流限制。如果您的业务场景允许批量处理请求,建议切换至Batch API以规避限流限制。

text-embedding-async-v1),除了调用频次和Token消耗限制外,还存在并发作业数的限制(如最多3个并发作业)。请确保您的业务逻辑符合这些限制。如果当前的60次/分钟调用限制无法满足需求,建议优先通过扩容申请或技术支持渠道申请增加限流数。同时,评估是否可以通过Batch API或其他优化方式提升调用效率。

希望以上信息能帮助您解决问题!如有进一步疑问,请随时联系阿里云支持团队。

阿里云自主研发的通义大模型,凭借万亿级超大规模数据训练和领先的算法框架,实现全模态高效精准的模型服务调用。https://www.aliyun.com/product/tongyi