在Flink CDC中Oracle 19C CDB +PDB 的模式,多实例的情况,日志分别写在2台服务器,报错找不到对应的归档日志文件。有没有弄过相关案例的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用 Flink CDC (Change Data Capture) 连接 Oracle 19c 的 CDB (Container Database) 和 PDB (Pluggable Database) 时,如果日志分布在不同的服务器上,可能会遇到无法找到对应归档日志文件的错误。这种情况通常发生在配置了 Oracle 的多实例环境,并且使用了分布式日志存储策略。

为了解决这个问题,你需要确保以下几点:

确保归档日志可用:首先确认所有需要的归档日志文件都可用并且可以被访问。这可能意味着需要检查网络连接、文件权限以及归档日志的位置。

配置正确的日志路径:在 Flink CDC 的配置中指定正确的归档日志路径。如果你知道归档日志的确切位置,可以在 Flink CDC 的配置中设置这些路径。

使用 Oracle 网络服务名称:确保你使用的是正确的 Oracle 网络服务名称(TNS),它应该指向正确的数据库实例和日志位置。

同步时间:确保所有服务器的时间都是同步的,因为归档日志的处理依赖于时间戳。

检查 Flink CDC 和 Oracle 和 Oracle 驱动:确保你使用的 Flink CDC 版本和 Oracle JDBC 驱动与你的 Oracle 数据库版本兼容。

查看错误日志:仔细查看 Flink 和 Oracle 的错误日志,以获取更多关于问题的详细信息。

咨询 Oracle DBA:如果你不确定如何配置或解决问题,可以咨询负责管理 Oracle 数据库的 DBA,他们可能能提供更具体的帮助。

考虑使用 Oracle GoldenGate:对于复杂的复制场景,如跨多个服务器分布的日志,可能需要考虑使用更高级的解决方案,比如 Oracle GoldenGate,它可以更好地处理分布式日志和复杂的复制需求。

最后,请确保遵循最佳实践来配置和管理 Flink CDC 与 Oracle 数据库之间的连接,包括正确地设置网络、安全性和性能相关的参数。

在Flink CDC中报错“找不到对应的归档日志文件”是一个常见的问题,尤其是在处理像Oracle这样的数据库时,因为归档日志文件的配置和访问权限可能较为复杂。以下是一些解决此问题的步骤和考虑因素:

一、检查Oracle数据库的归档日志配置

确认归档日志已启用:

使用SELECT log_mode FROM v$database;查询Oracle数据库的日志模式,确保结果为ARCHIVELOG。

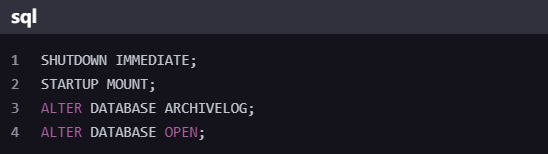

如果未启用归档日志,需要使用以下命令启用:

检查归档日志的存储位置和大小:

使用ALTER SYSTEM SET db_recovery_file_dest = '/path/to/recovery_area' SCOPE=SPFILE;设置归档日志的存储位置。

使用ALTER SYSTEM SET db_recovery_file_dest_size = 10G;设置存储区域的大小。

确认归档日志的保留策略:

在Oracle中,可以通过调整LOG_ARCHIVE_RETENTIONTARGET参数来延长归档日志的保留时间,以避免因日志被自动清理而导致Flink CDC无法读取。

二、检查Flink CDC连接器的配置

确保Flink CDC连接器配置正确:

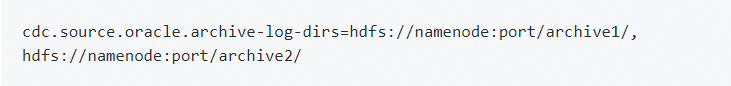

在Flink CDC的配置中,需要确保cdc.source.oracle.archive-log-dirs参数包含了所有归档日志的路径。

如果Oracle的归档日志分布在多台服务器上,需要列出所有服务器上的归档日志路径。

检查网络连接:

确保Flink任务能够访问到所有归档日志所在的服务器。

检查防火墙设置和网络策略,确保没有阻止Flink与Oracle服务器之间的通信。

三、检查Flink作业和数据库日志

查看Flink作业的日志输出:

检查Flink作业的日志,以获取更多关于错误的详细信息。

特别注意与数据库连接和日志读取相关的错误和警告。

查看Oracle数据库的日志:

检查Oracle数据库的警告日志和跟踪文件,以查看是否有与归档日志相关的错误或警告。

四、其他注意事项

确保Flink CDC版本与Oracle版本兼容:

不同版本的Flink CDC可能与不同版本的Oracle数据库存在兼容性问题。

查阅官方文档或社区论坛以获取兼容性信息。

授予Flink CDC用户必要的权限:

确保Flink CDC使用的数据库用户具有访问归档日志和进行日志挖掘的权限。

常见的权限包括LOGMINING、SELECT ON V$LOG、SELECT ON V_$LOG_HISTORY等。

考虑使用共享存储:

Flink CDC在Oracle 19C CDB+PDB模式下,日志分布在多台服务器导致的归档日志找不到的问题,这通常涉及到Oracle的归档日志配置。请检查以下几点:

确保Oracle的归档日志配置正确,包括ARCHIVE LOG DESTinations指向了日志所在的服务器。

Flink CDC连接器的配置是否包含了所有归档日志路径。

检查网络连接,确保Flink任务能访问到所有归档日志服务器。

你要确保Oracle数据库的归档日志保留时间足够长,以避免因日志被自动清理而导致Flink CDC作业无法读取。类似于MySQL的expire_logs_days设置,Oracle中需要关注的是归档日志的保留策略,可能需要调整LOG_ARCHIVE_RETENTION_TARGET参数来延长日志保留时间。

这边是一些其他的报错合集,你看看

https://help.aliyun.com/zh/flink/support/faq-about-cdc?spm=a2c6h.13262185.0.0.122f42e4e8zw1g&scm=20140722.S_help@@%E6%96%87%E6%A1%A3@@470230@@55.S_llmOS0.ID_138028-RL_FlinkCDC%E6%8A%A5%E9%94%99%E6%89%BE%E4%B8%8D%E5%88%B0%E5%BD%92%E6%A1%A3%E6%97%A5%E5%BF%97%E6%96%87%E4%BB%B6Oracle19CCDBP-LOC_chat~DAS~llm-OR_ser-V_3-P0_0

Flink CDC在Oracle 19C CDB + PDB模式下,日志分布在多台服务器导致的归档日志找不到的问题,这通常需要正确配置Oracle的归档日志位置和Flink的CDC连接参数。确保Flink的CDC连接器配置包含了所有归档日志的位置。在配置cdc.source.oracle.archive-log-dirs参数时,列出所有服务器上归档日志的路径。例如:

替换hdfs://namenode:port/archive1/和hdfs://namenode:port/archive2/为实际的服务器路径。并确保Oracle的归档日志配置与Flink的配置一致,且Oracle实例能够正确写入这些位置。

确保已经开启了归档日志,并且归档日志需要存放在所有实例都可以访问的共享存储上。

shutdown immediate;

startup mount;

alter database archivelog;

alter database open;

alter system set db_recovery_file_dest_size = 10G;

alter system set db_recovery_file_dest = '/opt/oracle/oradata/recovery_area' scope=spfile;

为 CDC 创建特定用户并授权

GRANT LOGMINING TO flinkuser;

GRANT SELECT ON V_$LOG TO flinkuser;

GRANT SELECT ON V_$LOG_HISTORY TO flinkuser;

GRANT SELECT ON V_$LOGMNR_CONTENTS TO flinkuser;

GRANT SELECT ON V_$LOGMNR_PARAMETERS TO flinkuser;

GRANT SELECT ON V_$LOGFILE TO flinkuser;

GRANT SELECT ON V_$ARCHIVED_LOG TO flinkuser;

GRANT SELECT ON V_$ARCHIVE_DEST_STATUS TO flinkuser;

目前并没有相关的案例,如下连接仅供参考:

日志服务采集数据常见的错误类型 https://help.aliyun.com/zh/sls/user-guide/log-collection-error-type

采集错误处理逻辑出发,为您提供一些排查和解决思路:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。