DataWorks把oss的 多层目录下的json数据映射 oss外部表, 不知道能做成吗 ,或者有操作步骤吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

SELECT column1, column2 FROM your_table_name;

执行查询:完成上述步骤后,您可以在DataWorks中执行SQL查询,以从OSS上的多层目录下的JSON数据中提取所需的信息。

阿里云DataWorks支持将OSS上的多层目录下的JSON数据映射到OSS外部表。您可以按照以下步骤操作:

登录阿里云DataWorks控制台,创建一个新的项目。

在项目中,选择“数据集成”模块,然后点击“新建源”。

在源类型中选择“OSS”,然后填写相关信息,如OSS的Endpoint、Bucket名称等。

在“路径”字段中,输入您的多层目录路径,例如my-bucket/folder1/folder2/*.json。这将匹配所有位于folder1/folder2目录下的JSON文件。

在“格式”字段中,选择“JSON”。

在“列信息”部分,根据您的JSON文件结构,添加相应的列名和数据类型。

点击“测试连接”,确保配置正确无误。

保存源配置。

接下来,创建一个外部表,将源与外部表关联。在“数据开发”模块中,选择“新建表”,然后选择“外部表”。

在“源”字段中,选择刚刚创建的OSS源。

在“目标表”字段中,输入您希望创建的外部表的名称。

在“列映射”部分,根据源中的列信息,将它们映射到外部表中的相应列。

点击“确定”以创建外部表。

现在,您已经成功将OSS上的多层目录下的JSON数据映射到了OSS外部表。您可以使用SQL或其他数据处理工具对外部表进行查询和分析。

在DataWorks中,您可以将OSS上的多层目录下的JSON数据映射到OSS外部表。以下是实现此功能的步骤:

创建OSS外部表:在DataWorks中,您需要创建一个OSS外部表来引用存储在OSS中的JSON数据。在创建外部表时,需要指定OSS路径、访问密钥等信息。例如,如果您的JSON文件位于oss://your-bucket/path/to/json/files/目录下,可以按照以下格式创建外部表:

sql

复制代码运行

CREATE EXTERNAL TABLE your_table_name (

column1 data_type,

column2 data_type,

...

)

STORED BY 'org.apache.hadoop.hive.hcatalog.data.JsonStorageHandler'

LOCATION 'oss://your-bucket/path/to/json/files/';

请注意,您需要根据实际情况替换your_table_name、column1、column2等占位符,并确保已安装Hive和HCatalog组件。

配置OSS访问权限:为了能够访问OSS上的JSON文件,您需要确保DataWorks项目具有足够的权限。这通常涉及到为项目分配OSS访问密钥(Access Key ID和Access Key Secret)以及设置相应的访问策略。您可以在阿里云控制台中的“AccessKey管理”页面创建和管理访问密钥,并在DataWorks项目的“资源管理”页面中配置OSS访问权限。

编写SQL查询:一旦外部表创建成功,您可以像查询普通数据库表一样编写SQL查询来处理OSS上的JSON数据。例如,假设您的JSON文件中包含一个名为records的数组,您可以使用以下查询来提取其中的数据:

sql

复制代码运行

SELECT * FROM your_table_name;

或者,如果您只想提取特定字段,可以使用以下查询:

sql

复制代码运行

SELECT column1, column2 FROM your_table_name;

执行查询:完成上述步骤后,您可以在DataWorks中执行SQL查询,以从OSS上的多层目录下的JSON数据中提取所需的信息。

需要注意的是,由于OSS上的文件是分布式存储的,因此在处理大量JSON文件时可能会遇到性能问题。此外,如果JSON文件的结构复杂或不一致,可能需要对外部表进行额外的配置或预处理。

根据相关资料,在DataWorks中,如果odps的库表设置了主键,然后进行离线同步时出现了数据重复的情况,可以尝试以

检查同步任务配置:

确保在离线同步任务中正确配置了主键字段。如果主键字段没有正确设置,可能会导致数据重复。

使用调度参数:

在数据集成离线同步任务中,可以使用调度参数来指定同步源表及目标表的数据路径以及数据范围。确保在同步任务运行时,任务中配置的占位符参数都被替换为调度参数表达式所表达的实际值。

你可以使用DataWorks的“数据开发”功能,创建一个新的作业。在作业中,选择“创建表”来创建外部表。在创建外部表时,选择“OSS”作为数据存储类型,并指定JSON作为数据格式。您需要提供OSS Bucket的路径,以及JSON数据的模式(schema)来试试呢

最后定义一个JSON数据中每个字段与外部表列的映射关系,然后就可以连接测试了

在 DataWorks 中将 OSS (Object Storage Service) 中多层目录下的 JSON 数据映射为外部表是可以实现的。以下是详细的步骤和说明:

首先,确保你的 JSON 文件已经上传到了 OSS 的某个 Bucket 中,并且组织成多层目录结构。例如,假设你的文件结构如下:

/oss-bucket-name/

/data/

/year=2023/

/month=01/

/day=01/

file1.json

file2.json

/day=02/

file3.json

/month=02/

/day=01/

file4.json

接下来,你需要创建一个外部表来映射这些 JSON 文件。在 DataWorks 中,可以通过 SQL 语句来创建外部表,并指定路径、文件格式等信息。

CREATE EXTERNAL TABLE IF NOT EXISTS my_json_table (

id INT,

name STRING,

other_column STRING

)

PARTITIONED BY (year STRING, month STRING, day STRING)

ROW FORMAT SERDE 'com.alibaba.maxcompute.hive.json.JsonSerde'

STORED AS TEXTFILE

LOCATION 'oss://oss-bucket-name/data/'

TBLPROPERTIES ('skip.header.line.count'='1');

在这个例子中:

my_json_table 是外部表的名字。id, name, other_column) 应该与 JSON 文件中的数据结构相匹配。PARTITIONED BY 子句用于指定分区列,这里的分区列是 year, month, day。ROW FORMAT SERDE 指定使用 MaxCompute 的 JSON SerDe 来解析 JSON 文件。STORED AS TEXTFILE 指定存储格式为文本文件。LOCATION 指定数据所在的 OSS 路径。TBLPROPERTIES 可以添加一些额外的表属性,这里设置了 skip.header.line.count 为 1,假设 JSON 文件的第一行是表头。创建完外部表后,你可以通过简单的 SQL 查询来测试数据是否正确加载。例如:

SELECT * FROM my_json_table WHERE year='2023' AND month='01' AND day='01';

year, month, day) 需要与 OSS 中的实际文件夹结构一致。可以先去 登录DataWorks控制台,进入 数据开发 页面。

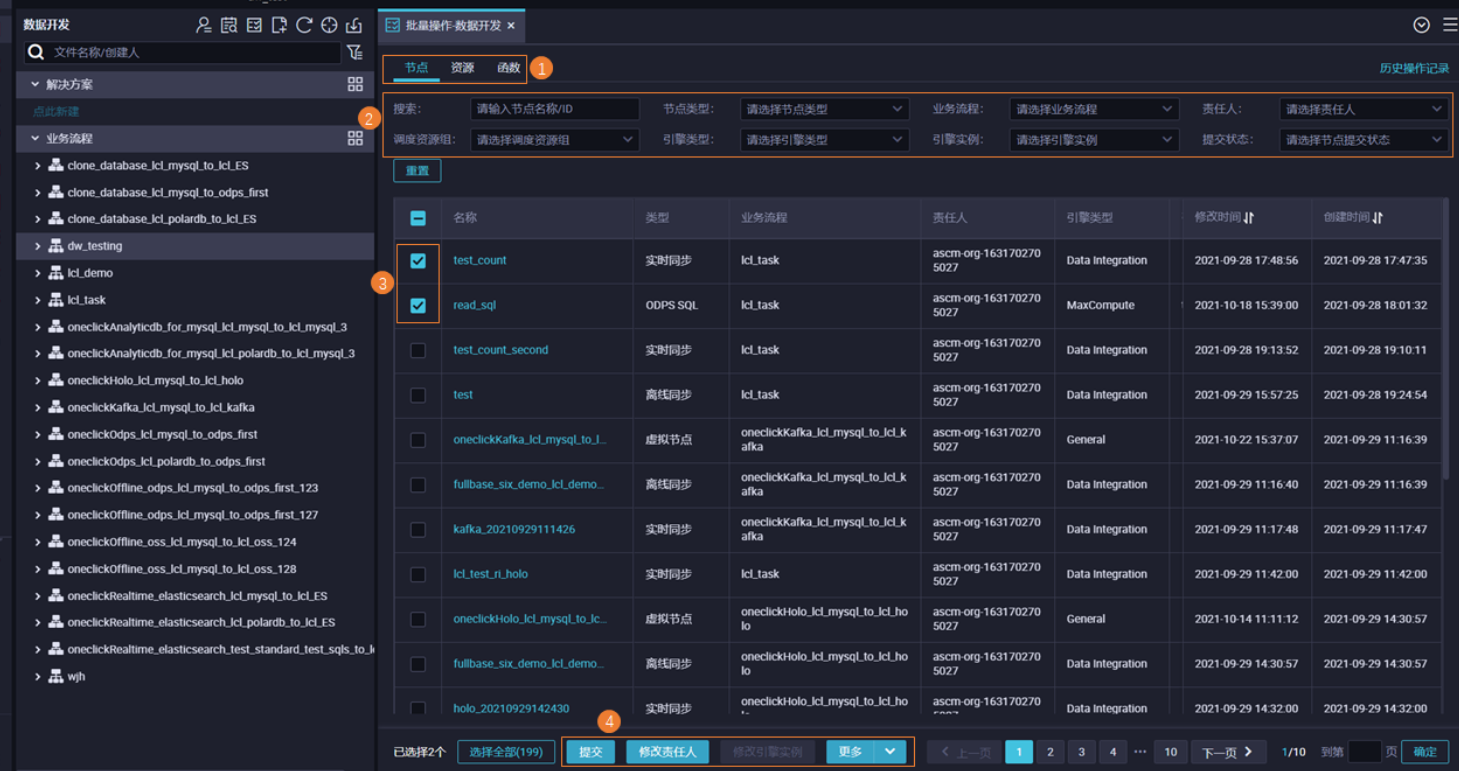

在页面顶部的搜索框中,直接输入关键词“order”,系统会自动列出所有名称中包含该关键词的节点。这将帮助您快速定位到所有与订单相关的节点,不论关键词位于名称中的任何位置。

在搜索结果中,您可能会发现直接批量修改调度周期的功能并不直观。此时,可以采用 批量操作 功能来实现这一需求。

选中您通过搜索找到的、需要修改调度周期的所有节点。通常,您可以通过复选框来选择多个节点。

选择好节点后,查找是否有直接修改调度周期的选项。如果直接修改调度周期的选项不可见,您可能需要通过 批量编辑属性 或进入每个节点的 调度配置 单独调整。

若无直接批量修改调度周期的选项,您可能需要逐个进入这些节点的 调度配置 页面,手动调整时间周期设置。虽然不是最理想的批量处理方式,但在当前界面功能下可能是必要的步骤。

需要创建多个外部表。

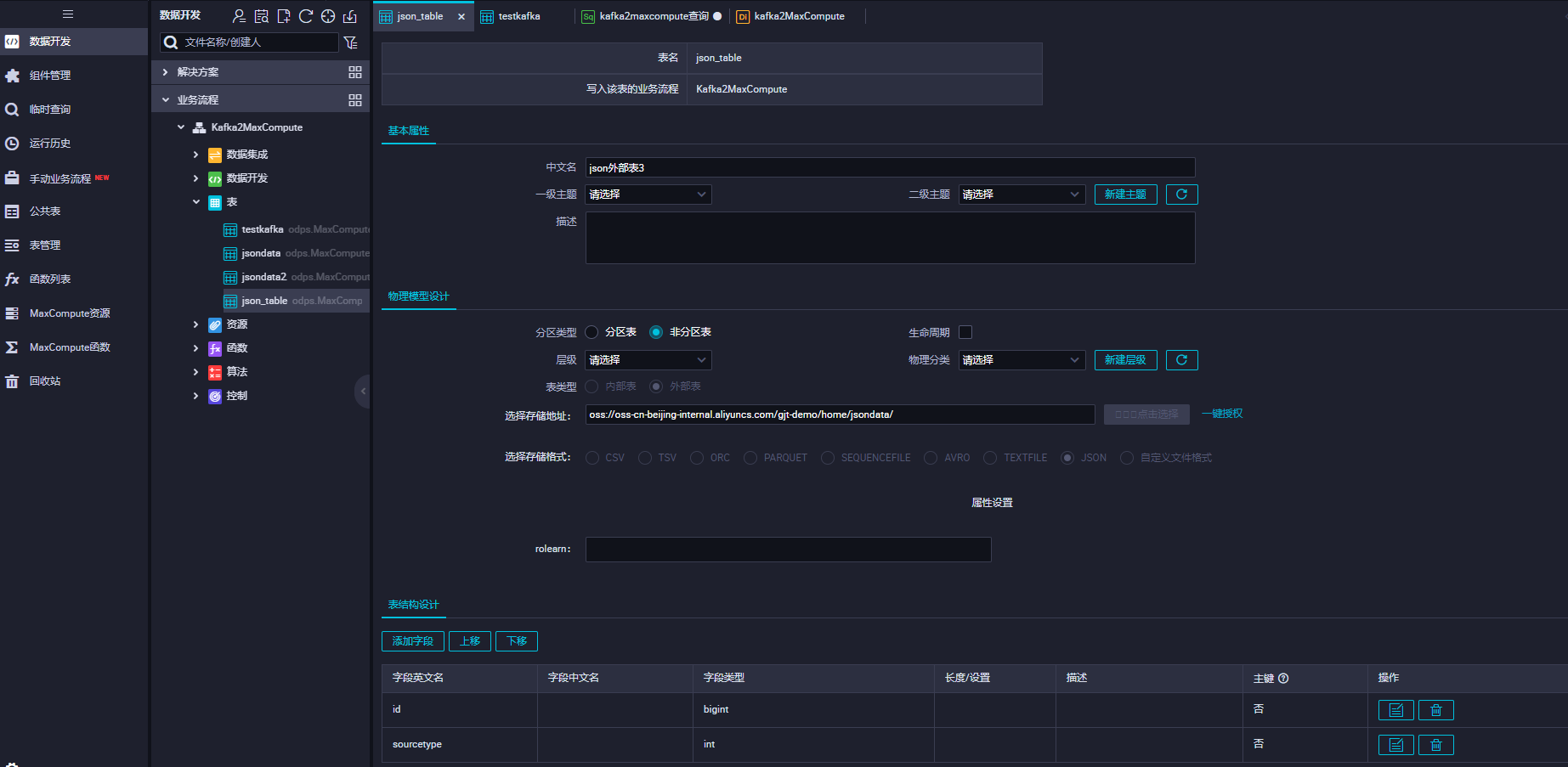

一、打开OSS,上传json文件。

二、登录DataWorks,建立外部表

建表语句:

CREATE EXTERNAL TABLE `json_table` (

`id` bigint,

`sourcetype` int

)

ROW FORMAT SERDE 'org.apache.hive.hcatalog.data.JsonSerDe'

STORED AS TEXTFILE

LOCATION 'oss://oss-cn-beijing-internal.aliyuncs.com/gjt-demo/home/jsondata/';

——参考链接。

配置OSS去向信息。

单击页面上方的OSS,编辑OSS去向源信息。

image.png

配置基本信息。

目标元数据库类型:如果您当前账号下开通了DLF产品,支持同步数据入湖时自动在DLF构建对应的元数据库和元数据表信息。

说明

不支持跨地域构建元数据。

目标库:选择数据写入的目标数据库,支持您单击右侧的新建库创建DLF元数据库。

目标表:选择要写入的OSS表是自动建表还是使用已有表。

表名:填写或者选择要写入的OSS表名。

OSS存储路径选择:选择入湖后数据存储在OSS的哪个路径下。

编辑建表结构。

当选择自动建表时,您需要单击编辑表结构按钮,在弹框中编辑建表结构。同时,支持您单击根据上游节点输出列重新生成表结构按钮,自动根据上游节点输出列,生成表结构。您可以在自动生成的表结构中选择一列配置为主键。

配置字段映射。

保存建表结构或者选择使用已有表时,系统会自动按照同名映射原则生成上游列与OSS表列之间的映射,您可根据需要进行调整,支持一个上游列映射到多个OSS表列,不允许多个上游列映射到一个OSS表列,当上游列未配置到OSS表列的映射时,对应列不会写入OSS表。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。