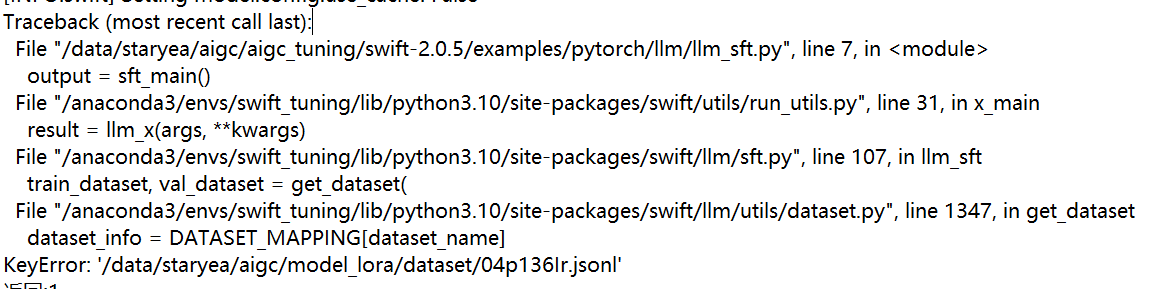

图中ModelScope报错怎么解决?

" 图中ModelScope报错怎么解决?

图中ModelScope报错怎么解决?

!/bin/bash

config_file=""$1""

source ${config_file}

PYTHONPATH=../../.. \

CUDA_VISIBLE_DEVICES=0,1 \

python llm_sft.py \

--model_type qwen-1_8b-chat \

--model_id_or_path ${model_cache_dir} \

--model_revision master \

--sft_type lora \

--lora_rank 8 \

--lora_alpha 32 \

--lora_dropout_p 0.05 \

--lora_target_modules DEFAULT \

--template_type AUTO \

--dtype AUTO \

--output_dir ${output_dir} \

--add_output_dir_suffix false \

--dataset ${custom_train_dataset_path} \

--check_model_is_latest false \

--train_dataset_sample -1 \

--num_train_epochs ${num_train_epochs} \

--max_length ${max_length} \

--check_dataset_strategy warning \

--gradient_checkpointing true \

--batch_size ${batch_size} \

--weight_decay 0.1 \

--learning_rate ${learning_rate} \

--gradient_accumulation_steps 16 \

--max_grad_norm 0.5 \

--warmup_ratio 0.03 \

--eval_steps 100 \

--save_steps ${save_steps} \

--save_only_model true \

--save_total_limit ${save_total_limit} \

--logging_steps 10 \

--tuner_backend peft \

--use_flash_attn false \

--neftune_noise_alpha ${neftune_noise_alpha} \

--train_dataset_mix_ratio ${train_dataset_mix_ratio} \

--self_cognition_sample ${self_cognition_sample} \

--model_name ${model_name} \

--model_author ${model_author} \

${resume_from_checkpoint} \"

-

自我认知微调,您参考这个文档和命令行参数改下,参考以下链接 https://github.com/modelscope/swift/blob/main/docs/source/LLM/%E8%87%AA%E6%88%91%E8%AE%A4%E7%9F%A5%E5%BE%AE%E8%B0%83%E6%9C%80%E4%BD%B3%E5%AE%9E%E8%B7%B5.md 此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

2024-06-04 19:22:41赞同 展开评论

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352