DataWorks生成环境怎么list?我直接show function ,发现函数是和库绑定的,只有一个 dev库.{自定义函数名},我生产环境对应的 库下没有对应的.{自定义函数名}

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

不同依赖方式:DataWorks支持同周期依赖、跨周期依赖等多种依赖配置方式,每种方式对调度时间和周期的展示需求不同。

自定义依赖关系:用户可以手动配置特定的依赖关系,这可能涉及到不直接展示调度信息的特定场景。

调度依赖的配置复杂性

在阿里云DataWorks中,生成环境(通常指的是生产环境或正式环境)的管理并不直接涉及到一个名为“list”的单一操作,因为DataWorks的环境管理更多是关于环境的配置、部署和监控。然而,你可以通过几种方式来查看、管理和操作你的生成环境(或任何DataWorks环境)。

以下是一些步骤和考虑因素,帮助你管理和查看DataWorks的生成环境:

登录DataWorks控制台:

首先,你需要使用你的阿里云账号登录到DataWorks控制台。

查看项目列表:

在DataWorks控制台中,你会看到一个或多个项目的列表。每个项目都可以配置多个环境,包括开发环境、测试环境和生成环境(或称为生产环境)。

选择项目并查看环境:

点击你想要管理的项目,进入项目详情页面。在项目详情页面,你可以看到配置的环境列表。通常,这些环境会按照开发、测试、生产的顺序排列,但具体名称可能因项目而异。

管理环境:

在环境列表中,你可以执行多种操作,如编辑环境配置、查看环境详情、部署项目到特定环境等。虽然没有一个直接的“list”操作来列出所有环境的详细信息,但你可以通过查看每个环境的配置和状态来获取所需的信息。

查看环境配置:

点击某个环境旁边的“详情”或类似按钮,你可以查看该环境的详细配置信息,包括调度配置、数据源配置、资源组配置等。

使用API或SDK:

如果你需要自动化地管理或查询DataWorks环境,你可以考虑使用阿里云提供的API或SDK。通过编程方式,你可以列出所有环境、查询环境配置、执行环境操作等。但请注意,使用API或SDK需要一定的编程技能和阿里云账号的API访问权限。

联系技术支持:

如果你对DataWorks的环境管理有任何疑问或需要进一步的帮助,你可以联系阿里云的技术支持团队。

需要注意的是,DataWorks的环境管理是一个相对复杂的过程,涉及多个方面和配置。因此,在进行任何操作之前,请确保你已经仔细阅读了相关的文档和指南,并了解你的项目需求和阿里云的政策。

此外,由于阿里云的产品和服务会不断更新和改进,上述步骤和界面可能会有所变化。因此,建议参考最新的阿里云DataWorks文档来获取最准确的信息。

要在DataWorks中查看生产环境下的自定义函数列表,您可以按照以下步骤操作:

登录DataWorks控制台:首先,登录到阿里云DataWorks控制台,确保您已经选择了正确的地域和工作空间。

进入数据开发页面:在左侧导航栏中,点击“数据建模与开发” > “数据开发”,并选择您的目标工作空间后点击“进入数据开发”。

查看MaxCompute函数:在数据开发页面的左侧导航栏中找到“MaxCompute”,展开后点击“MaxCompute函数”。这里会列出与您的工作空间绑定的MaxCompute项目中的所有已注册函数,默认情况下是按照创建时间倒序排列的。

切换环境查看生产函数:由于您提到在开发环境下看到了函数,但在生产环境中没有看到对应的自定义函数,您需要在“MaxCompute函数”页面检查是否当前显示的是生产环境。如果默认显示的是开发环境(dev库),请查找是否有图标用于切换环境。注意,如果您的工作空间是简单模式,可能只支持生产环境

直接使用命令查询:如果在界面中未能直接找到生产环境的函数,您也可以考虑使用MaxCompute的命令行工具,在命令行中执行SHOW FUNCTIONS;来查看所有已注册的函数,包括生产环境的。但请注意,通过这种方式查看的函数列表可能包含延迟

确认函数发布状态:确保您的自定义函数已经在生产环境中被正确发布。在DataWorks中开发的函数,从开发环境到生产环境需要经过发布流程。如果函数仅在开发环境创建而未发布到生产环境,那么在生产环境的库下自然找不到对应的函数。

通过以上步骤,您应该能够定位到生产环境下的自定义函数。如果仍然没有找到,可能是因为函数尚未被正确发布到生产环境,或者存在其他配置问题,此时需要检查函数的部署和发布流程是否完整执行。

相关链接 https://help.aliyun.com/zh/dataworks/user-guide/create-and-use-custom-functions

在DataWorks中配置和使用节点依赖是保障数据正确性和实现有效调度的重要手段。然而,用户在实际使用过程中可能会遇到上游节点的调度周期和调度时间没有直接显示出来的情况,这可能会给任务管理和调度带来一些不便。以下是对此问题的详细分析:

设计理念与信息展示优先级

界面设计的简化:DataWorks的设计可能更倾向于简化用户界面,避免展示过多的细节信息,以减少用户的认知负担。

关键信息优先:平台更注重于显示任务状态和基本的依赖关系,而非每个任务的具体调度时间,因为这些信息对于日常操作来说已经足够。

技术与性能考虑

性能优化:在涉及大量任务和依赖关系的复杂情况下,减少计算负载是必要的,过多的详细信息可能会影响系统的整体性能。

动态调度参数:DataWorks支持动态替换调度参数,因此实际的调度时间可能在任务执行前才被确定,而不是一个固定的值,这导致难以提前显示具体时间。

用户体验与功能性权衡

信息检索层级:将详细的调度信息放在更深层的任务配置页面中,既可以保持界面的简洁,也能满足需要详细数据的用户。

依赖关系的直观展示:DAG图等工具更侧重于直观展示任务间的逻辑关系,帮助用户快速理解上下游任务的依赖结构。

节点依赖配置的多样性

不同依赖方式:DataWorks支持同周期依赖、跨周期依赖等多种依赖配置方式,每种方式对调度时间和周期的展示需求不同。

自定义依赖关系:用户可以手动配置特定的依赖关系,这可能涉及到不直接展示调度信息的特定场景。

调度依赖的配置复杂性

复杂的业务需求:在实际的业务场景中,调度依赖可能涉及到多任务、多周期的复杂关系,这使得简单的展示变得困难。

依赖关系的传递性:某些任务可能继承或传递其依赖属性给子任务,这进一步增加了调度信息展示的复杂度。

监控与日志功能

使用监控和日志:尽管调度周期和时间不在默认视图中直接显示,但用户可以通过访问任务实例的运行记录、监控页面或系统日志来获取这些信息。

此外,在深入分析了上述多个角度后,可以提出以下建议和注意事项以帮助用户更好地理解和使用DataWorks的调度依赖功能:

确保数据准确性:在使用自定义依赖或跨周期依赖时,务必确认表血缘关系和业务需求,以确保数据的准确传递和处理。

利用高级配置:利用DataWorks提供的高级配置选项,如空跑属性的跨周期不传导,以适应特定的业务逻辑需求。

预览依赖关系:在复杂的调度场景中,通过DataWorks的预览依赖功能,检查各周期实例的依赖关系是否符合预期,以避免生产调度延迟。

总的来说,虽然DataWorks在默认情况下可能不会直接显示所有上游节点的调度周期和时间,但用户仍然可以通过多种途径访问这些信息。理解背后的设计理念、技术原因及操作策略对于有效使用DataWorks至关重要。同时,通过合理配置和利用现有的工具和功能,用户可以充分掌控他们的数据工作流程,确保数据的准确性和及时性。

在DataWorks中,管理不同环境(如开发环境、测试环境、生产环境)的任务和资源通常是在项目级别上进行的。这意味着每个环境都有它自己的项目空间,而函数、表和其他资源则是在各自的项目空间内定义的。

当你提到“生成环境”时,我假设你是想说“生产环境”。如果你在生产环境中找不到相应的自定义函数,那可能是因为该函数尚未被部署到生产环境的项目中。

下面是一些步骤和建议来帮助你列出生产环境中的函数,并解决你遇到的问题:

登录DataWorks控制台:

选择正确的项目:

prod 或者 production。查看UDF列表:

检查函数是否已部署:

查看函数命名规则:

检查权限:

联系项目管理员:

手动部署函数:

如果你想通过SQL查询的方式来查看生产环境中的函数,可以使用如下命令:

SHOW FUNCTIONS IN {project_name};

这里的 {project_name} 需要替换为你生产环境项目的实际名称。

如果您在开发环境中创建了一些自定义函数,但未在生成环境中部署,那么在生成环境中自然找不到这些函数。DataWorks中查看生成环境资源列表:

检查函数是否部署:

如果您在生成环境的库下没有找到自定义函数,可能是因为:

要查看生产环境下的自定义函数列表,是不能直接使用SQL命令SHOW FUNCTIONS来跨环境查询函数。这是因为SHOW FUNCTIONS命令只会列出与当前DataWorks工作空间绑定的MaxCompute项目中已注册的函数,通常这会是开发环境(dev库)中的函数,

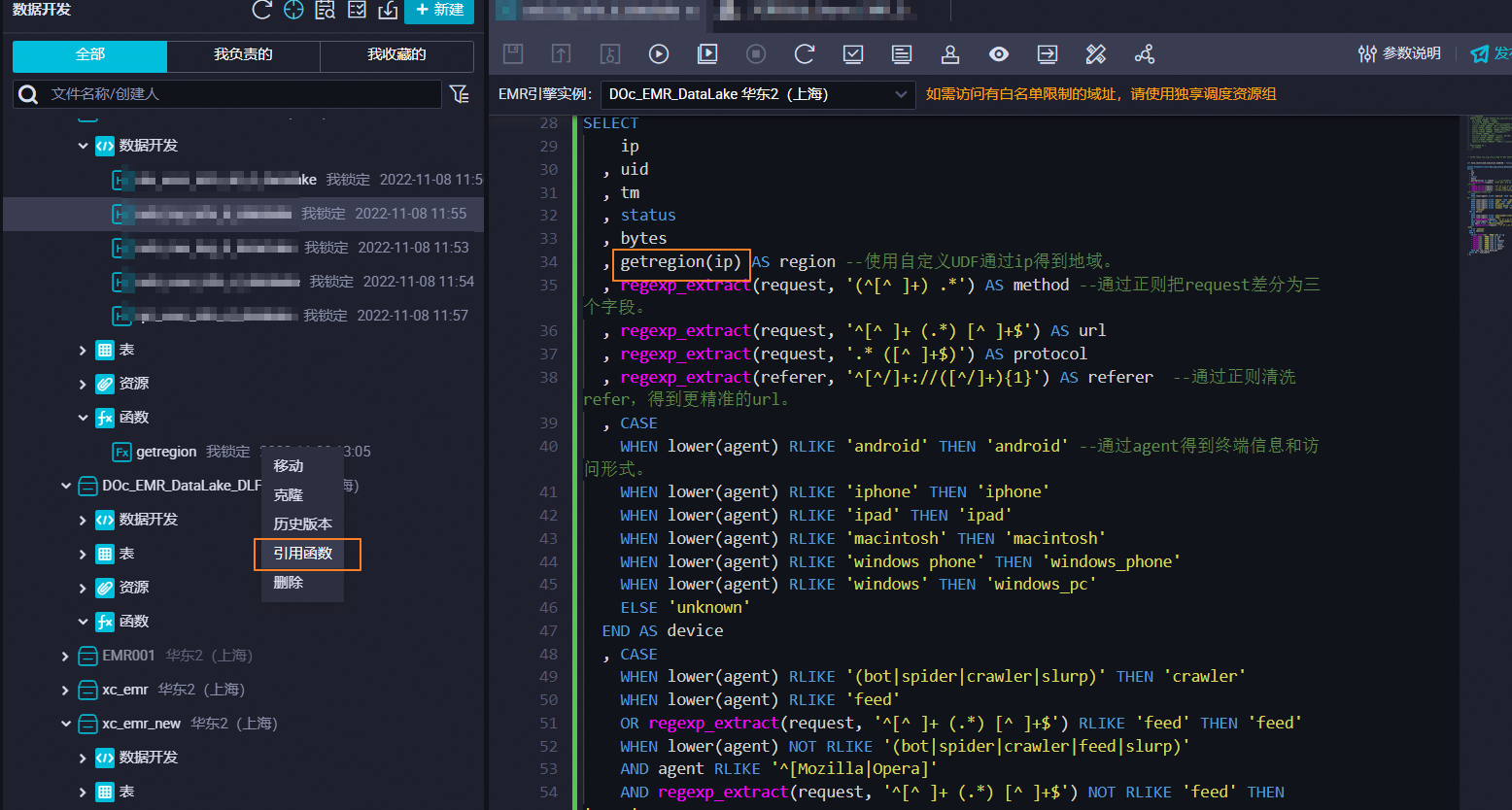

还有在MaxCompute项目下,右键点击函数所在的目录或直接在函数管理界面,虽然直接使用SQL命令不适用,但DataWorks提供了图形化界面来浏览不同环境下的资源,包括函数

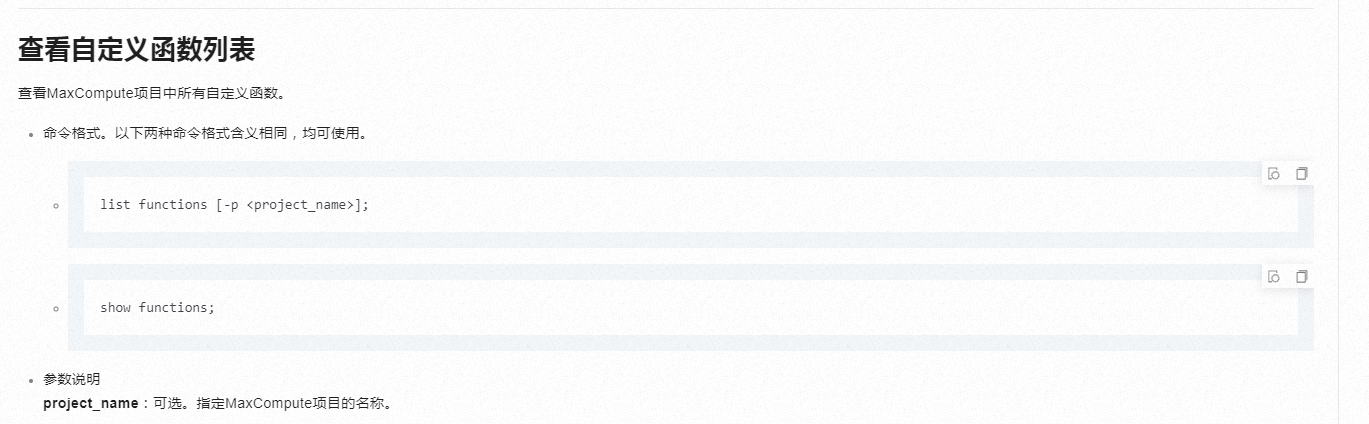

查看MaxCompute项目中所有自定义函数。

命令格式。以下两种命令格式含义相同,均可使用。

list functions [-p <project_name>];

show functions;

比如

list functions;

返回结果如下。

Name Owner Create Time Class Resources

ipv4_ipv6_aton ALIYUN$****@aliyun.com 2021-11-15 13:42:14 com.aliyun.odps.udf.udfFunction.IpLocation ipv4.txt,ipv6.txt,udf-1.0-SNAPSHOT.jar

Lower_test ALIYUN$****@aliyun.com 2021-08-25 15:51:22 com.aliyun.odps.udf.example.Lower udf-1.0-SNAPSHOT.jar

my_add ALIYUN$****@aliyun.com 2021-05-08 11:26:02

my_index ALIYUN$****@aliyun.com 2021-08-25 12:01:05 com.aliyun.odps.examples.udf.UdfArray udf-1.0-SNAPSHOT.jar

my_sum ALIYUN$****@aliyun.com 2021-05-08 10:24:58

my_udtf ALIYUN$****@aliyun.com 2021-02-23 11:37:30 com.aliyun.odps.examples.udf.UDTFResource udf-1.0-SNAPSHOT.jar

numpy ALIYUN$****@aliyun.com 2020-11-11 14:12:50 numpy.TryImport numpy.py,numpy-1.19.4-cp37-cp37m-manylinux1_x86_64.zip

ST_Aggr_ConvexHull ALIYUN$****@aliyun.com 2021-03-18 17:06:29 com.esri.hadoop.hive.ST_Aggr_ConvexHull esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Aggr_Intersection ALIYUN$****@aliyun.com 2021-03-18 17:06:29 com.esri.hadoop.hive.ST_Aggr_Intersection esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Aggr_Union ALIYUN$****@aliyun.com 2021-03-18 17:06:30 com.esri.hadoop.hive.ST_Aggr_Union esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Area ALIYUN$****@aliyun.com 2021-03-18 17:06:30 com.esri.hadoop.hive.ST_Area esri-geometry-api.jar,spatial-sdk-hive.jar

ST_AsBinary ALIYUN$****@aliyun.com 2021-03-18 17:06:30 com.esri.hadoop.hive.ST_AsBinary esri-geometry-api.jar,spatial-sdk-hive.jar

ST_AsGeoJson ALIYUN$****@aliyun.com 2021-03-18 17:06:49 com.esri.hadoop.hive.ST_AsGeoJson esri-geometry-api.jar,spatial-sdk-hive.jar

ST_AsJson ALIYUN$****@aliyun.com 2021-03-18 17:06:50 com.esri.hadoop.hive.ST_AsJson esri-geometry-api.jar,spatial-sdk-hive.jar

ST_AsShape ALIYUN$****@aliyun.com 2021-03-18 17:06:50 com.esri.hadoop.hive.ST_AsShape esri-geometry-api.jar,spatial-sdk-hive.jar

ST_AsText ALIYUN$****@aliyun.com 2021-03-18 17:06:50 com.esri.hadoop.hive.ST_AsText esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Bin ALIYUN$****@aliyun.com 2021-03-18 17:06:50 com.esri.hadoop.hive.ST_Bin esri-geometry-api.jar,spatial-sdk-hive.jar

ST_BinEnvelope ALIYUN$****@aliyun.com 2021-03-18 17:07:01 com.esri.hadoop.hive.ST_BinEnvelope esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Boundary ALIYUN$****@aliyun.com 2021-03-18 17:07:01 com.esri.hadoop.hive.ST_Boundary esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Buffer ALIYUN$****@aliyun.com 2021-03-18 17:07:01 com.esri.hadoop.hive.ST_Buffer esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Centroid ALIYUN$****@aliyun.com 2021-03-18 17:07:01 com.esri.hadoop.hive.ST_Centroid esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Contains ALIYUN$****@aliyun.com 2021-03-18 17:07:01 com.esri.hadoop.hive.ST_Contains esri-geometry-api.jar,spatial-sdk-hive.jar

ST_ConvexHull ALIYUN$****@aliyun.com 2021-03-18 17:07:13 com.esri.hadoop.hive.ST_ConvexHull esri-geometry-api.jar,spatial-sdk-hive.jar

ST_CoordDim ALIYUN$****@aliyun.com 2021-03-18 17:07:14 com.esri.hadoop.hive.ST_CoordDim esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Crosses ALIYUN$****@aliyun.com 2021-03-18 17:07:14 com.esri.hadoop.hive.ST_Crosses esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Difference ALIYUN$****@aliyun.com 2021-03-18 17:07:14 com.esri.hadoop.hive.ST_Difference esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Dimension ALIYUN$****@aliyun.com 2021-03-18 17:07:14 com.esri.hadoop.hive.ST_Dimension esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Disjoint ALIYUN$****@aliyun.com 2021-03-18 17:07:31 com.esri.hadoop.hive.ST_Disjoint esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Distance ALIYUN$****@aliyun.com 2021-03-18 17:07:31 com.esri.hadoop.hive.ST_Distance esri-geometry-api.jar,spatial-sdk-hive.jar

ST_EndPoint ALIYUN$****@aliyun.com 2021-03-18 17:07:31 com.esri.hadoop.hive.ST_EndPoint esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Envelope ALIYUN$****@aliyun.com 2021-03-18 17:07:32 com.esri.hadoop.hive.ST_Envelope esri-geometry-api.jar,spatial-sdk-hive.jar

ST_EnvIntersects ALIYUN$****@aliyun.com 2021-03-18 17:07:32 com.esri.hadoop.hive.ST_EnvIntersects esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Equals ALIYUN$****@aliyun.com 2021-03-18 17:07:44 com.esri.hadoop.hive.ST_Equals esri-geometry-api.jar,spatial-sdk-hive.jar

ST_ExteriorRing ALIYUN$****@aliyun.com 2021-03-18 17:07:44 com.esri.hadoop.hive.ST_ExteriorRing esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeodesicLengthWGS84 ALIYUN$****@aliyun.com 2021-03-18 17:07:44 com.esri.hadoop.hive.ST_GeodesicLengthWGS84 esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomCollection ALIYUN$****@aliyun.com 2021-03-18 17:07:44 com.esri.hadoop.hive.ST_GeomCollection esri-geometry-api.jar,spatial-sdk-hive.jar

ST_Geometry ALIYUN$****@aliyun.com 2021-03-18 17:07:44 com.esri.hadoop.hive.ST_Geometry esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeometryN ALIYUN$****@aliyun.com 2021-03-18 17:07:55 com.esri.hadoop.hive.ST_GeometryN esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeometryType ALIYUN$****@aliyun.com 2021-03-18 17:07:55 com.esri.hadoop.hive.ST_GeometryType esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomFromGeoJson ALIYUN$****@aliyun.com 2021-03-18 17:07:55 com.esri.hadoop.hive.ST_GeomFromGeoJson esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomFromJson ALIYUN$****@aliyun.com 2021-03-18 17:07:55 com.esri.hadoop.hive.ST_GeomFromJson esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomFromShape ALIYUN$****@aliyun.com 2021-03-18 17:07:56 com.esri.hadoop.hive.ST_GeomFromShape esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomFromText ALIYUN$****@aliyun.com 2021-03-18 17:08:10 com.esri.hadoop.hive.ST_GeomFromText esri-geometry-api.jar,spatial-sdk-hive.jar

ST_GeomFromWKB ALIYUN$****@aliyun.com 2021-03-18 17:08:10 com.esri.hadoop.hive.ST_GeomFromWKB esri-geometry-api.jar,spatial-sdk-hive.jar

——参考链接。

在DataWorks控制台中查看函数列表的具体操作如下:

登录DataWorks控制台,单击左侧导航栏的数据建模与开发 > 数据开发,在下拉框中选择对应工作空间后单击进入数据开发。

单击左侧导航栏中的函数列表,即可查看相应的函数。您可单击相应函数,查看函数的具体说明。

函数列表中包括以下几种类型:

日期与时间函数

数学函数

窗口函数

聚合函数

字符串函数

复杂类型函数

加密函数

其他函数

参考文档https://help.aliyun.com/zh/dataworks/user-guide/functions?spm=a2c4g.11186623.0.i208

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。