Transformer架构为何能统治NLP领域?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

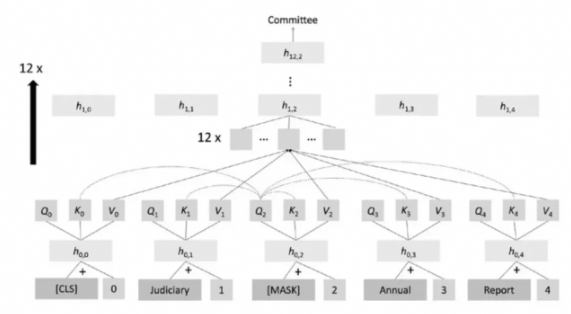

Transformer架构通过引入注意力机制(Attention),使得模型能够关注输入序列中的关键信息,从而提高了模型的性能。这种简单但通用的结构让Transformer模型在NLP领域取得了革命性的突破。