Flink out文件里面的内容再哪里定义啊?为什么我终端的东西没有写进去?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Apache Flink 中,"out" 文件通常是指 Flink 作业的日志文件。Flink 任务的日志输出可以在多个地方进行配置和查看,通常包括 TaskManager 和 JobManager 的日志。

配置日志输出

Flink 使用 Log4j 作为日志记录框架,日志配置文件(log4j.properties 或 log4j2.xml)位于 Flink 的配置目录中(通常在 conf 目录下)。你可以通过修改这些配置文件来定义日志的输出位置和内容。

查看日志文件

JobManager 和 TaskManager 的日志文件:

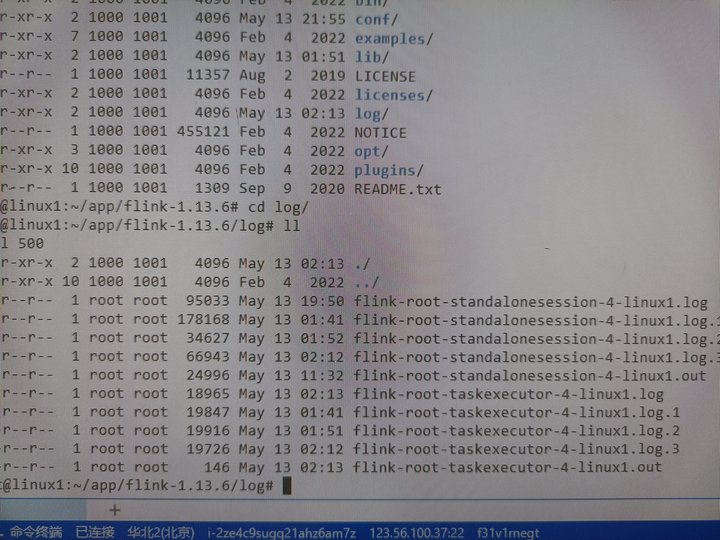

默认情况下,Flink 会将 JobManager 和 TaskManager 的日志文件保存在 log 目录下。你可以通过查看这些文件来获取日志信息。

例如,在 flink/log 目录中,你可以找到类似 jobmanager.log 和 taskmanager.log 的文件。

日志配置文件:

conf/log4j.properties 或 conf/log4j2.xml 文件中定义了日志的输出位置和级别。你可以修改这些文件来更改日志的输出配置。

示例:修改 log4j.properties

假设你使用的是 Log4j 1.x 版本的配置文件 log4j.properties,可以像下面这样进行配置:

# Define the root logger with appender file

log4j.rootLogger=INFO, file

# Define the file appender

log4j.appender.file=org.apache.log4j.FileAppender

log4j.appender.file.File=flink-out.log

log4j.appender.file.layout=org.apache.log4j.PatternLayout

log4j.appender.file.layout.ConversionPattern=%d{ISO8601} [%t] %-5p %c{1} - %m%n

# Define the console appender

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.Target=System.out

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d{ISO8601} [%t] %-5p %c{1} - %m%n

# Set the logger level for specific classes

log4j.logger.org.apache.flink=INFO

在这个例子中,日志将被输出到 flink-out.log 文件中。

示例:修改 log4j2.xml

如果你使用的是 Log4j 2.x 版本的配置文件 log4j2.xml,可以像下面这样进行配置:

<Configuration status="WARN">

<Appenders>

<Console name="Console" target="SYSTEM_OUT">

<PatternLayout pattern="%d{ISO8601} [%t] %-5p %c{1} - %m%n"/>

</Console>

<File name="File" fileName="flink-out.log">

<PatternLayout pattern="%d{ISO8601} [%t] %-5p %c{1} - %m%n"/>

</File>

</Appenders>

<Loggers>

<Root level="info">

<AppenderRef ref="Console"/>

<AppenderRef ref="File"/>

</Root>

<Logger name="org.apache.flink" level="info" additivity="false">

<AppenderRef ref="Console"/>

<AppenderRef ref="File"/>

</Logger>

</Loggers>

</Configuration>

在这个例子中,日志将被输出到 flink-out.log 文件中,同时也会被输出到控制台。

检查日志输出

如果你发现终端中的输出没有写入到日志文件中,可能是由于以下原因:

日志级别设置:确保日志级别设置正确。例如,如果日志级别设置为 INFO,但是你打印的是 DEBUG 级别的日志,那么这些日志不会被记录下来。

日志配置文件路径:确保 Flink 使用了正确的日志配置文件。可以通过检查 Flink 启动脚本和配置文件来确认。

日志刷新:有时候日志文件可能没有及时刷新到磁盘。你可以尝试手动刷新日志或者等待一段时间再检查日志文件。

通过以上配置和检查,你应该能够找到并定义 Flink 的日志输出位置,并确保终端中的输出能够正确写入到日志文件中。

在Apache Flink中,输出文件(如你提到的"out"文件)的内容通常是在你的Flink作业中通过定义数据流的处理逻辑来确定的。Flink作业可以读取输入数据,进行一系列转换(transformations),并最终写入到输出目标中,比如文件、数据库或其他存储系统。

如果你发现终端(控制台)的输出没有写入到文件中,这可能是因为几个原因:

输出目标未正确配置:

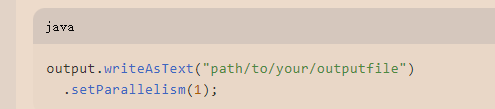

确保你的Flink作业中配置了正确的输出路径和输出方式。例如,如果你使用的是DataStream API,你可能会使用writeAsText(), writeUsingOutputFormat(), 或者addSink()方法来指定输出。

对于文件输出,通常我们会使用BucketingSink或FileSink(在Flink 1.11及更高版本中引入)来管理文件的写入。

并行度问题:

Flink作业的并行度(parallelism)可能影响数据的输出。如果你的作业配置了多个并行任务,但输出配置没有正确处理并行写入,可能会导致数据写入到不同的文件或文件被覆盖。

异常处理:

确保你的Flink作业没有遇到异常或错误,这些可能会阻止数据的正常处理和输出。

查看日志:

查看Flink作业的日志,这可能会给出为什么数据没有写入文件的线索。你可以检查作业管理器的日志(如YARN、Kubernetes等)或Flink集群的日志文件。

Flink版本和配置:

确保你使用的Flink版本支持你的输出配置。不同的Flink版本可能在API或配置方面有所不同。

检查Flink的配置文件(如flink-conf.yaml),看是否有与输出相关的配置被错误地设置。

代码示例:

以下是一个简单的Flink作业示例,该作业读取文本文件,进行一些转换,并将结果写入到另一个文本文件中:

link的out文件通常是指应用程序中输出结果的文件,它的位置和命名可以在Flink应用程序的代码中定义。例如,如果你在使用Flink的DataStream API编写应用程序,你可能会在程序的某个地方看到类似这样的代码:

这里的 "path/to/your/outputfile" 就是输出文件的路径,你需要根据你的实际需求来设置这个路径。

如果没有写入的话可能是你的目录权限问题,没有这个目录或者权限有问题,建议检查一下

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。