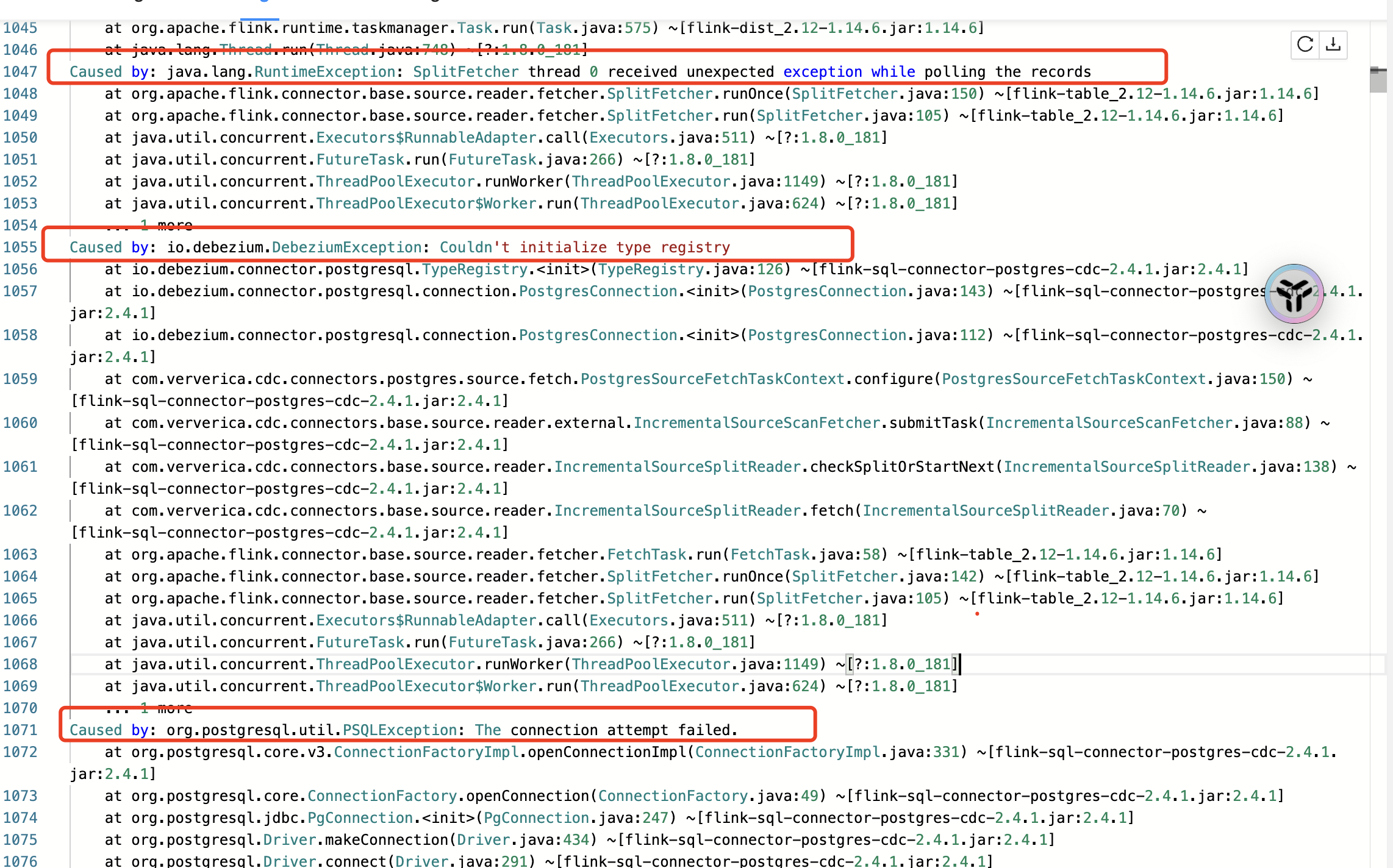

Flink CDC2.4.0的版本,pg数据库,运行一段时间,重启然后就报这个错误?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题描述,Flink CDC 2.4.0版本在PostgreSQL(pg)数据库运行一段时间后重启报错,以下是可能的原因分析及解决方案:

Flink CDC 2.4.0版本不支持同步PostgreSQL备库的数据,且PostgreSQL本身也不支持从备库读取增量数据。因此,如果您的Flink CDC作业连接的是PostgreSQL的备库,可能会导致以下问题: - 增量数据读取失败:PostgreSQL备库无法提供完整的增量数据流(如WAL日志),导致CDC任务在重启时无法正确恢复。 - Binlog位点丢失或过期:如果主库的WAL日志被清理,或者备库未同步到最新的增量数据,Flink CDC在重启时会因无法找到正确的消费位点而报错。

此外,Flink CDC作业在重启时,默认会尝试从上次停止的位置恢复消费。如果所需的Binlog或WAL日志已被清理,也会导致报错。

wal_keep_segments = 128 -- 保留的WAL段数

max_wal_size = 1GB -- 单个WAL文件的最大大小

或者使用pg_replication_slots来确保WAL日志不会被过早清理:

SELECT * FROM pg_create_logical_replication_slot('flink_slot', 'pgoutput');

注意:逻辑复制槽会占用磁盘空间,请定期监控并清理无用的复制槽。

scan.startup.mode为specific-offset,并指定具体的WAL位点。scan.startup.mode为latest-offset。'connector' = 'postgres-cdc',

'hostname' = 'your-postgres-host',

'port' = '5432',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'schema-name' = 'public',

'table-name' = 'your-table',

'scan.startup.mode' = 'latest-offset'

Task did not exit gracefully within 180 + seconds,可以尝试调整task.cancellation.timeout参数,避免Task因超时被强制终止。

task.cancellation.timeout: 0

重要:该参数仅用于调试,请勿在生产环境中长期使用。

通过以上步骤,您可以有效排查并解决Flink CDC 2.4.0版本在PostgreSQL数据库运行一段时间后重启报错的问题。如果问题仍未解决,请提供更多具体的报错信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。