FlinkCDC里Mysql 视图有没有遇到多个source,一个sink的时候,sink会少数据?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

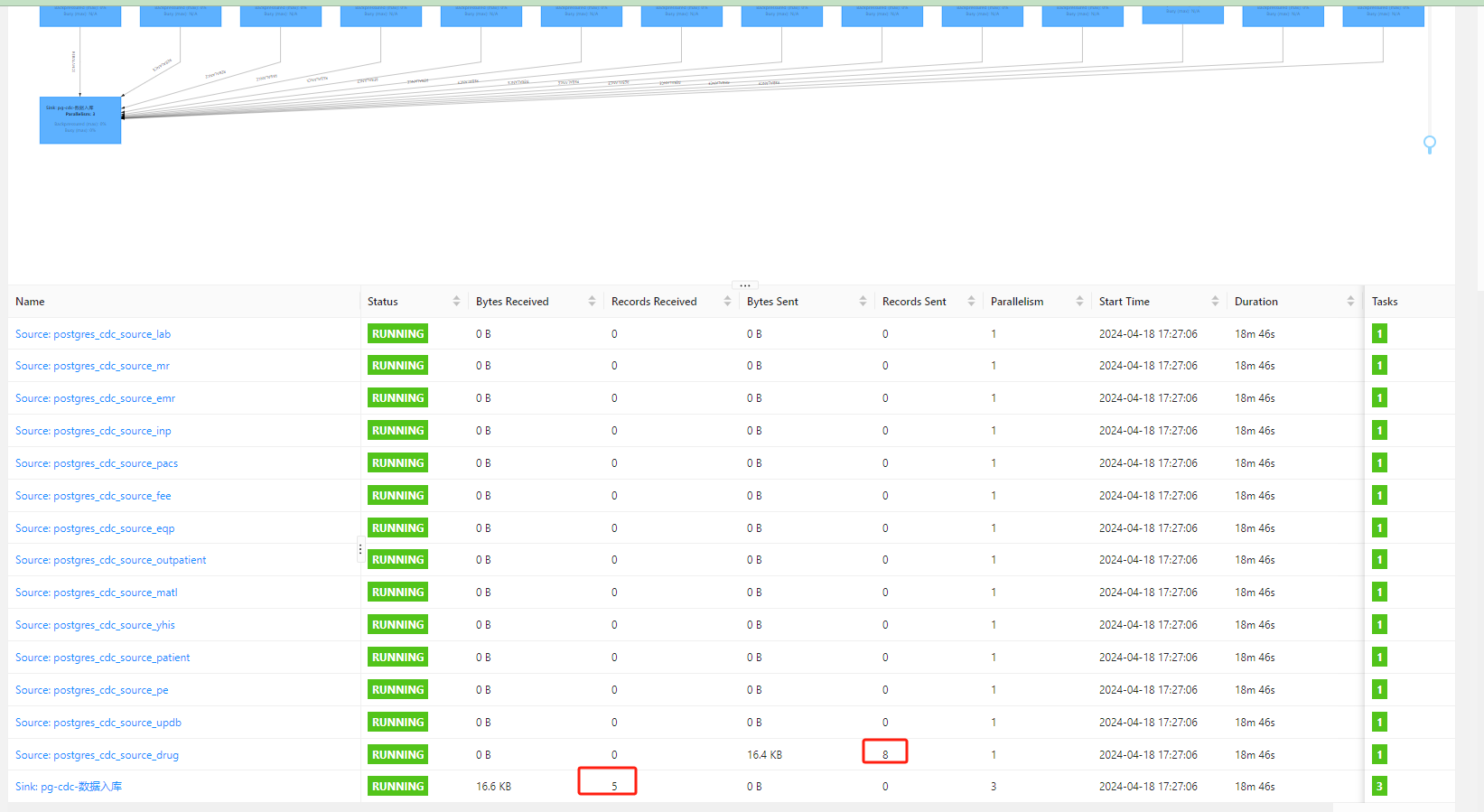

在使用 Flink CDC 读取 MySQL 数据时,如果遇到多个 Source 表(例如基于 MySQL 视图)写入一个 Sink 的场景,可能会出现 Sink 数据丢失的情况。以下是可能的原因分析及解决方案:

MySQL 视图本质上是一个虚拟表,其数据是基于底层表动态计算生成的。如果视图依赖的底层表发生了变更(如删除、更新等操作),而这些变更未被正确捕获或同步到视图中,可能导致数据不一致。

当多个 Source 表(包括视图)写入同一个 Sink 时,Flink 的 DML 语句需要明确指定如何合并数据。如果未正确处理多个 Source 的数据流(如未对齐字段、未处理重复数据等),可能导致部分数据被覆盖或丢失。

在增量阶段,Flink CDC 通过解析 Binlog 获取变更数据。如果下游 Sink 出现反压(如写入速度较慢),可能导致上游 Source 数据积压甚至丢失。

INSERT INTO sink_table

SELECT * FROM source1

UNION ALL

SELECT * FROM source2;

SET 'table.optimizer.source-merge.enabled' = 'true';

pipeline.operator-chaining 设置为 false,以减少序列化开销[4]</>。op_type 虚拟列进行标记[6]</>。例如:

CREATE TABLE mysql_source (

id BIGINT,

name STRING,

op_type STRING METADATA FROM 'op_type' VIRTUAL

) WITH (

'connector' = 'mysql-cdc',

...

);

SET 'sql-gateway.exec-plan.enabled' = 'false'[4]</>。实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。