Flink CDC这个打包为什么老是提示com/ververica/cdc/debezium/DebeziumDeserializationSchema找不到?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,如果出现com/ververica/cdc/debezium/DebeziumDeserializationSchema类找不到的错误,通常是由于以下原因之一导致的:

以下是针对该问题的详细解决方案。

确保在项目的pom.xml文件中正确引入了Flink CDC连接器的依赖。例如,对于MySQL CDC连接器,需要添加如下依赖:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>${flink-cdc.version}</version>

</dependency>

其中,${flink-cdc.version}需要根据实际使用的Flink CDC版本进行替换。例如,如果使用的是Flink CDC 2.4.2,则应设置为:

<version>2.4.2</version>

同时,确保Flink核心依赖的版本与CDC连接器版本兼容。例如,Flink 1.17.1与Flink CDC 2.4.2是兼容的。

Flink CDC连接器的版本需要与Flink版本保持一致。如果版本不匹配,可能会导致类加载失败。例如:

如果不确定版本兼容性,可以参考官方文档或Maven仓库中的说明。

在本地调试时,需要确保所有依赖都已正确加载。可以通过以下两种方式解决:

pipeline.classpaths配置依赖路径在本地运行Flink作业时,可以通过pipeline.classpaths参数指定依赖路径。例如:

Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/flink-connector-mysql-cdc-2.4.2.jar");

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

确保路径指向正确的Flink CDC连接器JAR文件。

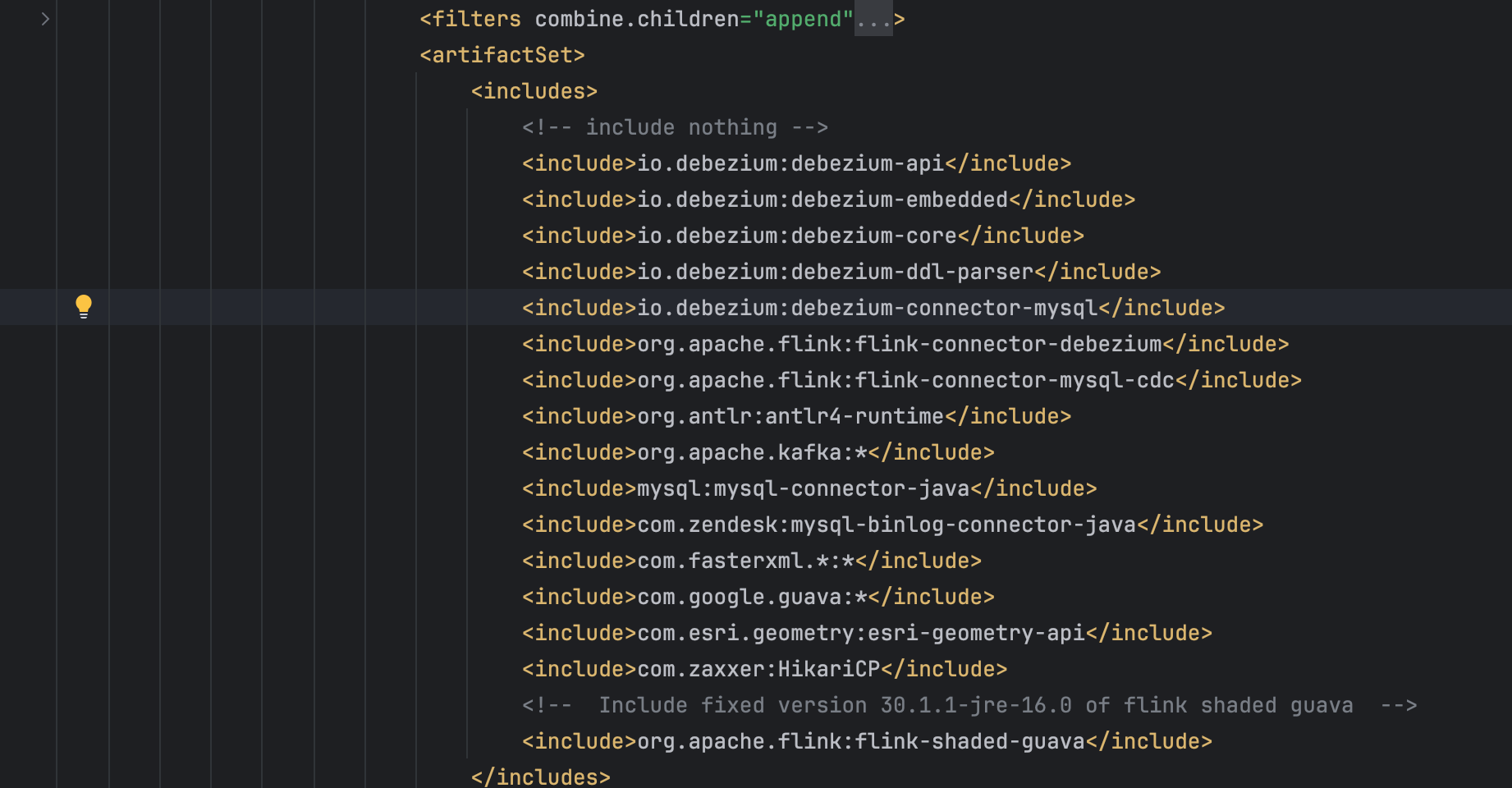

如果需要将作业提交到集群运行,建议使用FAT JAR打包方式,将所有依赖打包到一个JAR文件中。可以通过Maven Shade插件实现:

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>3.2.4</version>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<filters>

<filter>

<artifact>*:*</artifact>

<excludes>

<exclude>META-INF/*.SF</exclude>

<exclude>META-INF/*.DSA</exclude>

<exclude>META-INF/*.RSA</exclude>

</excludes>

</filter>

</filters>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

执行mvn clean package后,生成的JAR文件将包含所有依赖。

如果使用SNAPSHOT版本(如flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),需要确保Maven仓库中存在对应的依赖。SNAPSHOT版本通常不在Maven中央仓库中,而是存储在开发分支的仓库中。如果无法下载,可以尝试以下方法:

flink-sql-connector-mysql-cdc-2.1.0.jar),可以直接从Maven中央仓库获取。如果项目中存在多个版本的Flink CDC连接器或其他相关依赖,可能会导致类路径冲突。可以通过以下方式排查:

mvn dependency:tree命令查看依赖树,检查是否存在重复或冲突的依赖。<exclusions>排除不必要的依赖。例如:<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>2.4.2</version>

<exclusions>

<exclusion>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

</exclusion>

</exclusions>

</dependency>

通过以上步骤,您可以解决com/ververica/cdc/debezium/DebeziumDeserializationSchema类找不到的问题。关键点包括:

pom.xml中包含正确的Flink CDC连接器依赖。pipeline.classpaths或FAT JAR方式加载依赖。如果问题仍未解决,请提供更多上下文信息(如完整的错误日志、pom.xml文件内容等),以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。