Flink这个错,如何定位到底是那个文件的问题呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您给出的错误信息是“ERROR org.apache.hadoop.conf.Configuration”,这通常表示Hadoop配置文件存在问题。要定位具体哪个文件的问题,您可以按照以下步骤进行:

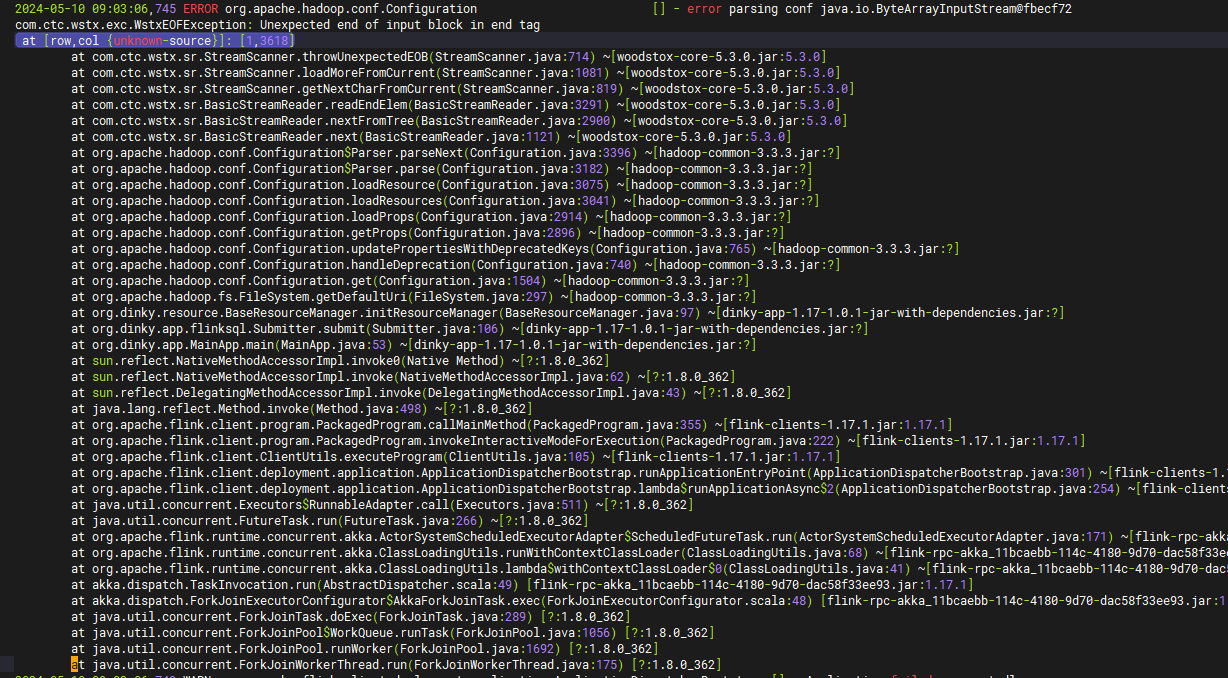

根据您提供的错误信息这似乎是一个XML解析错误。它是在尝试加载配置时发生的,因为遇到了意外的结束输入块(Unexpected end of input block)。为了定位问题的具体原因您可以按照以下步骤进行:

看你的报错,你异常发生在 ConfigurationSParser.parse(Configuration.java:3396)。这表明是 Configuration 类在解析过程中遇到了问题。

错误日志中的调用栈(stack trace)显示了异常发生时的函数调用顺序。从调用栈中,你可以找到触发异常的代码行和方法

然后审查一下你的代码嘞

错误信息 [row,col{unknow-source}]:[1,3681] 指出在文档的第一行、第 3681 个字符处缺少一个结束标签。这意味着解析器期望在那里找到一个与开始标签相对应的结束标签。

为了帮助您解决这个问题,我们需要查看实际的代码片段。不过,我可以给出一些通用的指导:

检查 XML/HTML 文档:

确保所有的 都有一个对应的 。

确认没有遗漏的开始或结束标签。

如果使用的是自闭合标签,如 或

,请确保它们是正确的格式。

使用工具验证:

使用在线的 XML/HTML 验证工具来检查文档是否正确格式化。

如果可能,使用 IDE 或文本编辑器的 XML/HTML 插件,这些插件通常会高亮显示未匹配的标签。

手动定位错误:

打开文档并滚动到第 3681 个字符的位置。

查看该位置周围的标签结构。

确认是否有缺失的标签或不匹配的标签。

根据报错信息建议检查如下:

所有的开始标签(start tags)都有对应的结束标签(end tags)。

[row,col{unknow-source}]:[1,3681],这表示问题发生在文档的第1行,第3681个字符。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。