请问各位大佬,我如果使用这种方式在 Docker 以 App mode 运行 Flink Task,它不需要启动 Task Manager 吗?而且是每次添加一个Task都需要专门添加一个network吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Docker 中以 App mode 运行 Flink 任务,确实不需要启动 TaskManager。App mode 是一个轻量级的 Docker 运行模式,它允许你直接运行应用程序,而不需要创建和管理一个完整的 Docker 容器网络。

当你在 Docker 中以 App mode 运行 Flink 任务时,Flink 会将任务直接打包到 Docker 镜像中,然后通过 Docker 的 App mode 运行这个镜像。这种方式不需要启动 TaskManager,因为所有的任务都包含在同一个 Docker 容器中。

至于网络配置,通常情况下,你不需要为每个 Task 都添加一个网络。在 App mode 下,Flink 会将任务打包到同一个镜像中,并且这个镜像会使用默认的网络设置。如果你需要与其他容器或外部网络通信,你可以通过 Docker 的网络配置选项来设置。

例如,你可以使用 Docker 的 --network 选项来指定容器连接到哪个网络,或者使用 -p 或 -P 选项来暴露端口,以便从外部访问容器内的服务。

总的来说,使用 Docker 的 App mode 运行 Flink 任务可以简化部署和运维流程,但是它也有其局限性,例如,你可能无法利用 Docker 的多容器网络功能来创建复杂的应用程序拓扑。

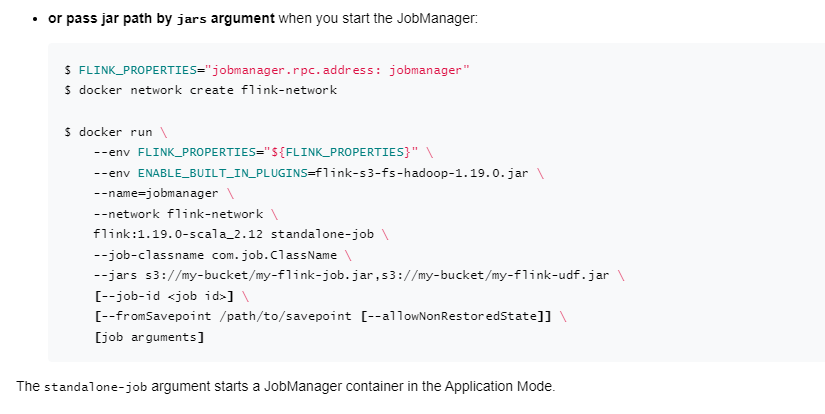

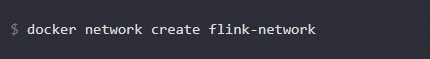

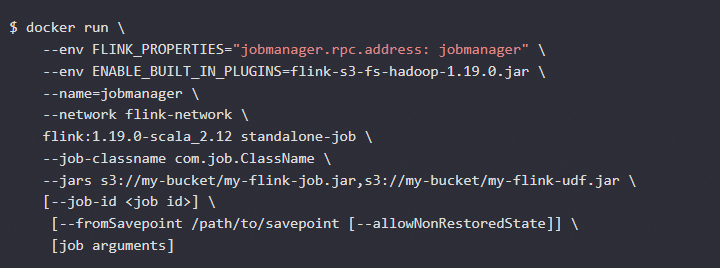

在Docker中以App mode运行Flink任务时,JobManager容器会自动启动TaskManager进程。你无需手动启动TaskManager。关于网络设置,docker network create flink-network 命令创建了一个名为flink-network的Docker网络。这个网络用于让JobManager和TaskManager之间进行通信。如果你有多个Flink任务需要运行在同一台机器上,并且它们共享相同的配置(例如Hadoop、HDFS等),那么你可以复用同一个Docker网络。这样可以避免每个任务都创建一个新的网络,从而节省资源。

在Docker中以App mode运行Flink任务的基本步骤:

在Docker中以App Mode运行Apache Flink任务时,通常是指将Flink作为应用程序的一部分直接运行在容器内,而不是作为一个独立的服务(如Session Cluster模式)。在这种模式下,确实不需要单独启动Task Manager,因为Task Manager的实例是在提交Flink作业时根据作业的需求动态分配和启动的。Flink的JobManager会负责协调这些资源。

在Docker中以App Mode运行Flink任务不需要单独启动Task Manager,而网络配置则依据实际的通信需求和隔离要求来灵活设定,并非每次添加Task都需要新网络

在App mode 下,Flink作业会作为一个单一的应用程序在单个容器中运行,整个Flink集群(包括JobManager和必要的TaskManagers)都在这个容器内部被管理。

不需要为每次添加一个Task就专门添加一个网络。在Docker中,可以定义一个网络,并在该网络中运行多个容器。这些容器可以相互通信,因为它们共享同一个网络命名空间。

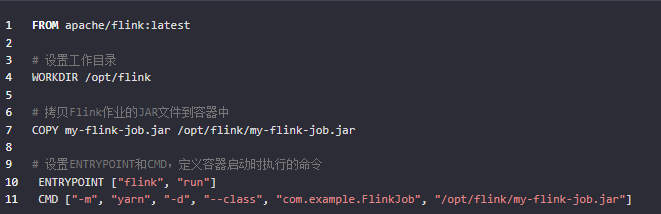

在Docker中以App模式运行Flink任务意味着你直接在Docker容器内运行Flink作业,而不通过Flink集群的JobManager提交。在这种模式下,Flink作业的启动是由Docker容器内的脚本或命令行直接触发的,通常是在容器启动时通过ENTRYPOINT和CMD指令定义的。

当你在Dockerfile中定义了ENTRYPOINT和CMD,或者在运行Docker容器时指定了命令行参数,Flink任务就会随着容器的启动而自动开始执行。例如,你的Dockerfile可能看起来像这样:

当你使用docker run命令启动基于此Dockerfile构建的镜像时,Flink任务将自动开始执行,无需额外的手动启动操作。

然而,值得注意的是,以App模式运行Flink作业可能需要一些额外的考虑:

资源管理:在App模式下,你需要自己管理资源,例如为容器分配足够的CPU和内存。

故障恢复:Flink的高可用性和故障恢复机制可能不如在Flink集群模式下那样容易配置。

监控和管理:直接在容器中运行Flink作业可能需要使用不同的工具和技术来进行监控和管理。

在Docker中以App模式运行Flink任务时,确保你的Docker容器配置正确,并且Flink作业的启动命令能够正确执行。如果需要动态配置或传递参数,可以通过环境变量或Docker的--env标志来实现。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。