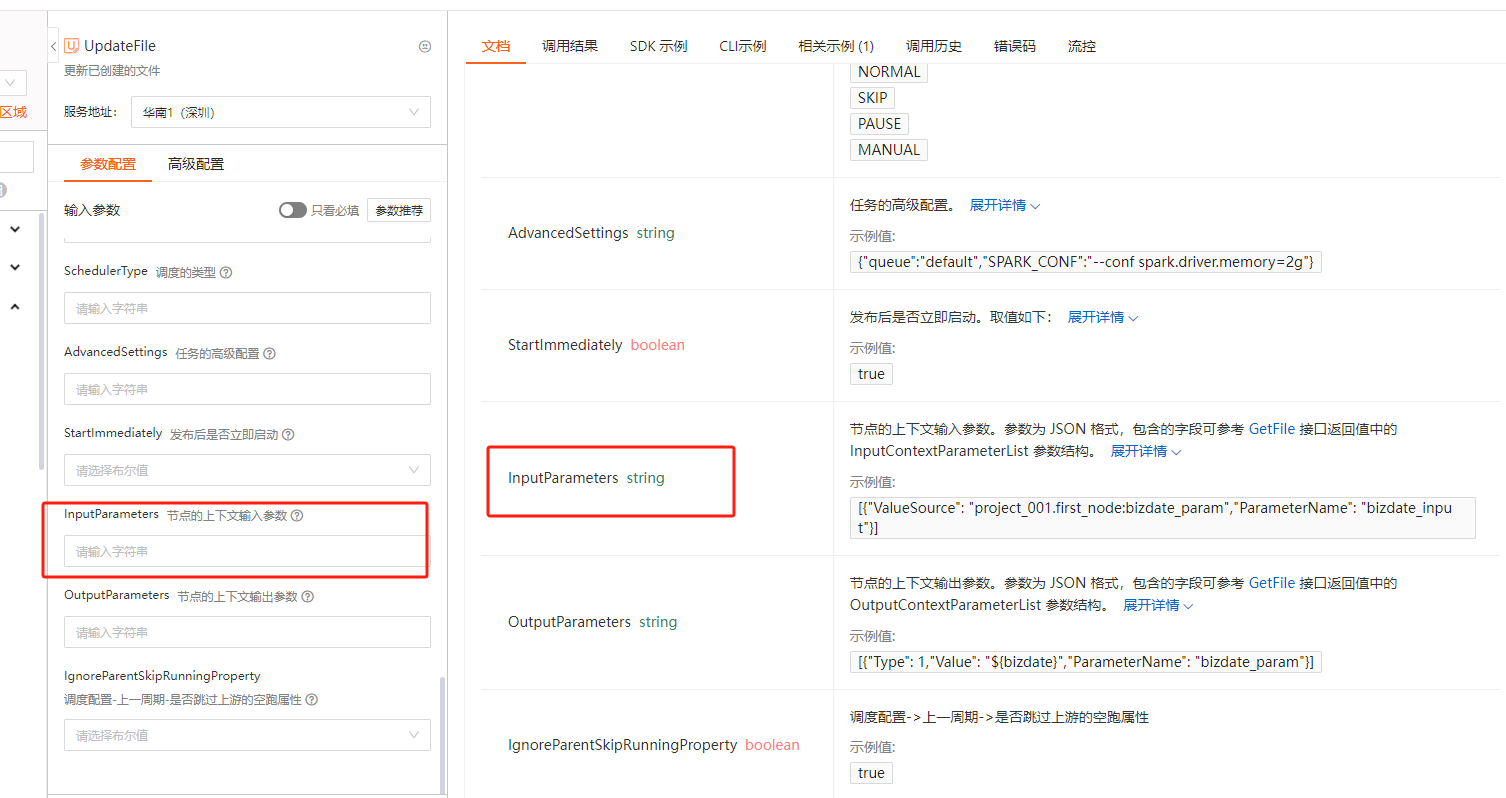

DataWorksopenAPI --> UpdateFile --> 传参的这个 InputParameters 参数是不是有问题当前我发现1、通过【Api】去添加的输入参数,界面显示是已经添加上了,但是实际过程中【无法】获取到上游输出的数值2、通过【手动】去添加的输入参数,界面显示是已经添加上了,但是实际过程中【可以】获取到上游输出的数值?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您在使用 DataWorks 的 UpdateFile 接口时,发现通过 API 添加的 InputParameters 参数虽然在界面上显示已成功添加,但在实际运行过程中无法获取到上游输出的数值。而通过手动方式添加的输入参数则可以正常获取上游输出的数值。这表明可能存在以下问题:

InputParameters 参数可能未完全符合 DataWorks 的内部逻辑要求。InputParameters 参数的格式根据知识库中的描述,InputParameters 参数是一个 JSON 格式的字符串,包含节点上下文输入参数的详细信息。其结构如下:

[

{

"ValueSource": "project_001.first_node:bizdate_param",

"ParameterName": "bizdate_input"

}

]

ValueSource:表示取值来源,通常为上游节点的输出参数,格式为 项目名.节点名:输出参数名。ParameterName:表示当前节点的输入参数名称,在代码中可以通过 ${ParameterName} 引用。请确保: - ValueSource 的格式正确,且上游节点确实存在并输出了对应的参数。 - ParameterName 唯一且符合命名规范。

通过 API 添加的 InputParameters 参数可能未正确绑定到上游节点的输出。建议检查以下内容: - 上游节点的输出名称:确保 ValueSource 中的 输出参数名 与上游节点的实际输出名称一致。 - 项目和节点名称:确保 ValueSource 中的 项目名 和 节点名 与上游节点的定义一致。

如果上游节点的输出名称或项目名称发生变化,可能导致绑定失败。

AutoParsing 参数AutoParsing 参数控制文件是否开启自动解析功能。如果该参数设置为 false,可能导致 DataWorks 无法自动解析代码中的上下文依赖关系。建议将 AutoParsing 设置为 true,以确保代码中的上下文参数能够被正确解析。

手动添加参数时,DataWorks 界面可能会自动补充一些隐式的配置(如默认的上下文绑定规则)。建议通过以下步骤对比两种方式的差异: 1. 使用 GetFile 接口获取通过手动添加参数的文件详情,查看 InputParameters 的实际值。 2. 将手动添加的参数值与通过 API 添加的参数值进行对比,找出可能缺失或格式不一致的部分。

InputParameters 参数的生效依赖于调度配置中的“同周期”依赖设置。请确保: - 文件的调度依赖配置中选择了“同周期”。 - 上游节点的输出名称与 InputParameters 中的 ValueSource 一致。

如果调度依赖配置不正确,可能导致 InputParameters 无法正确获取上游输出值。

以下是一个完整的 UpdateFile 请求示例,包含 InputParameters 参数的正确配置:

{

"FileId": 100000001,

"InputParameters": "[{\"ValueSource\": \"project_001.first_node:bizdate_param\",\"ParameterName\": \"bizdate_input\"}]",

"AutoParsing": true,

"SchedulerType": "NORMAL"

}

FileId:文件的唯一标识符。InputParameters:JSON 格式的字符串,包含上下文输入参数。AutoParsing:设置为 true,确保代码中的上下文依赖能够被正确解析。SchedulerType:调度类型,设置为 NORMAL。InputParameters 参数的格式正确,特别是 ValueSource 和 ParameterName 的值。ValueSource 一致。AutoParsing 参数设置为 true,以确保上下文依赖能够被正确解析。GetFile 接口获取手动添加参数的文件详情,对比 API 添加的参数值,找出可能的差异。如果以上步骤仍无法解决问题,建议联系阿里云技术支持,提供具体的 API 请求参数和错误日志,以便进一步排查问题。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。