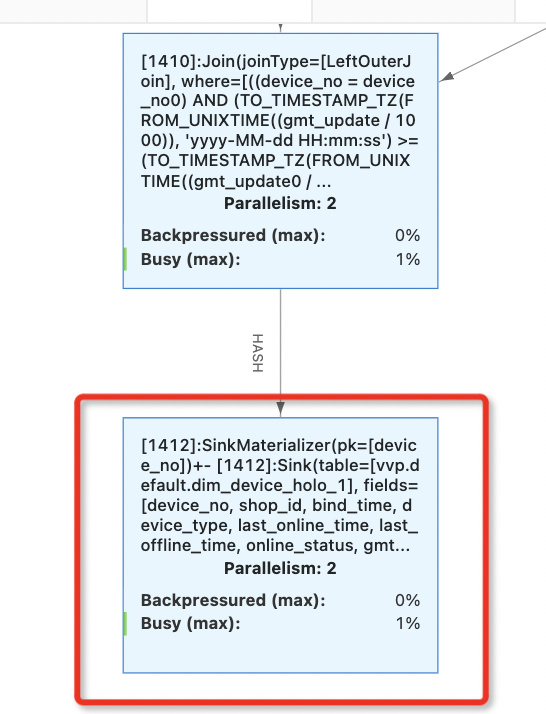

flink cdc抽取hologres 2张表采用的增量模式,2个表的增量数据每天都在8000w左右,采用的会话窗口进行join设置了上下限30s,按insertorupdate模式写入的表。现在的问题是刚开始运行的时候sink端busy会随着时间增大,最后产生背压,需要无状态重启一下才能恢复

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Apache Flink 是一个分布式流处理框架,它设计用于处理大规模的数据流。在 Flink 中,随着时间的推移,作业可能会出现性能下降或者资源使用率增加(例如,CPU busy 增加)的情况。这种现象可能由多种因素引起,以下是一些可能导致 Flink 作业随着时间增加 busy 的原因:

资源不足:如果 Flink 作业的资源(如 CPU、内存)不足以处理当前的数据量,那么作业的性能可能会下降。随着数据量的增加,资源需求也会增加,如果资源没有相应地增加,就会导致资源使用率上升。

反压(Backpressure):在 Flink 中,如果生产者(source)生成数据的速度快于消费者(sink)处理数据的速度,就会产生反压。反压会导致数据在系统中积压,增加资源的使用率。

状态管理:Flink 的状态管理可能会随着时间的推移而增加资源使用。例如,如果作业使用了大量的窗口操作或者状态后端存储,那么随着时间的推移,状态可能会变得越来越大,从而增加资源使用。

垃圾回收(GC):在 Java 虚拟机(JVM)中,垃圾回收是一个重要的过程。如果垃圾回收过于频繁或者耗时过长,可能会导致 CPU 使用率增加。

网络和磁盘 I/O:如果作业需要频繁地读写磁盘或者进行网络通信,那么 I/O 操作可能会成为瓶颈,导致资源使用率增加。

配置不当:Flink 的配置参数设置不当也可能导致性能问题。例如,如果 checkpoint 的间隔设置得太短,那么频繁的 checkpoint 操作可能会消耗大量的资源。

数据倾斜:如果数据在处理过程中出现倾斜,即某些任务处理的数据量远大于其他任务,那么这些任务可能会成为瓶颈,导致整体性能下降。

代码优化:Flink 作业的代码实现也会影响性能。例如,不合理的数据分区策略、不高效的算子使用等都可能导致资源使用率增加。

为了诊断和解决这些问题,你可以采取以下措施:

监控和分析:使用 Flink 的监控工具(如 Flink Dashboard、Prometheus、Grafana 等)来监控作业的性能指标,如 CPU 使用率、内存使用率、反压情况等。

调整资源:根据监控数据调整作业的资源分配,确保有足够的资源来处理数据。

优化代码和配置:优化 Flink 作业的代码逻辑和配置参数,例如调整 checkpoint 间隔、优化状态后端存储、改进数据分区策略等。

垃圾回收调优:调整 JVM 的垃圾回收参数,减少垃圾回收的频率和影响。

负载均衡:确保数据在任务间均匀分配,避免数据倾斜。

通过这些方法,你可以有效地诊断和解决 Flink 作业随着时间增加 busy 的问题,从而保持作业的稳定和高效运行。

您的Flink CDC与Hologres的集成问题,可能是由于数据量大和会话窗口设置导致的处理延迟。由于您设置了30s的会话窗口,随着数据的积累,处理压力增加,最终造成背压。建议优化如下:

调整并行度以增加处理能力。

检查网络带宽和Hologres的写入压力,确保资源充足。

考虑增加会话窗口时间,减少窗口触发的频率。

调整Flink的水印策略,避免过早触发迟到数据。

确保Flink配置适当,如buffer大小和重试策略。

Apache Flink是一个用于流处理和批处理的分布式计算框架,它设计用于处理大规模数据集。随着时间增加,Flink作业的CPU繁忙度(busy)可能会增加,这可能是由于以下几个原因:

在 Apache Flink 中,busy 状态可能会随着时间增加,这通常是因为作业的资源利用率较高,或者作业正在执行一些计算密集型的任务。以下是一些可能导致 busy 状态增加的原因:

数据处理量增加:如果作业处理的数据量随着时间的推移而增加,那么作业的 busy 状态可能会随之增加。

资源利用率:作业的资源利用率可能会随着时间而变化。如果作业需要更多的 CPU、内存或网络资源,那么 busy 状态可能会增加。

任务调度:Flink 的任务调度机制可能会导致某些 TaskManager 比其他 TaskManager 更忙。例如,如果某个 TaskManager 上的任务需要更多的计算资源,那么这个 TaskManager 的 busy 状态可能会增加。

作业复杂性:如果作业包含复杂的计算逻辑或数据转换,那么作业的 busy 状态可能会随着时间增加。

数据倾斜:在处理大数据集时,可能会出现数据倾斜,导致某些 Task 处理的数据量远大于其他 Task,从而使得这些 Task 的 busy 状态增加。

状态管理:如果作业使用状态管理(如 checkpointing 或 savepoints),那么状态的读写操作可能会增加 busy 状态。

资源管理器限制:如果资源管理器(如 YARN 或 Kubernetes)的资源分配不足以满足作业的需求,那么作业的 busy 状态可能会增加。

从您提供的信息来看,您的 Flink 应用程序在处理大量 CDC 数据时遇到了背压问题,并且随着应用程序运行时间的增长,Sink 端的忙碌程度也在增加。

资源限制:检查您的集群是否具有足够的计算和内存资源来处理这些大量的数据。如果资源不足,可以考虑增加更多的节点或者调整每个任务管理器的并行度。

网络带宽:确保网络带宽足够支持数据传输。如果网络带宽有限制,可能会导致背压。

Join 操作:由于您使用的是会话窗口进行 Join 操作,并设置了一个上下限为 30 秒的时间范围。这可能导致某些情况下 Join 过程中累积的数据量过大,从而影响性能。您可以尝试调整窗口大小或优化 Join 条件以减少数据积压。

SinkMaterializer 设计:检查 SinkMaterializer 的实现,确保它能够有效地处理大量数据。例如,如果 Hologres 写入操作不是线性的,那么您可能需要重新设计写入策略以提高吞吐量。

并行度:检查您的并行度设置是否合理。如果并行度过低,会导致数据处理速度慢,进而引发背压。适当增加并行度有助于提高处理能力。

您可以尝试以下措施:

调整并行度:根据集群资源情况适当增加并行度。

分析 Join 操作:检查 Join 条件和窗口设置,看是否有优化的空间。

监控资源利用率:监控集群资源使用情况,确保没有达到瓶颈。

调整网络配置:确保网络带宽充足,避免成为瓶颈。

优化 SinkMaterializer:检查 SinkMaterializer 实现,看看是否存在可优化的地方。

看看是不是维表查询延迟过高

Flink作业中是否存在维表Join操作,特别是使用了Hologres作为维表源的情况

。维表查询的延迟高可能导致Join节点反压,影响整个作业的吞吐量,

确认是否已启用异步维表查询模式('async' = 'true'),这能显著提升查询性能,尽管牺牲了请求的绝对顺序保证

在Apache Flink中,“busy”通常指的是任务执行器(TaskManagers)或线程在处理数据流时的繁忙程度。随着时间的推移,Flink中的“busy”程度增加可能是由以下几种常见原因造成的:

数据量增加:

随着时间的推移,输入数据流的速度或总量可能逐渐增加,这会使得Flink任务处理的数据量增加,从而导致更高的CPU利用率和更大的“busy”程度。

背压(Backpressure):

当下游算子的处理速度慢于上游算子时,就会产生背压。背压会导致上游算子的缓存队列填满,从而迫使它们放慢处理速度,这在整个数据流处理管道中都会产生连锁反应,最终导致整个任务的“busy”程度增加。

资源竞争:

在共享资源的环境中,如多租户Kubernetes集群,Flink任务可能与其他任务竞争CPU、内存等资源。随着时间的推移,如果资源竞争加剧,Flink任务的“busy”程度也会增加。

状态管理:

Flink在处理有状态的流应用时,需要维护状态,随着时间的推移,状态的大小可能会增长,这会影响状态后端的性能,进而影响任务的处理速度。

Checkpoint和Savepoint:

随着时间的推移,Flink的checkpoint和savepoint操作可能会占用更多的资源,尤其是在状态较大时,这会导致任务的“busy”程度增加。

算法复杂性:

如果Flink作业中包含的算法随数据量的增长而复杂度增加,那么处理相同数量的数据将需要更多的时间和资源,从而增加“busy”程度。

软件或硬件问题:

软件bug、硬件故障或性能下降(如磁盘I/O性能下降)也可能随着时间的推移导致“busy”程度的增加。

配置不当:

Flink的配置参数,如并行度、buffer大小、内存分配等,如果设置不当,也可能导致效率低下和“busy”程度的增加。

为了缓解“busy”程度的增加,你可以采取以下措施:

如果“busy”程度的增加导致了严重的性能问题,建议深入分析具体原因,并针对性地进行优化。

在 Apache Flink 中,"Busy (max)" 是衡量任务繁忙程度的一个指标,它表示任务正在处理的数据量占总吞吐量的比例。随着任务执行时间的增长,如果 Busy 值逐渐增大并最终导致背压(Backpressure),这通常意味着系统中存在某些问题。比如:资源限制,网络带宽,窗口操作符优化,数据倾斜,代码逻辑,存储层性能。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。