在阿里云OpenAPI用ProxyClient连接DSW,为什么实例里面能执行python,本地连接实例后不能执行?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

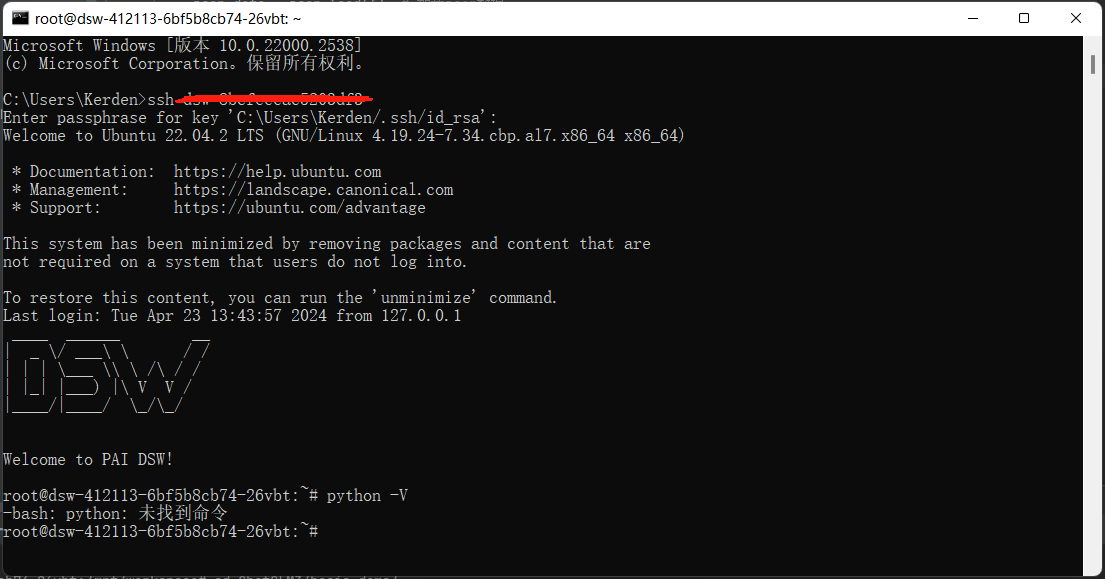

在使用阿里云OpenAPI通过ProxyClient连接DSW实例时,如果出现“实例内部可以正常执行Python代码,但本地连接后无法执行”的问题,可能与以下几个因素有关:

DSW实例内部的Python环境可能已经正确配置并加载了所需的依赖库,而本地连接后,可能未正确加载远程实例的环境变量或依赖。

- 原因分析:

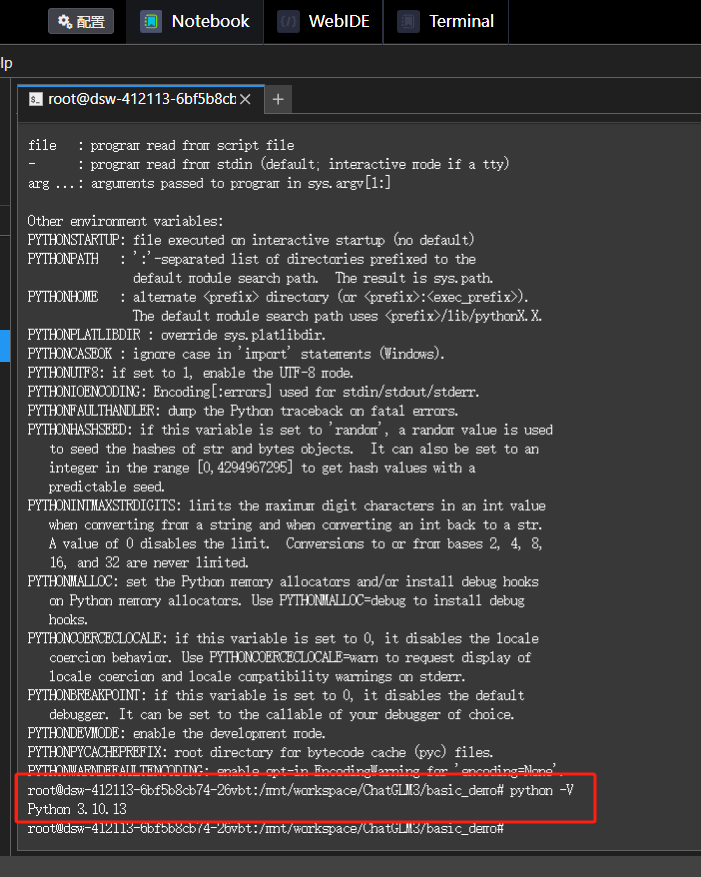

在DSW实例中运行Python代码时,系统会自动加载预配置的环境变量(如PATH、PYTHONPATH等)。然而,通过ProxyClient连接后,这些环境变量可能未被正确传递到本地SSH会话中。

- 解决方案:

- 在本地Terminal中手动加载远程实例的环境变量。例如,运行以下命令以加载Spark相关环境参数(如果涉及Spark作业): bash source /etc/profile.d/spark-env.sh - 确保本地连接的Kernel与远程实例的Python版本一致。如果版本不匹配,可能会导致模块加载失败或执行错误。

通过ProxyClient连接后,本地Notebook可能未正确选择远程DSW实例的Kernel,导致无法执行Python代码。

- 原因分析:

DSW实例支持多种Kernel(如JupyterLab、PySpark等),如果本地连接时选择了错误的Kernel,可能会导致代码无法运行。

- 解决方案:

- 在本地VSCode或其他IDE中,确保已正确配置Remote Kernel。例如,使用remote_ikernel工具添加Remote Python Kernel时,需指定正确的kernel_cmd和host信息。 - 如果新建Notebook时没有PySpark选项,可以选择Kernel > Restart Kernel以重新加载正确的Kernel配置。

通过ProxyClient连接时,可能存在权限不足或网络连通性问题,导致本地无法正确访问远程实例的资源。

- 原因分析:

ProxyClient方式需要通过阿里云AccessKey进行鉴权,并依赖PAI内部网络进行通信。如果鉴权失败或网络配置不当,可能会导致本地无法正确执行远程命令。

- 解决方案:

- 检查ProxyClient的配置文件,确保已正确填写阿里云AccessKey信息。 - 确认本地网络能够访问DSW实例的公网地址。如果公网地址无法访问,请参考VPC内网络连通性排查方法,检查NAT网关、vSwitch和路由表的配置是否正确。

远程DSW实例中可能安装了某些本地环境中缺失的依赖库,导致代码无法正常运行。

- 原因分析:

如果代码中使用了特定的第三方库(如pyspark、numpy等),而本地环境中未安装这些库,则会导致ModuleNotFoundError错误。

- 解决方案:

- 使用spark.archives配置将本地Python环境同步到远端,或者在集群每个Worker节点手动安装相关依赖。 - 在本地Terminal中运行以下命令,检查远程实例的依赖库是否完整: bash pip list

通过ProxyClient连接时,SSH配置可能未正确设置,导致本地无法完全访问远程实例的功能。

- 原因分析:

如果SSH连接未启用免密登录或未正确配置公钥认证,可能会导致部分功能受限。

- 解决方案:

- 确保已正确配置SSH免密登录。可以通过以下步骤生成密钥对并配置公钥: 1. 在本地命令行中生成RSA密钥对: bash ssh-keygen -t rsa 2. 将公钥复制到DSW实例中: bash ssh-copy-id root@<DSW实例IP> - 如果使用账号密码登录,确保已正确设置PermitRootLogin配置,并重启SSH服务。

通过ProxyClient连接DSW实例后无法执行Python代码的问题,通常与环境变量加载、Kernel配置、权限或网络连通性、依赖库缺失以及SSH连接配置等因素有关。建议按照上述步骤逐一排查并解决问题。如果问题仍未解决,可以提交工单联系技术支持团队获取进一步帮助。