"

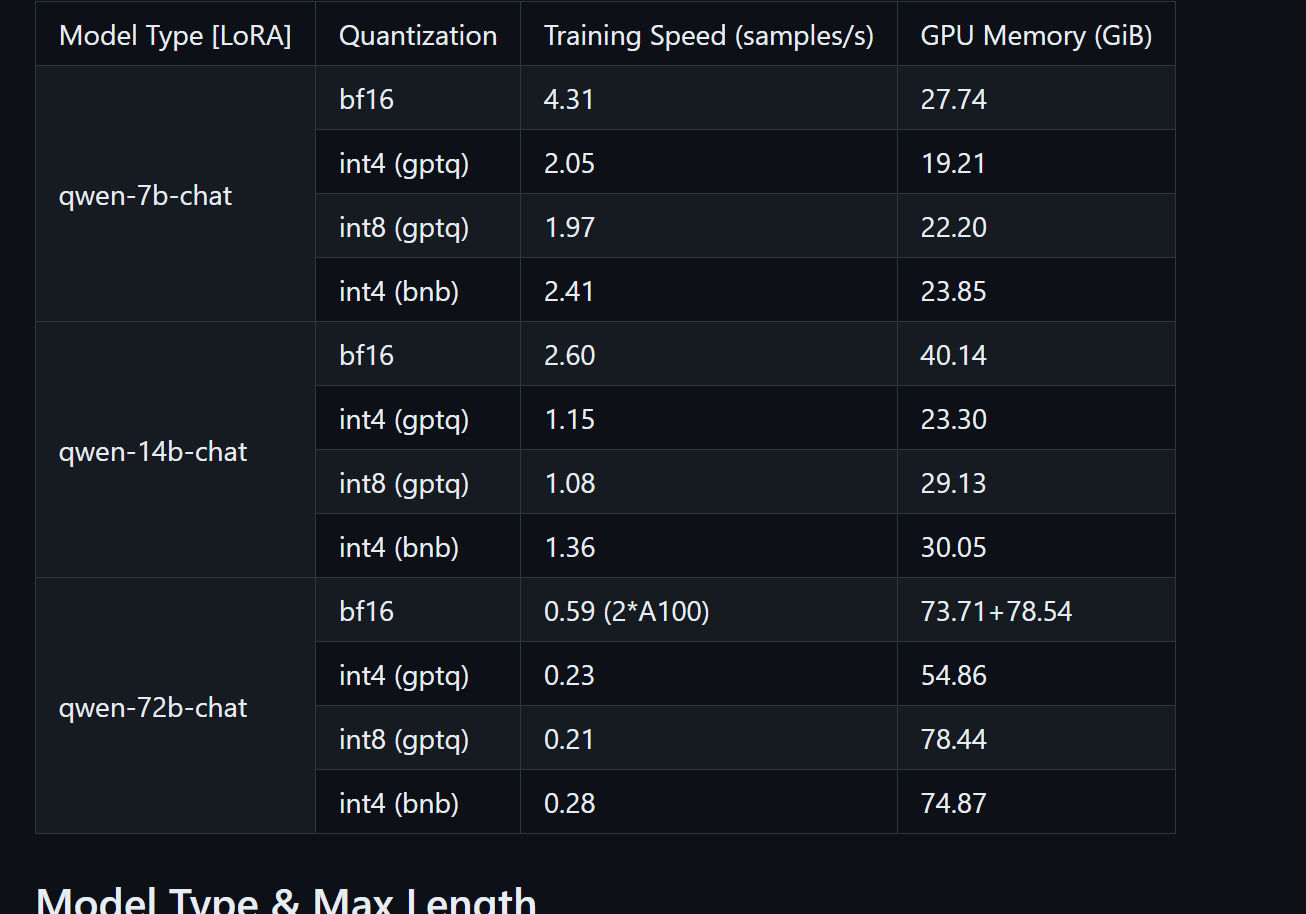

图中好像只有lora的显存,ModelScope的推理显存需求有吗?"

ModelScope(魔搭)是阿里云的模型开放平台,它提供了丰富的机器学习和深度学习模型。关于推理显存需求,这实际上取决于您在ModelScope上使用的具体模型类型、大小以及配置的推理环境。

LORA(Low-Rank Approximation)是一种用于减小模型体积、降低推理时显存需求的技术,常应用于Transformer-based的大模型中。如果某个模型在ModelScope上应用了LORA或其他类似的优化技术,那么它的显存需求相比于未优化的原始模型会有所降低。

对于ModelScope上的模型推理显存需求,通常有以下几种方式来获取或估算:

模型详情页:在ModelScope平台上,每个模型的详情页面可能会提供一些基本信息,包括但不限于推荐的硬件配置、显存需求等。这是获取模型具体需求最直接的方式。

文档与指南:ModelScope平台和相关模型往往会伴随有详细的使用文档和部署指南,其中可能包含对资源需求的描述,包括显存。

参数量估算:如果您无法直接找到显存需求信息,可以根据模型的参数量进行大致估算。一般而言,模型的参数量越大,所需的显存也越多。但请注意,这只是一个非常粗略的估算方法,实际显存占用还受到模型结构、优化技术等多种因素的影响。

测试运行:最准确的方法是在您的目标硬件环境下,使用一小部分数据对模型进行测试推理。这样可以直接观察到模型的实际显存占用情况。

如果您的项目对显存有严格限制,建议优先选择那些经过优化的轻量化模型,或者利用如LORA这样的技术来减少模型尺寸和显存占用。同时,也可以考虑使用阿里云的Elastic Inference等服务,该服务允许按需分配GPU资源,有助于更高效地管理推理成本和资源需求。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352