使用 flink cdc1.18.0 的flinksql的jdbc的方式读取不了数据,应该是哪一个包?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

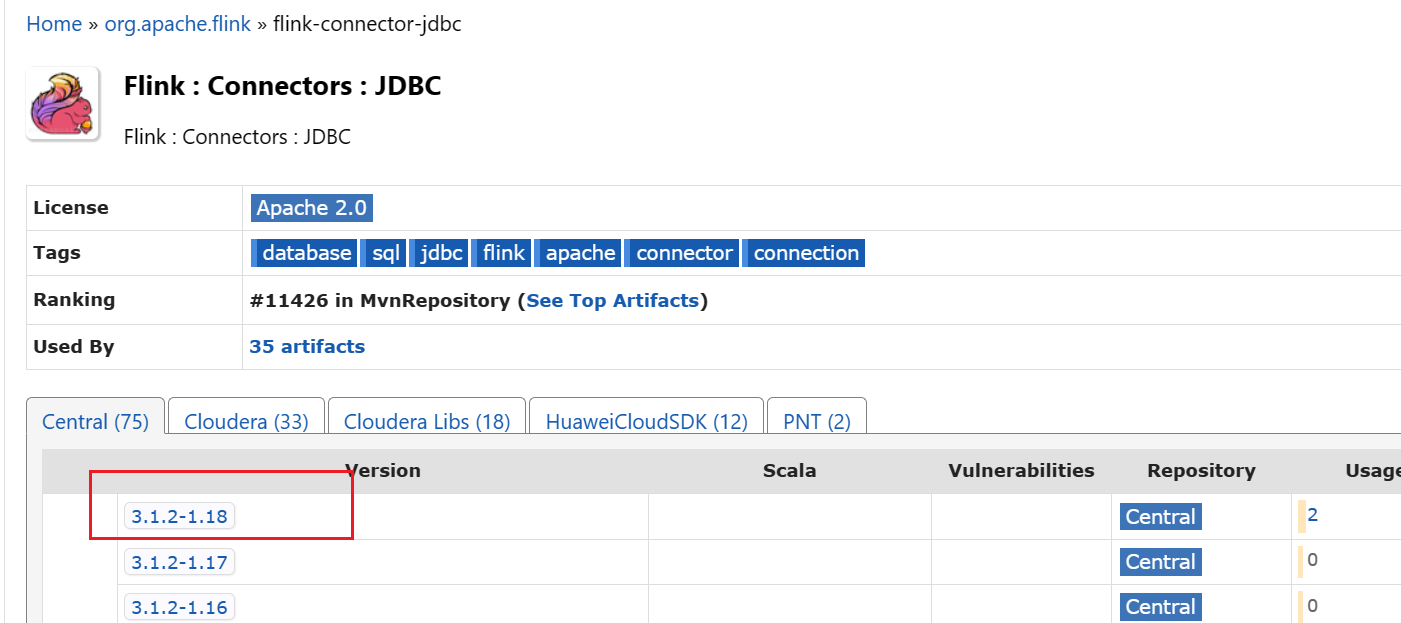

在使用 Flink CDC 1.18.0 的 Flink SQL 通过 JDBC 方式读取数据时,如果无法读取数据,可能与使用的依赖包不正确或未正确配置相关。以下是详细分析和解决方案:

Flink CDC 提供了两种主要的连接器包: - flink-sql-connector-xxx:这是一个 FAT JAR,包含了连接器代码及其所有依赖的第三方库(shade 后打包)。适用于 SQL 作业,直接放入 lib 目录即可使用。 - flink-connector-xxx:仅包含连接器代码,不包含其依赖的第三方库。适用于 DataStream API 作业,需要手动管理依赖。

对于 Flink SQL 作业,您需要使用 flink-sql-connector-xxx 包。例如: - 如果您使用的是 MySQL 数据源,则需要 flink-sql-connector-mysql-cdc-1.18.0.jar。 - 如果您使用的是 PostgreSQL 数据源,则需要 flink-sql-connector-postgres-cdc-1.18.0.jar。

重要提醒:确保下载的版本与您的 Flink CDC 版本(1.18.0)完全匹配。如果使用 SNAPSHOT 版本(如 flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),需要自行编译源码生成 JAR 文件,因为 SNAPSHOT 版本不会发布到 Maven 中央仓库。

Flink 的 JDBC 连接器本身并不包含具体的数据库驱动(Driver)。因此,在使用 JDBC 方式读取数据时,必须手动上传目标数据库的 JDBC 驱动 JAR 包作为附加依赖文件。

以下是常见数据库的 JDBC 驱动信息: | 数据库 | Group Id | Artifact Id | |--------------|-----------------------|-------------------------| | MySQL | mysql | mysql-connector-java | | PostgreSQL | org.postgresql | postgresql | | Oracle | com.oracle.database.jdbc | ojdbc8 |

操作步骤: 1. 下载对应数据库的 JDBC 驱动 JAR 文件。 2. 将 JAR 文件上传到 Flink 的 lib 目录或通过 Flink 的依赖管理工具加载。

Flink CDC 基于 Debezium 实现变更数据捕获(CDC)。因此,Debezium 的版本需要与 Flink CDC 版本兼容。您可以通过以下方式确认: 1. 查看 Flink CDC 1.18.0 的 pom.xml 文件,找到 debezium.version 字段,确定对应的 Debezium 版本。 2. 确保使用的 Debezium 版本支持目标数据库的特性(如 PostgreSQL 的 REPLICA IDENTITY FULL 配置)。

在 Flink SQL 中,使用 JDBC 源表时需要注意以下几点: - 字段类型、顺序和大小写:DDL 中定义的字段类型、顺序和大小写必须与物理表一致。 - 主键配置:如果目标表有主键,建议在 DDL 中显式定义主键,以避免数据重复或丢失。 - 网络连通性:确保 Flink 集群与目标数据库之间的网络连通,并且数据库已正确配置白名单。

示例 DDL:

CREATE TABLE source_table (

id INT,

name STRING,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'jdbc',

'url' = 'jdbc:mysql://<host>:<port>/<database>',

'table-name' = '<table>',

'username' = '<username>',

'password' = '<password>'

);

如果上述配置均正确,但仍无法读取数据,建议查看 Flink TaskManager 的日志,定位具体问题: 1. 在 Flink Web UI 中,进入作业的 运维中心 > 作业运维 页面。 2. 单击目标作业名称,进入 状态总览 页面。 3. 单击 Source 节点,查看 SubTasks 页签下的日志信息。 4. 查找最后一个 Caused by 异常信息,根据提示解决问题。

根据知识库资料,您需要确保以下几点: 1. 使用正确的 FAT JAR 包(如 flink-sql-connector-mysql-cdc-1.18.0.jar 或 flink-sql-connector-postgres-cdc-1.18.0.jar)。 2. 手动上传目标数据库的 JDBC 驱动 JAR 文件。 3. 确认 Flink CDC 和 Debezium 的版本兼容性。 4. 检查 DDL 配置是否正确,并确保网络连通性和白名单配置无误。 5. 查看 TaskManager 日志,定位并解决异常问题。

如果仍有问题,请提供具体的错误日志以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。