Flink CDC里3.0.1启动报错怎么办?就单独的flink+flink-cdc,

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

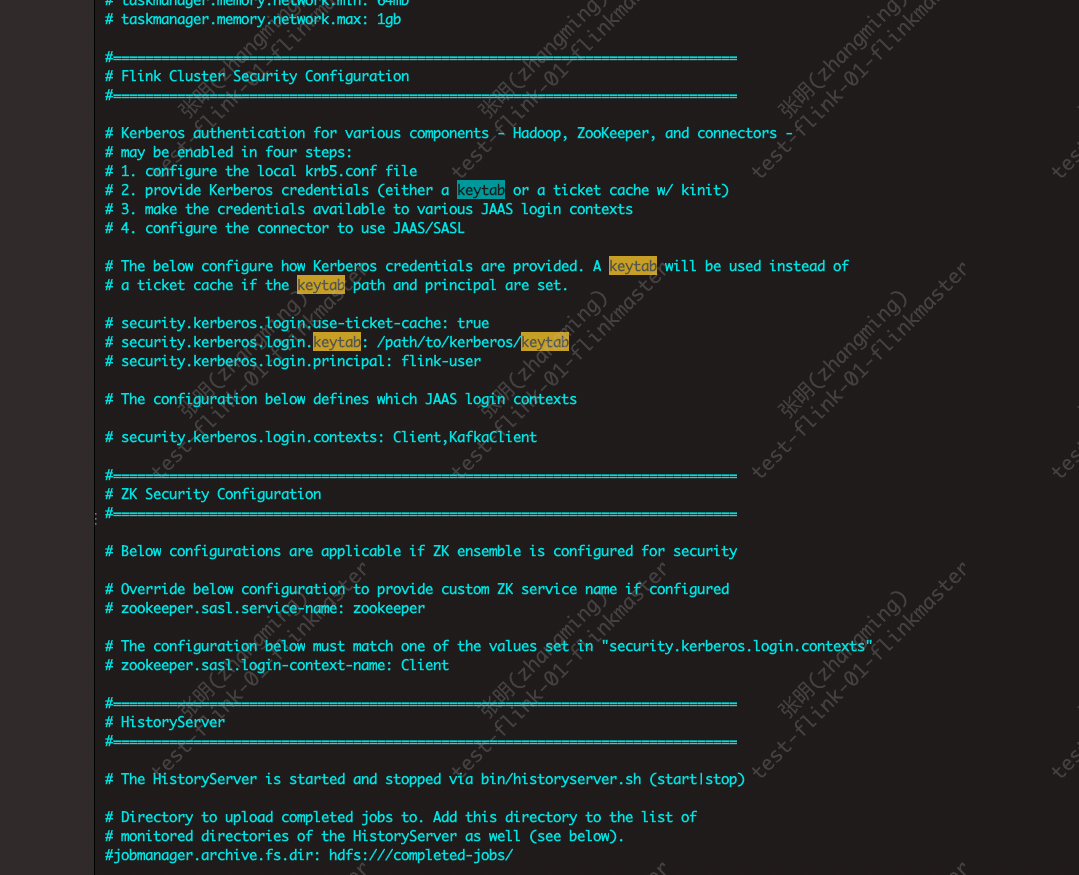

在使用Flink CDC 3.0.1版本时,如果启动报错,可能涉及多种原因。以下是针对常见问题的详细分析和解决方案:

如果在MySQL中更新了表结构,但下游表未同步变更,可能是由于以下原因: - 原因:Flink CDC捕获的是前后数据之间的Schema变化,而不是直接识别DDL语句。如果上游表仅发生DDL变更,但没有新增或修改数据,则不会触发下游表的同步。 - 解决方案: 1. 确保上游表有新增或修改的数据,以触发下游表的同步。 2. 如果需要强制同步表结构变更,请参考文档中的“表结构变更同步策略”,手动调整下游表结构。

finish split response timeout异常如果报错信息类似于Encountered change event for table xxx.xxx whose schema isn't known to this connector,可能是以下原因导致: - 原因: 1. 数据库用户权限不足,无法访问某些表的Schema。 2. 使用了debezium.snapshot.mode='never',导致从Binlog开头读取数据,而Binlog中的Schema与当前表的Schema不匹配。 3. Debezium无法解析某些特定的变更(如DEFAULT (now()))。 - 解决方案: 1. 检查数据库用户的权限,确保其拥有作业中所有数据库的相应权限。 2. 避免使用debezium.snapshot.mode='never',建议通过debezium.inconsistent.schema.handling.mode='warn'参数避免报错。 3. 查看日志中io.debezium.connector.mysql.MySqlSchema WARN的详细信息,定位具体无法解析的变更内容,并根据实际情况调整表结构或配置。

如果报错与网络连通性相关(如域名解析失败或Kafka连接超时),请检查以下内容: - 域名解析问题: 1. 如果您有自建DNS服务,确保Flink VPC能够连通该DNS,并正确配置env.java.opts参数。 2. 如果没有自建DNS,建议使用阿里云云解析PrivateZone进行域名解析。 - Kafka连接超时: - 即使网络连通,也可能因Kafka元数据获取超时导致报错。请参考文档中的Kafka网络连通性排查步骤。

compaction.delta_commits参数,更快触发压缩任务。ignoreDelete=false,虽然支持回撤更新,但性能会显著下降。建议评估是否需要启用此功能。希望以上内容能帮助您快速定位并解决Flink CDC 3.0.1启动报错的问题!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。