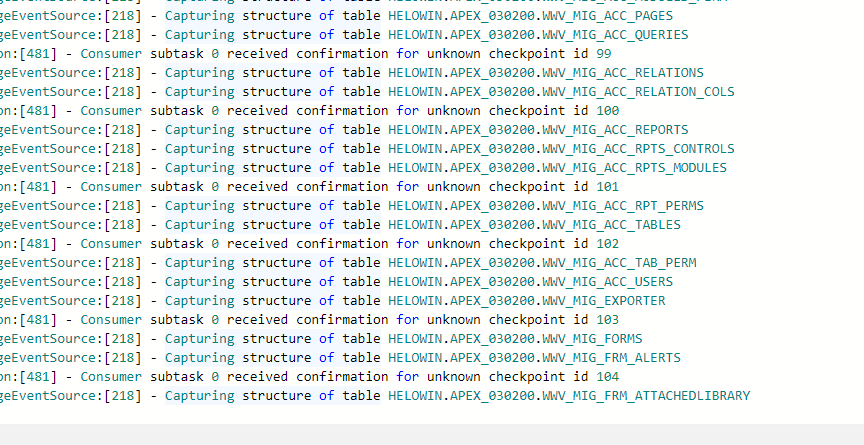

Flink CDC里Oracle cdc 这个日志要打印 很久才回同步数据,这个咋处理啊? Capturing structure of table

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC进行Oracle数据同步时,如果遇到日志打印“Capturing structure of table”后很久才开始同步数据的问题,可能是由于以下几个原因导致的。以下是详细的分析和解决方法:

Flink CDC通过Oracle的LogMiner工具读取Redo Log或Archive Log来捕获变更数据。在初始化阶段,LogMiner需要解析表结构并加载相关元数据,这可能会导致延迟。

优化LogMiner配置:

ARCHIVELOG模式已启用,并且Redo Log文件大小适中(建议至少200MB)。_logminer_session_min_memory参数以增加LogMiner会话的内存分配,从而提升解析效率。减少表结构复杂度:

Flink CDC在同步Oracle数据时,通常会先进行全量数据同步,然后再切换到增量同步。如果表中数据量较大,全量阶段可能需要较长时间。

分批次同步数据:

scan.incremental.snapshot.enabled=true参数启用增量快照功能,将全量数据分批次读取,避免一次性加载过多数据。source:

type: oracle

hostname: <hostname>

port: 1521

username: <username>

password: <password>

tables: <schema>.<table>

scan.incremental.snapshot.enabled: true

调整并行度:

parallelism),以加速全量数据的读取和处理。如果Flink作业运行环境的CPU、内存或网络带宽不足,可能导致日志解析和数据同步速度变慢。

检查资源分配:

优化网络连接:

如果Oracle表结构发生了变更(如新增列),但下游未及时同步,可能导致Flink CDC在初始化阶段花费更多时间解析表结构。

手动触发表结构同步:

ignoreDelete=false以支持回撤更新。避免不兼容的表结构变更:

如果Flink CDC的日志级别设置为DEBUG或TRACE,可能会导致大量日志输出,影响性能。

INFO或WARN,减少不必要的日志输出。log4j.properties):log4j.logger.org.apache.flink=INFO

log4j.logger.com.ververica.cdc=INFO

针对“Capturing structure of table”日志打印后同步数据延迟的问题,您可以按照以下步骤逐一排查和优化: 1. 检查Oracle LogMiner配置,优化Redo Log解析效率。 2. 启用增量快照功能,分批次同步全量数据。 3. 增加Flink作业的资源分配,确保计算和网络性能充足。 4. 手动处理表结构变更,避免不兼容的DDL操作。 5. 调整日志级别,减少日志输出对性能的影响。

通过以上方法,可以有效缩短Flink CDC同步Oracle数据的初始化时间,提升同步效率。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。