"Flink日志里面显示也读到oracle表数据量了,但是就是没有数据,我sink使用的print连接器,没有print出数据来。

我更新使用了flinkcdc 3.0.1的jar包后就同步不到了。"

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink日志显示已成功读取Oracle表的数据量,但使用Print连接器时未输出数据,并且在更新到Flink CDC 3.0.1的JAR包后同步失败。以下是可能的原因分析及解决方案:

Flink作业中可能存在WHERE、JOIN或窗口等中间节点,导致数据被过滤掉。建议检查以下内容: - 确认Vertex拓扑图中的数据流动情况:查看每个计算节点的输入和输出数据量。如果某个节点(如WHERE)输入有数据但输出为0,则说明数据被该节点过滤。 - 检查SQL逻辑:确保SQL语句中没有过于严格的过滤条件,例如WHERE条件可能导致所有数据被过滤。

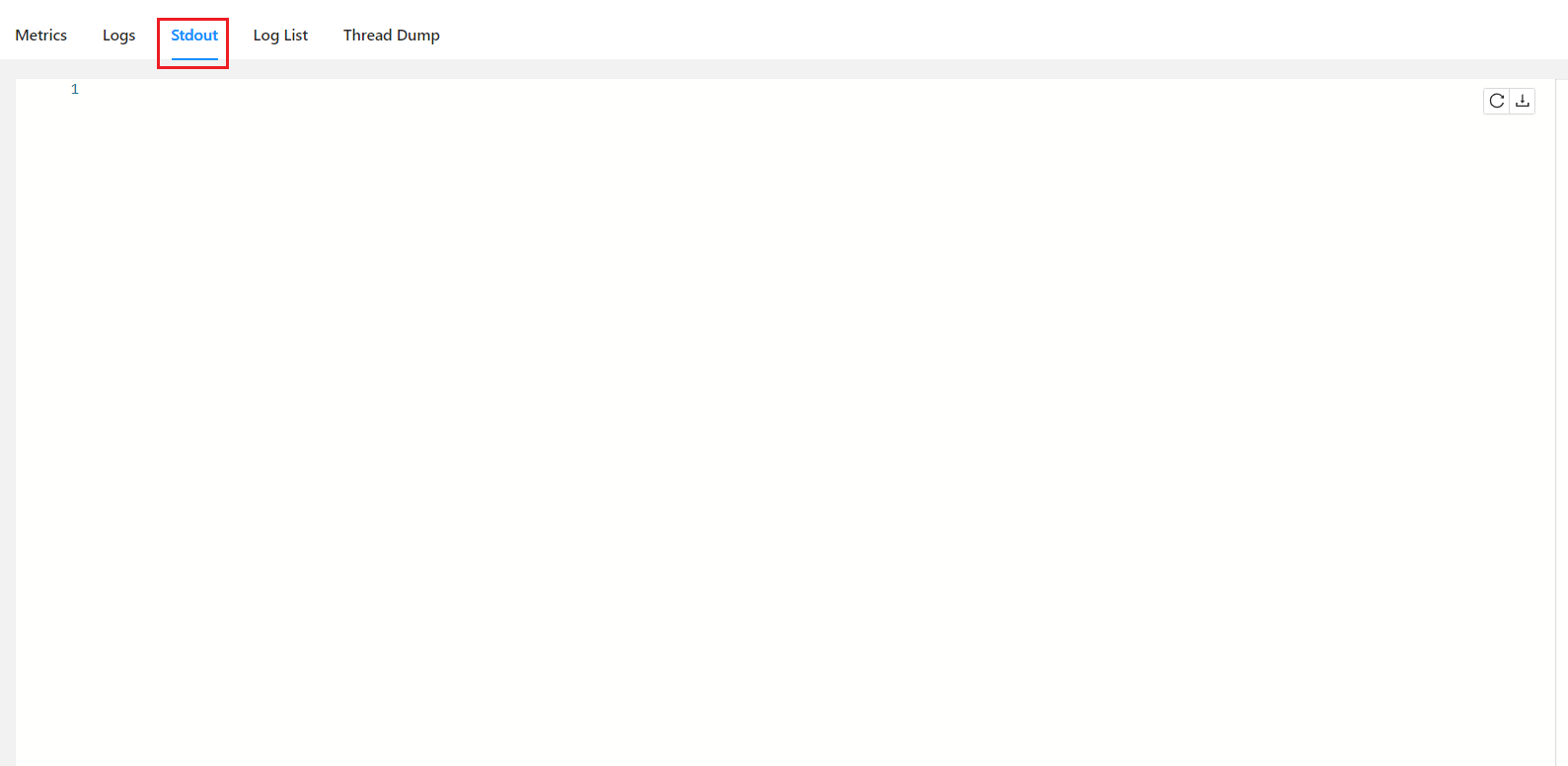

Print连接器需要正确配置才能输出数据。请检查以下配置项是否符合要求: - 日志级别设置:Print结果表的数据输出为Info日志,因此需要将日志级别调整为Info,否则无法查看到结果数据。 - logger参数:在Print连接器的WITH参数中,确保logger设置为true,以启用控制台显示数据结果。 - 数据条数限制:Print连接器默认最多打印2000条数据。如果数据量超过此限制,可能会导致部分数据无法显示。建议在WHERE条件中添加业务相关条件,缩小数据范围后再进行Print操作。

示例SQL配置:

CREATE TABLE print_sink (

name VARCHAR,

score BIGINT

) WITH (

'connector' = 'print',

'logger' = 'true'

);

更新到Flink CDC 3.0.1后同步失败,可能是由于以下原因: - 版本兼容性问题:Flink CDC 3.0.1可能与当前使用的Flink版本或其他依赖库不兼容。建议检查Flink CDC官方文档,确认其支持的Flink版本范围。 - Schema变更问题:如果Oracle表的Schema发生了变更(如字段类型或名称变化),可能导致数据无法正确解析。建议检查DDL语句和物理表中的Schema是否一致。 - 乱序数据处理:Flink CDC 3.0.1可能对乱序数据的处理方式有所调整。如果源表中存在乱序数据,可能导致数据被丢弃。可以通过Print Sink或Log4j确认是否存在乱序数据,并合理设置Watermark策略。

如果作业为多并发,可能存在以下问题: - 个别并发无数据流入:如果某些并发没有数据流入,会导致Watermark始终为1970年0点0分,从而无法触发窗口结束。建议检查上游Vertex拓扑图的Subtask并发是否有数据流入,并调整作业并发数小于等于源表Shard数。 - Kafka分区无数据:如果使用Kafka作为源表,某些分区可能无数据流入,影响Watermark生成。建议检查Kafka各分区的数据分布情况。

NullPointerException且无详细错误栈,可以在运维中心 > 作业运维页面的部署详情页签中添加以下参数以获取完整错误信息:

env.java.opts: "-XX:-OmitStackTraceInFastThrow"

Info,并正确设置logger参数。如果以上方法仍无法解决问题,请提供更多上下文信息(如SQL语句、配置参数、日志片段等),以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。