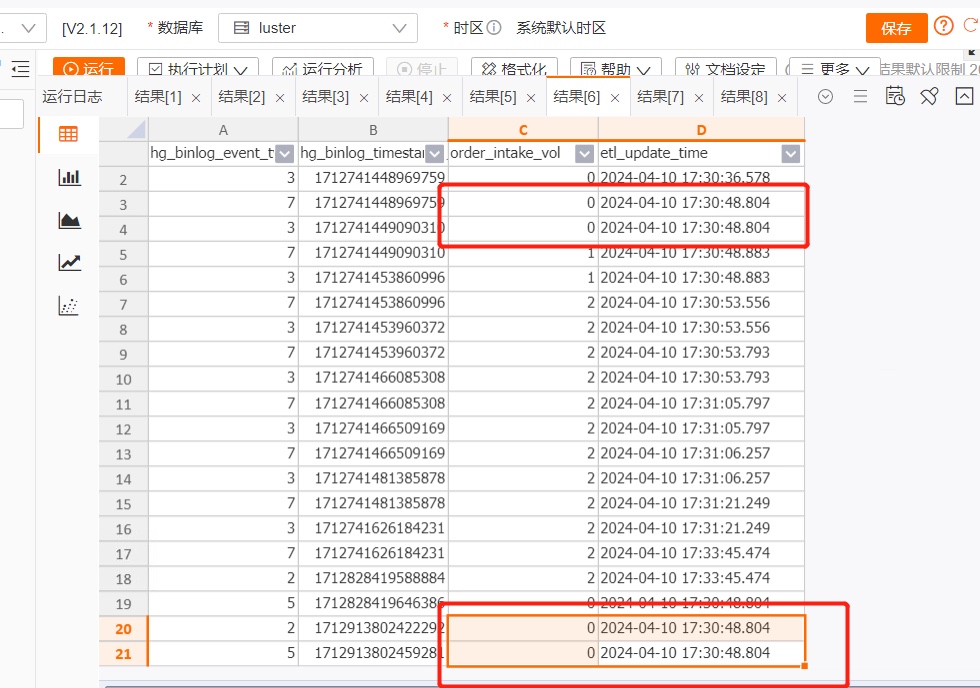

Flink的sink表中,有的处理时间比较早的结果数据晚于处理时间较晚的数据插入结果表,导致结果表数据异常,怎么回事?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink的Sink表中,如果处理时间较早的结果数据晚于处理时间较晚的数据插入结果表,导致结果表数据异常,这通常是由于Changelog事件乱序问题引起的。以下是详细的原因分析和解决方案:

Changelog事件乱序

Flink在处理流式数据时,会生成一系列的Changelog事件(如INSERT、UPDATE、DELETE)。这些事件可能由于以下原因出现乱序:

SinkUpsertMaterializer的作用

为了处理Changelog事件乱序问题,Flink引入了SinkUpsertMaterializer机制。它通过维护一个RowData列表来确保数据按正确的顺序写入结果表。然而,如果未正确配置或使用该机制,可能会导致状态过大或性能下降。

参数配置不当

如果table.exec.sink.upsert-materialize参数设置为'FORCE',即使结果表的DDL未指定主键,优化器也会强制插入SinkUpsertMaterializer状态节点。这可能导致不必要的状态膨胀和性能开销。

在定义结果表时,确保主键的唯一性约束未被破坏。例如:

CREATE TABLE performance_report (

student_info STRING NOT NULL PRIMARY KEY NOT ENFORCED,

avg_score DOUBLE NOT NULL

) WITH (...);

避免对主键列进行运算(如拼接或多列合并),以防止丢失唯一性约束。

如果需要对主键列进行转换,建议在上游算子中完成,并确保转换后的字段仍能保持唯一性。

table.exec.sink.upsert-materialize参数auto:Flink会根据数据流的特性自动推断是否需要添加SinkUpsertMaterializer。如果作业可以生成正确的输出,建议保持默认值。none:如果确认数据流中不存在乱序问题,可以将参数设置为none,避免使用SinkUpsertMaterializer,从而减少状态开销。force:仅在明确需要强制处理乱序时使用,但需注意可能带来的性能影响。SinkUpsertMaterializer,建议为状态设置合理的TTL(Time-To-Live),以避免状态持续增长。例如:

SET 'table.exec.state.ttl' = '1h';

需要注意的是,TTL设置过短可能导致脏数据残留,而设置过长则会增加状态存储的压力。

SinkUpsertMaterializer的状态过大并影响性能,可以通过增加作业并发度来缓解。例如:

SET 'parallelism.default' = '4';

CURRENT_TIMESTAMP、NOW)生成列,因为这可能导致SinkUpsertMaterializer的状态异常膨胀。状态清理警告:如果消息的DELETE事件与其ADD事件之间的时间间隔超过配置的TTL,Flink会在日志中产生如下警告信息:

LOG.info(STATE_CLEARED_WARN_MSG);

这表明部分脏数据可能未被正确清理,需检查TTL配置是否合理。

版本兼容性:确保使用的Flink版本支持上述参数和功能。例如,实时计算引擎VVR 6.0及以上版本支持更灵活的TTL配置。

通过以上措施,可以有效解决Flink Sink表中因Changelog事件乱序导致的结果表数据异常问题。如果问题仍未解决,建议进一步检查数据流的上下游逻辑,确保数据的一致性和顺序性。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。