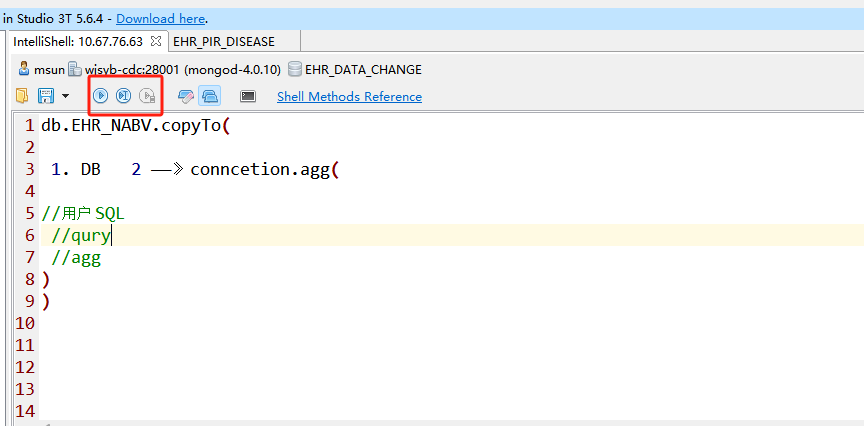

Flink中mongo 的connection 必须指定 conn.agg() conn.find() 才能执行并返回对应结果 有什么方法像 jdbc哪种的吗 conn.excute( sql) 的方式 达成这种通用查询的方式吗?

类似这种 可以随意写然后就统一执行 目前java api 只能先指定查询方式

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink中,连接MongoDB时需要指定MongoDB的连接信息,包括主机名、端口号、数据库名称等。与JDBC类似,Flink提供了MongoDB Connector来连接和操作MongoDB数据库。

以下是使用Flink MongoDB Connector连接MongoDB的示例代码:

java

复制代码运行

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.connectors.mongodb.MongoSink;

import org.apache.flink.streaming.connectors.mongodb.MongoSource;

import org.apache.flink.streaming.connectors.mongodb.config.MongoConfigUtil;

import org.apache.flink.streaming.connectors.mongodb.config.MongoConnectionOptions;

import org.apache.flink.streaming.connectors.mongodb.config.WriteConcern;

import org.apache.flink.streaming.util.serialization.KeyedSerializationSchemaWrapper;

// 创建MongoDB连接配置

MongoConnectionOptions connectionOptions = MongoConfigUtil.createConnectionOptions(

"mongodb://localhost:27017", // MongoDB连接字符串

"myDatabase", // 数据库名称

null, // 用户名(可选)

null // 密码(可选)

);

// 创建MongoDB源

MongoSource mongoSource = MongoSource.builder()

.setCollection("myCollection") // 集合名称

.setConnectionOptions(connectionOptions)

.setDeserializer(new SimpleStringSchema()) // 反序列化器

.build();

// 创建MongoDB目标

MongoSink mongoSink = MongoSink.builder()

.setConnectionOptions(connectionOptions)

.setCollectionName("myCollection") // 集合名称

.setWriteConcern(WriteConcern.UNACKNOWLEDGED) // 写入策略

.setSerializer(new KeyedSerializationSchemaWrapper<>(new SimpleStringSchema())) // 序列化器

.build();

上述代码中,我们首先创建了一个MongoConnectionOptions对象,用于指定MongoDB的连接信息。然后,通过MongoSource和MongoSink类分别创建了MongoDB的源和目标。在源中,我们使用了SimpleStringSchema作为反序列化器,将读取到的数据转换为Java字符串类型。在目标中,我们使用了KeyedSerializationSchemaWrapper包装了SimpleStringSchema作为序列化器,将数据转换为适合写入MongoDB的格式。

请注意,上述代码仅为示例,您需要根据实际情况进行适当的修改和调整。另外,确保您的项目中包含了Flink MongoDB Connector的相关依赖项。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。